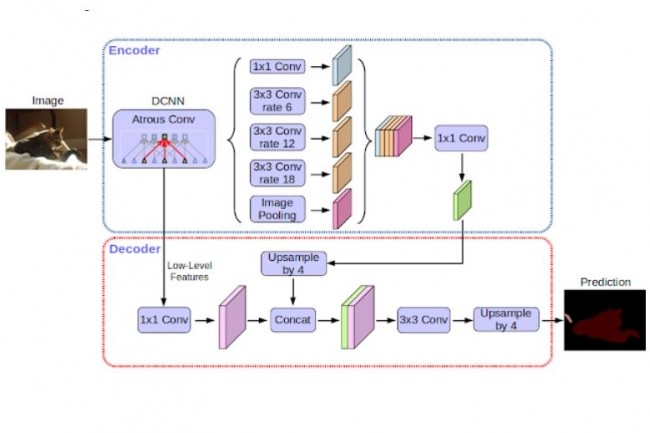

La classification d'images est une tâche fondamentale de l'intelligence artificielle qui consiste à attribuer une ou plusieurs étiquettes prédéfinies à une image numérique, en fonction de son contenu visuel. Elle repose principalement sur des algorithmes d'apprentissage automatique et d'apprentissage profond (deep learning), capables d'extraire des caractéristiques pertinentes des images pour les distinguer les unes des autres. La classification d'images se distingue de la détection d'objets ou de la segmentation d'images en ce qu'elle vise uniquement à catégoriser l'ensemble de l'image, sans localiser précisément les objets à l'intérieur ou segmenter les différentes régions. Son fonctionnement implique généralement l'utilisation de réseaux de neurones convolutifs (CNN), qui apprennent à identifier des motifs visuels hiérarchiques. Cette technologie permet de créer des systèmes capables de reconnaître automatiquement des objets, des scènes ou des anomalies dans des images.

Cas d'usages et exemples d'utilisation

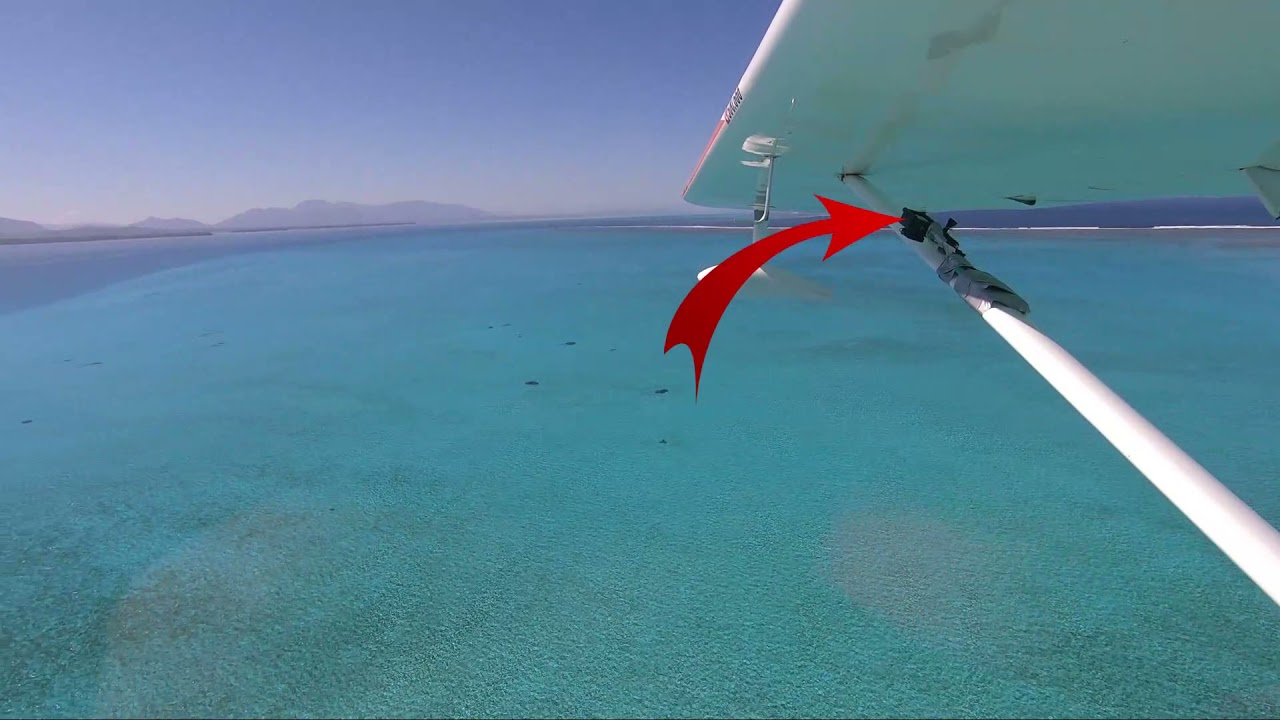

La classification d'images trouve des applications variées, notamment dans la reconnaissance de visages pour la sécurité, le diagnostic médical assisté par IA (analyse d'images radiologiques), le tri automatique de photos, la surveillance industrielle (détection de défauts), ou encore la gestion de contenu sur les réseaux sociaux (modération d'images). Elle est également employée dans l'agriculture de précision pour identifier des maladies sur les plantes, ou dans l'automobile pour la reconnaissance de panneaux de signalisation.

Principaux outils logiciels, librairies, frameworks, logiciels

Les librairies et frameworks couramment utilisés incluent TensorFlow, PyTorch, Keras, scikit-learn, FastAI et OpenCV. Ces outils offrent des modules dédiés à la construction, l'entraînement et l'évaluation de modèles de classification d'images. Pour les cas avancés, on utilise des réseaux pré-entraînés comme ResNet, Inception, VGG, ou EfficientNet.

Derniers développements, évolutions et tendances

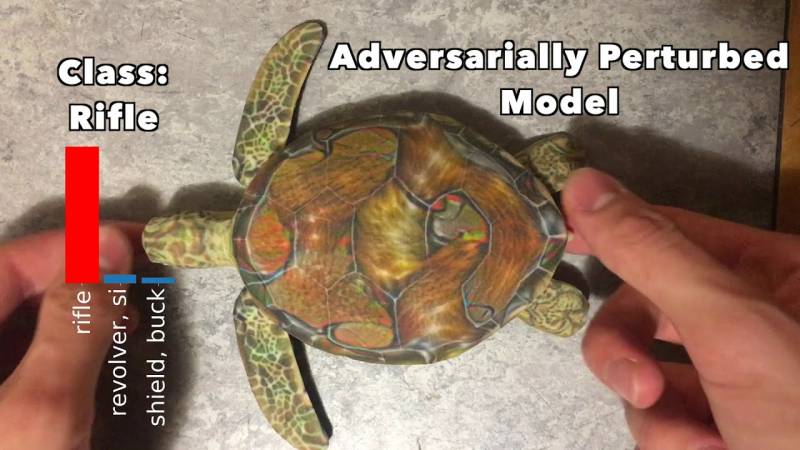

Les recherches récentes portent sur l'efficacité des architectures de type Transformer (Vision Transformers, ViT), l'apprentissage auto-supervisé, la réduction de la taille des modèles pour les applications embarquées, et l'amélioration de la robustesse face aux biais et aux attaques adverses. Par ailleurs, l'annotation automatique et l'apprentissage semi-supervisé permettent de réduire la dépendance à de grands jeux de données annotés, facilitant l'élargissement des cas d'applications.