Fin janvier dernier, alors que tout le monde avait les yeux rivés sur DeepSeek et son modèle R1, Mistral AI introduisait discrètement Small 3, annonçant l'arrivée prochaine de modèles Mistral avec des capacités de raisonnement améliorées. C'est chose faite : après Small 3.1 présenté en mars dernier, la licorne vient de dévoiler Magistral, son premier modèle de raisonnement à grande échelle, disponible en deux variantes, l'une open source "Magistral Small", l'autre orientée entreprise," Magistral Medium".

Avec Magistral, Mistral AI franchit une nouvelle étape. Non pas dans la course à la taille, mais dans la quête d’une IA plus explicable, plus ancrée dans le raisonnement humain, et surtout, plus adaptée aux réalités opérationnelles des entreprises. Le nouveau modèle s'appuie sur les avancées de Small 3.1, prend en charge de nombreuses langues, dont l’anglais, le français, l’espagnol, l’allemand, l’italien, l’arabe, le russe et le chinois simplifié. Il met en œuvre une chaîne de raisonnement explicite, étape par étape, qui peut être suivie, interrogée et auditable dans la langue de l’utilisateur.

Magistral Small

Mistral AI a publié Magistral Small sous licence Apache 2.0, permettant ainsi à la communauté de l'utiliser, l'affiner et la déployer pour divers cas d'utilisation. Il est téléchargeable sur https://huggingface.co/mistralai/Magistral-Small-2506 .

Cette version a été optimisée grâce à un fine-tuning supervisé (SFT) basé sur les traces de raisonnement générées par Magistral Medium lors de ses interactions puis renforcée par apprentissage (RLHF) pour affiner la qualité et la cohérence du raisonnement.

Comptant, comme les modèles Small 3, 24 milliards de paramètres, Magistral Small, une fois quantifié, peut être déployé sur des configurations matérielles accessibles, comme un PC fonctionnant avec un seul GPU RTX 4090 ou un Mac avec une mémoire RAM de 32 Go, ce qui permet aux développeurs de garder le contrôle sur leurs données sensibles sans dépendre d'une infrastructure cloud centralisée.

Magistral Medium

Cette variante est la déclinaison entreprise de Magistral. Plus puissant, il est disponible sur la plateforme Le Chat de Mistral et via l’API de l’entreprise. Actuellement déployé sur Amazon SageMaker, il le sera prochainement sur IBM WatsonX, Azure AI et Google Cloud Marketplace.

Selon la licorne, Flash Answers dans le Chat permet de réduire drastiquement la latence des réponses. D'après elle, Magistral Medium atteint une vitesse de traitement jusqu’à 10 fois supérieure à celle de nombreux concurrents.

Les performances de Magistral

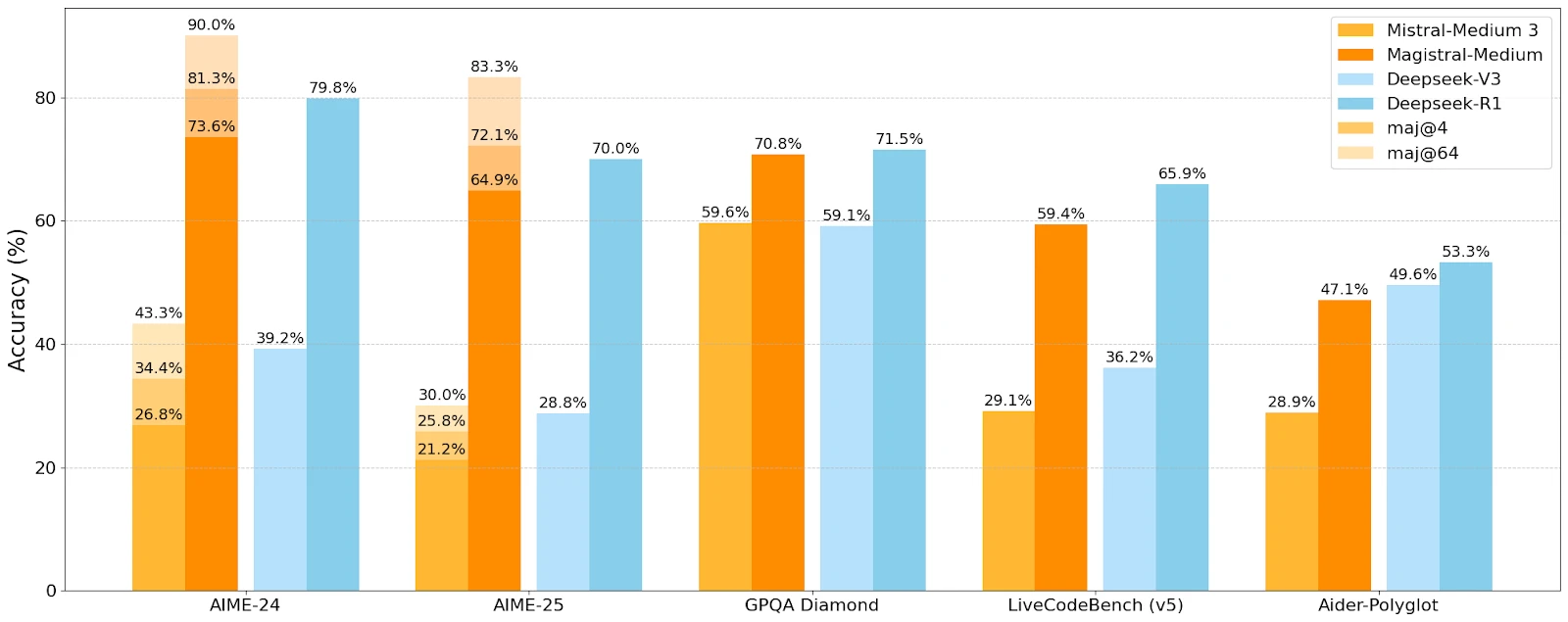

Mistral AI a comparé les performances de Magistral avec celles de Mistral Medium et des modèles concurrents de DeepSeek sur différents benchmarks de raisonnement et de compréhension.

Magistral-Medium surpasse Mistral-Medium 3 sur tous les benchmarks, prouvant l’efficacité du raisonnement amélioré. Sur les benchmarks AIME 2024, Medium atteint un score de 73,6 % avec 90 % de vote majoritaire, contre 70,7 % et 83,3 % pour Small, Des résultats compétitifs, même si Deepseek conserve une avance sur certains benchmarks.

Des cas d’usage bien ciblés

Mistral AI vise des cas d’usage où la réflexion étape-par-étape est déterminante :

-

Prise de décision stratégique

-

Recherche juridique

-

Prévision financière

-

Développement logiciel multi-étapes

-

Rédaction narrative et génération de contenus

-

Analyse réglementaire et conformité

Cette diversité suggère une volonté de pénétrer à la fois les secteurs réglementés et les métiers techniques à forte densité cognitive, sans sacrifier l’ouverture vers des usages plus “créatifs”.