En bref : La mission internationale "ICHIBAN" menée par l'agence spatiale allemande (DLR) et l'agence japonaise d'exploration aérospatiale (JAXA) a réussi à faire communiquer et coopérer deux robots d'assistance aux astronautes à bord de l'ISS. Cette prouesse, qui ouvre des perspectives pour les interactions robotiques en environnement orbital, est une avancée majeure en vue des futures missions lunaires et martiennes.

L’agence spatiale allemande (DLR) et l'Agence japonaise pour l'exploration aérospatiale (JAXA) annoncent que la mission de coopération internationale "ICHIBAN" a été couronnée de succès. Pour la première fois, deux robots d’assistance aux astronautes issus de programmes nationaux distincts ont communiqué et coopéré en orbite à bord de l'ISS.

L'un des objectifs de la mission ICHIBAN (première en japonais,) qui s'est achevée le 29 juillet dernier, était de tester la coordination de plusieurs robots distincts opérant simultanément et en temps réel à bord de l’ISS.

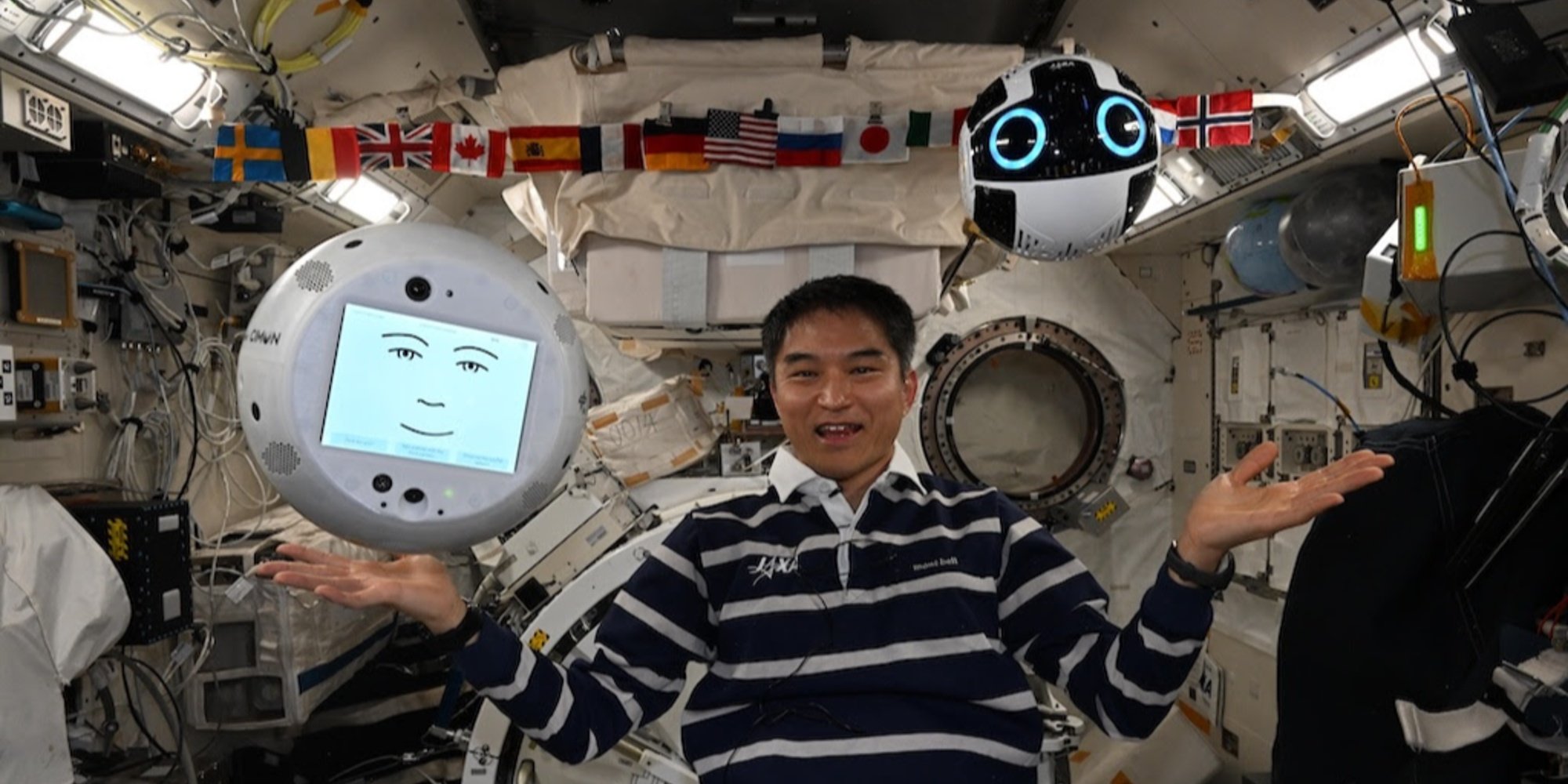

Les deux robots impliqués dans l'expérience sont CIMON, développé par le DLR, Airbus et IBM ainsi qu'Int-Ball2, conçu par la JAXA, installés respectivement dans les modules d'expérimentation européen Columbus et japonais Kibo.

Déployé pour la première fois en 2018, CIMON (Crew Interactive Mobile Companion) est un robot sphérique, de la taille d'un ballon, imprimé en 3D, propulsé par les technologies vocales et cognitives de watsonx, la plateforme IA d’IBM. Durant la mission ICHIBAN, CIMON a été opéré par BIOTESC, le centre suisse de l’ESA spécialisé dans les opérations scientifiques à bord de la station internationale.

De son côté, Int-Ball2 est une évolution du premier drone caméra de la JAXA. Intégré depuis 2023 dans le module japonais, il permet à la cellule de contrôle au sol à Tsukuba (Japon) de filmer à distance les activités des astronautes, optimisant ainsi la documentation scientifique sans mobiliser l’équipage de la station spatiale internationale. Jusqu’ici, aucune capacité d’interaction avec d’autres robots n’avait été envisagée.

La démonstration a été menée par Takuya Onishi, astronaute de la JAXA à bord de l’ISS. Du module Columbus, il a transmis des commandes vocales à CIMON, qui a servi d’interface linguistique intelligente. L’instruction a été traitée par la plateforme watsonx d’IBM, avant d’être traduite en commandes opérationnelles adressées à Int-Ball2.

Ce dernier a alors navigué dans le module Kibo pour chercher et localiser divers objets cachés : un Rubik’s Cube, un marteau, plusieurs tournevis, et une ancienne version d’Int-Ball mise hors service. Il a ensuite transmis les images en direct à l’écran de CIMON, permettant à Onishi de vérifier visuellement leur position à distance.

Crédit : JAXA/DLR;

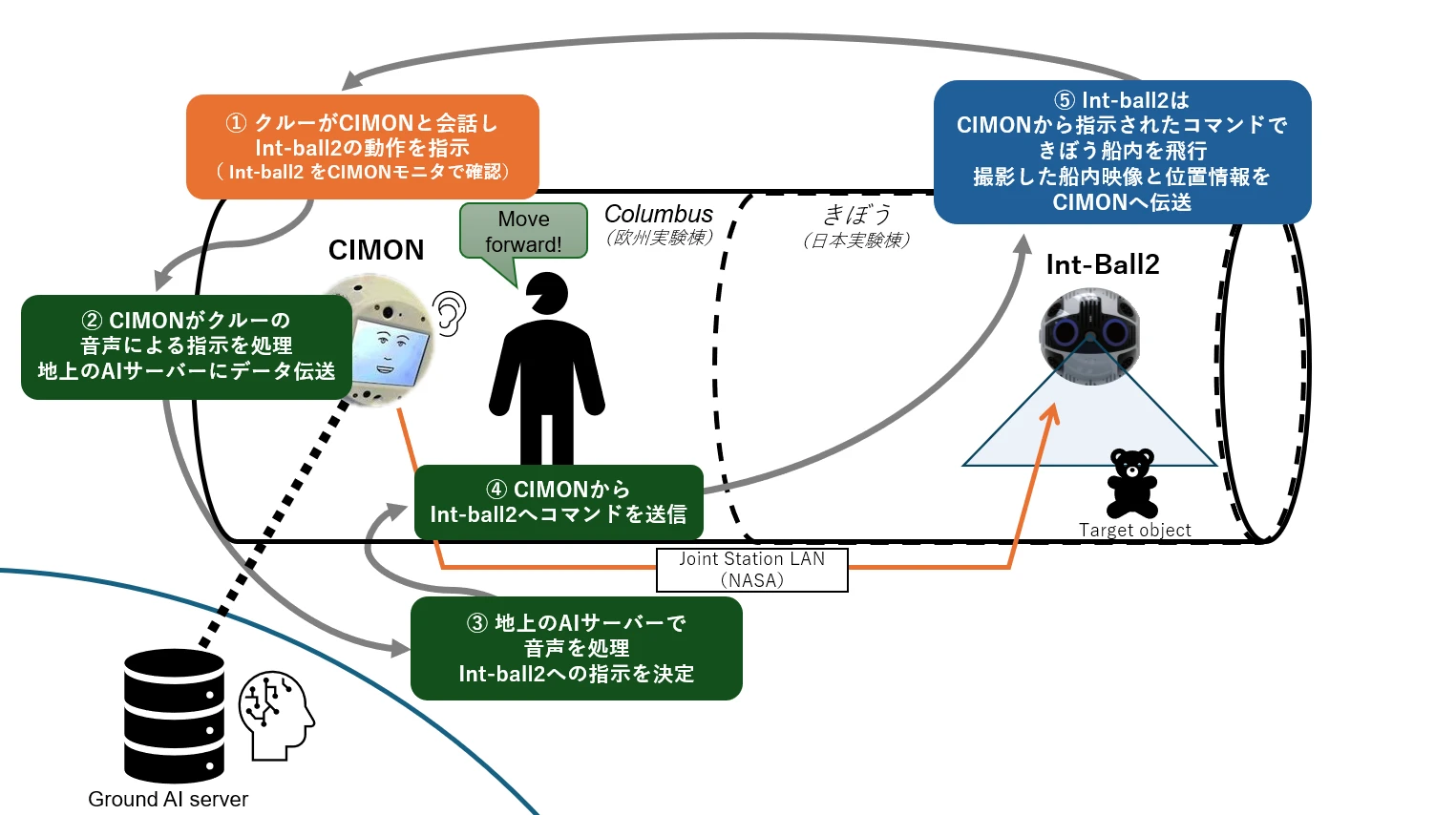

Illustration Tableau de collaboration de la mission ICHIBAN

Illustration Tableau de collaboration de la mission ICHIBAN

L'astronaute donne une instruction vocale à CIMON pour qu'Int-Ball2 effectue une tâche (étape ①). CIMON transmet cette commande vocale à un serveur d’IA situé au sol, qui analyse l’intention de la commande (étapes ② et ③). Retour d’instruction vers l’ISS : une fois traitée, la commande est renvoyée depuis le sol via le LAN de la station (Joint Station LAN/NASA) à CIMON, qui la transmet à Int-Ball2 (étape ④). Celui-ci agit en conséquence dans le module japonais "Kibo", effectue sa tâche (par exemple localiser un objet), puis renvoie les images et données de position à CIMON.

L’innovation réside dans le fait que, jusqu’alors, les images capturées par Int-Ball2 ne pouvaient être transmises qu’au centre de contrôle de Tsukuba. La possibilité de les envoyer en temps réel à un autre robot à bord ouvre un nouveau champ pour les interactions robotiques distribuées en environnement orbital.

Une première étape qui prend toute son importance à l'aune des futures missions lunaires et martiennes.