L’équation entre performance et durabilité est l’un des grands défis de l’intelligence artificielle. Alors que de nombreux projets s’appuient sur des modèles de grande taille pour des tâches simples, générant des coûts élevés et une consommation énergétique importante, Aramis-2B s’inscrit dans la dynamique croissante autour des Small Language Models (SLM). Développé par Jonathan Pacifico, Data Scientist chez Cellenza, ce modèle open weights constitue une étape supplémentaire dans la recherche d’un compromis entre puissance de raisonnement, efficacité énergétique et intégration agentique.

Construit en post-training sur BitNet-b1.58-2B-4T de Microsoft Research, Aramis-2B tire parti de l'utilisation native de poids ternaires (-1, 0, +1) de ce dernier. Contrairement à la quantification a posteriori, cette approche permet de concevoir des modèles plus légers dès l’entraînement, avec une consommation énergétique jusqu’à 20 fois inférieure par token sur CPU, sans compromis sur la qualité des résultats.

Des capacités renforcées pour l’agentique

Jonathan Pacifico a orienté Aramis-2B vers les usages multi‑agents et l’interaction utilisateur en renforçant trois dimensions :

-

les capacités de raisonnement ;

-

la compréhension du langage et du contexte ;

-

le suivi d'instructions sur plusieurs tours de dialogue.

La méthode mobilisée combine un fine-tuning DPO bilingue (FR/EN) et un model merging itératif. Cette démarche permet de stabiliser les performances tout en conservant la diversité des atouts acquis à chaque cycle d’entraînement.

Des résultats probants

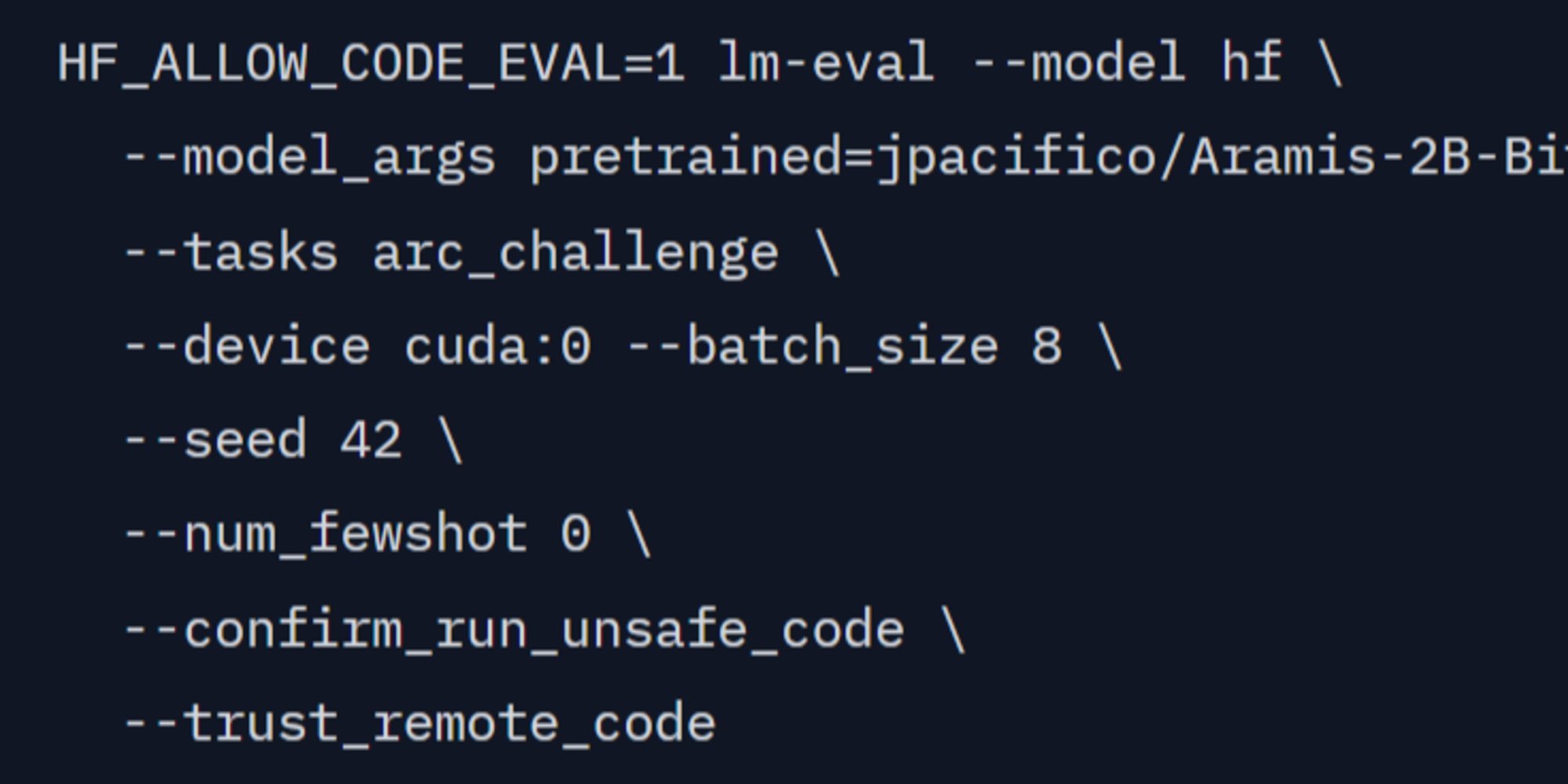

Sur ARC-Challenge, référence en matière de raisonnement scientifique, Aramis-2B atteint 51,62 en zéro-shot, franchissant le seuil symbolique des 50 points, une première pour un modèle open source de moins de 2,5 milliards de paramètres. Il dépasse non seulement son modèle de base, mais également plusieurs concurrents récents de même catégorie, tels qu’IBM Granite, DeepSeek, Qwen ou MiniCPM. Des progrès notables sont également observés sur IFEval, Winogrande, TriviaQA et MMLU.

Le modèle est publié en open weights sur Hugging Face, en deux formats :

-

GGUF (1.58-bit), optimisé pour l’inférence avec bitnet.cpp ;

-

BF16, destiné au réentraînement.

Jonathan Pacifico invite la communauté à tester Aramis-2B et à lui faire part de ses retours

Retrouvez Aramis-2B sur Hugging Face