Egalement dans l'actualité de l'intelligence artificielle

© Net Square Digital 2019-2022

Hugging Face, spécialiste des Transformers et éditeur de la célèbre librairie éponyme lance en français un cours en ligne d’apprentissage des techniques au cœur des dernières innovations en matière d’intelligence artificielle. Proposant à la fois des librairies très largement ad...

Les featured snippets sont les petits résumés que propose Google en réponse à une question fréquemment posée par les internautes. Le 11 août dernier, Google a présenté une innovation pour améliorer leur qualité : la société va utiliser MUM, (Multitask Unified Model) son algorithm...

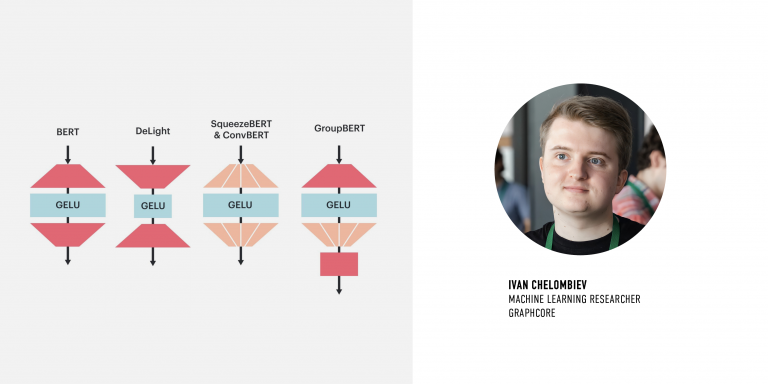

Aujourd’hui, le modèle BERT est l’un des plus populaires et polyvalents dans le domaine de l’IA. Cependant, le fait qu’il implique des opérations denses signifie que la précision et la flexibilité qui le distinguent ne s’obtiennent qu’en contrepartie de coûts élevés en calcul. En...

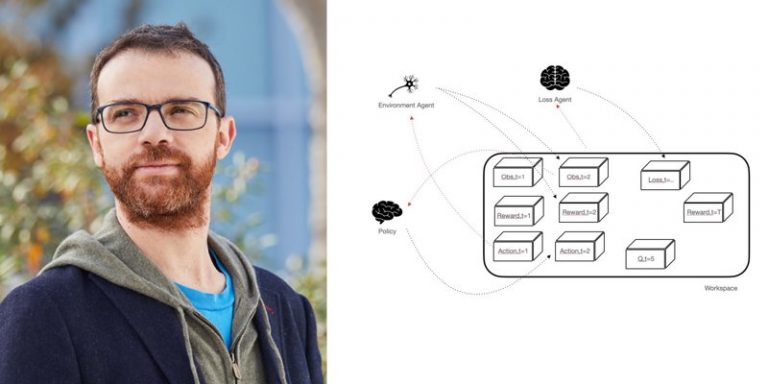

Le mois dernier, FAIR présentait SaLinA, une librairie légère utilisant notamment une approche basée sur des agents pour mettre en œuvre des modèles de décision séquentiels, y compris (mais pas seulement) des algorithmes reinforcement learning. Pour en savoir plus, nous avons éch...

Graphcore a annoncé ce début de mois rejoindre le programme de partenariat de Hugging Face centré notamment sur les modèles optimisés et les intégrations logicielles. Cette collaboration permettra aux développeurs de déployer, à l’échelle de production et sur des IPU, des m...