Outre ses dernières puces d’IA basées sur l’architecture Blackwell, l’IA GROOT qui permettra d’entraîner les robots humanoïdes, NVIDIA a annoncé lors de la GTC 2024 toute une gamme de microservices d’IA générative de niveau entreprise basés sur la plateforme NVIDIA CUDA introduite en 2006. Regroupés dans la nouvelle plateforme NVIDIA AI Enterprise, ils doivent permettre aux organisations de créer et déployer des applications personnalisées en toute sécurité.

Les microservices NVIDIA sont des conteneurs logiciels téléchargeables pour le déploiement d’applications d’IA générative et le calcul accéléré. NVIDIA AI Enterprise 5.0 comprend NVIDIA NIM pour le déploiement de modèles d’IA en production et la collection de microservices NVIDIA CUDA-X.

NVIDIA NIM pour une inférence optimisée de l’IA

NIM (NeMo Inference Microservices) fournit des conteneurs prédéfinis alimentés par le logiciel d’inférence NVIDIA, notamment Triton Inference Server et TensorRT-LLM, qui permettent, selon NVIDIA, aux développeurs de réduire les temps de déploiement de plusieurs semaines à quelques minutes, que ce soit dans le cloud, les centres de données ou les stations de travail accélérées par ses GPU.

Pour rappel, NVIDIA NeMo est une boîte à outils d’IA conversationnelle conçue pour les chercheurs travaillant sur la reconnaissance vocale automatique, la synthèse texte-parole, les grands modèles de langage et le traitement du langage naturel. Elle fait partie d’AI Foundations, un ensemble de services cloud permettant aux entreprises de créer leurs propres modèles d’IA génératives à partir de leurs données, qu’ils soient linguistiques ou visuels, fonctionnant sur DGX Cloud, que NVIDIA a lancé il y a tout juste un an.

Elle comprend :

- NVIDIA NeMo Curator qui permet de générer des jeux de données de haute qualité pour l’entraînement LLM ;

- NVIDIA NeMo Customizer qui simplifie le réglage fin et l’alignement des modèles tout en accélérant les performances et l’évolutivité ;

- NVIDIA NeMo Evaluator qui fournit une évaluation automatique sur divers benchmarks académiques et personnalisés, offrant une évaluation rapide, facile et fiable des grands modèles de langage (LLM) et des RAG personnalisés.

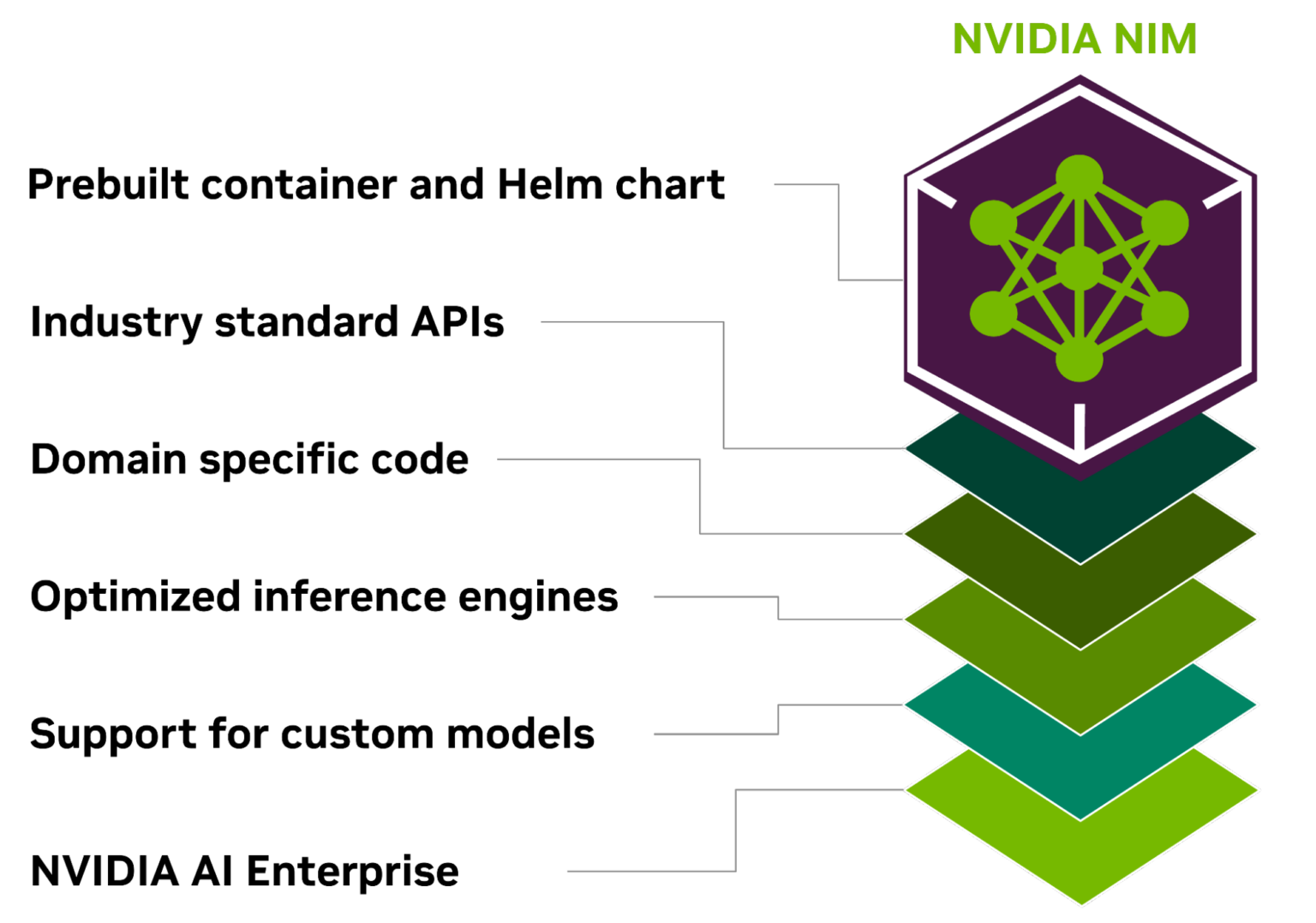

Crédit Nvidia. NVIDIA NIM est un microservice d’inférence conteneurisé comprenant des API standard, du code spécifique à un domaine, des moteurs d’inférence optimisés et un environnement d’exécution d’entreprise

Regroupant des bibliothèques NVIDIA CUDA spécifiques à un domaine et du code spécialisé adapté à divers domaines tels que le langage, la parole, le traitement vidéo, les soins de santé… Il permet le déploiement de modèles de NVIDIA, A121, Adept, Cohere, Getty Images et Shutterstock, ainsi que de modèles ouverts de Google, Hugging Face, Meta, Microsoft, Mistral AI et Stability AI.

Les développeurs peuvent les tester à l’aide d’API cloud du catalogue de NVIDIA ou les héberger eux-mêmes en téléchargeant NIM, puis les déployer avec Kubernetes sur les principaux fournisseurs de cloud ou sur site.

Selon NVIDIA, les clients pourront accéder aux microservices NIM d’Amazon SageMaker, de Google Kubernetes Engine et de Microsoft Azure AI, et s’intégrer à des frameworks d’IA populaires comme Deepset, Langchain et LlamaIndex.

Les microservices CUDA-X

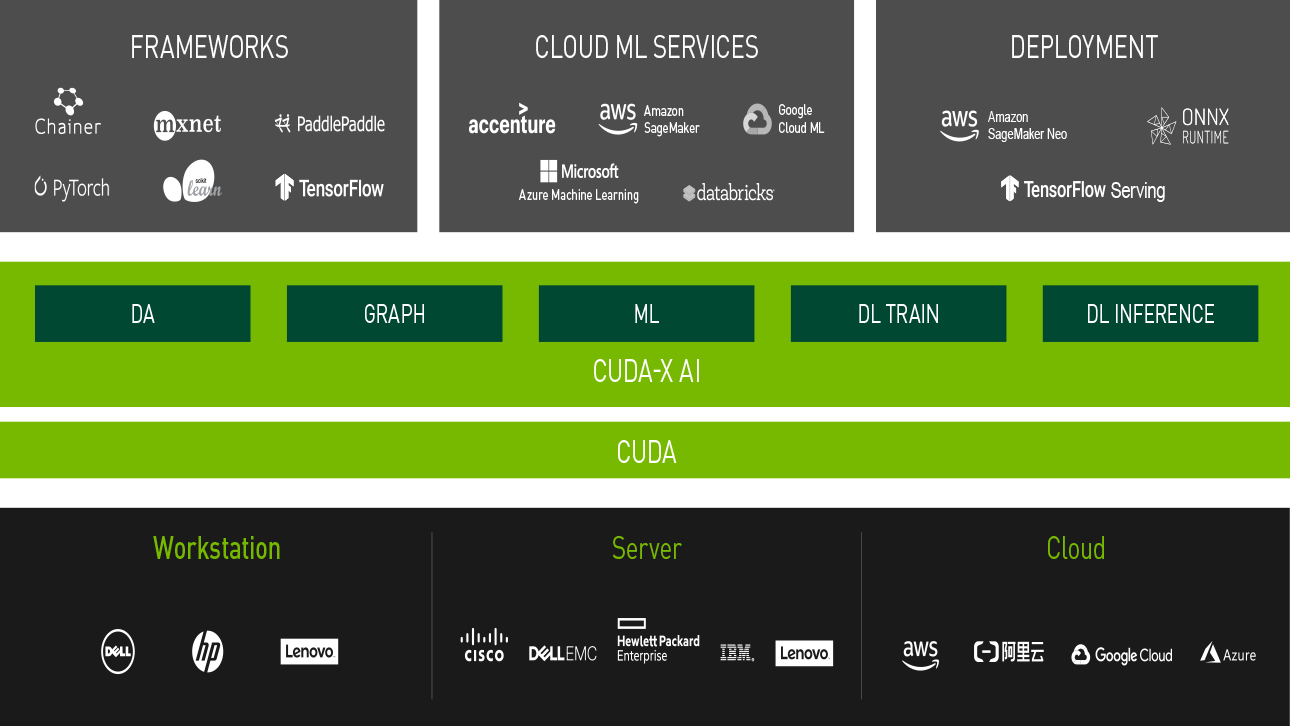

Conçus par les experts CUDA de NVIDIA, CUDA-X regroupe des outils de développement, des bibliothèques accélérées par GPU et des technologies packagées sous forme d’API cloud. Ses bibliothèques d’accélération logicielle font partie des principales plateformes cloud, notamment AWS, Microsoft Azure et Google Cloud et sont gratuites sous forme de téléchargements individuels ou de piles logicielles conteneurisées à partir de NVIDIA NGC.

Les développeurs peuvent les intégrer, les personnaliser et les déployer sur les GPU NVIDIA. CUDA-X AI est destiné aux applications de traitement de données et d’IA tandis que CUDA-X HPC contient des bibliothèques supplémentaires pour le calcul haute performance.

Les microservices CUDA-X incluent NVIDIA Riva pour l’IA vocale et de traduction personnalisable, NVIDIA Earth-2 pour les simulations climatiques et météorologiques haute résolution, NVIDIA cuOpt pour l’optimisation du routage et NVIDIA NeMo Retriever pour des capacités de génération augmentée (RAG) réactive pour les entreprises.

Les développeurs seraient aujourd’hui plus d’un million à les utiliser.