Meta a présenté récemment Toolformer, un modèle de langage qui apprend lui-même à utiliser divers outils de manière auto-supervisée. Le modèle a été formé pour décider quelles API appeler, quand les appeler, quels arguments transmettre et comment intégrer au mieux les résultats dans la prédiction future des jetons. L’article relatant leurs travaux intitulé « Toolformer : Language Models Can Teach Themselves to Use Tools » a été publié par arXiv le 9 février dernier.

Les modèles de langage (LM) montrent des capacités remarquables pour résoudre de nouvelles tâches à partir de quelques exemples ou instructions textuelles, en particulier à grande échelle. Ils ont aussi, paradoxalement, du mal avec les fonctionnalités de base, telles que la recherche arithmétique ou factuelle, où des modèles beaucoup plus simples et plus petits excellent.

Les chercheurs de Meta AI Research démontrent avec Toolformer qu’ils peuvent apprendre eux-mêmes à utiliser des outils externes via des API simples, améliorant considérablement les performances de tir zéro dans une variété de tâches en aval et surpassant des modèles beaucoup plus grands.

Surmonter les limitations des modèles de langage

Pour les chercheurs, le moyen simple de surmonter les limites des modèles linguistiques actuels est de leur donner la possibilité d’utiliser des outils externes tels que les moteurs de recherche, calculatrices ou calendriers.

Cependant, les approches précédentes reposaient sur de grandes quantités d’annotations humaines ou limitaient l’utilisation d’outils externes aux paramètres spécifiques de la tâche, entravant une adoption plus généralisée de l’utilisation d’outils dans le LM.

Leur modèle Toolformer n’a pas besoin d’une grande quantité d’annotations humaines, ce qui réduit considérablement les coûts. Les chercheurs disent n’avoir donné qu’une poignée d’exemples écrits par l’homme de la façon dont une API peut être utilisée, pour demander à un LM d’étiqueter un énorme jeu de données de modélisation du langage d’appels d’API potentiels.

Ils ont ensuite utilisé une perte auto-supervisée pour déterminer quels appels d’API pouvaient aider réellement le modèle à prédire les futurs jetons.

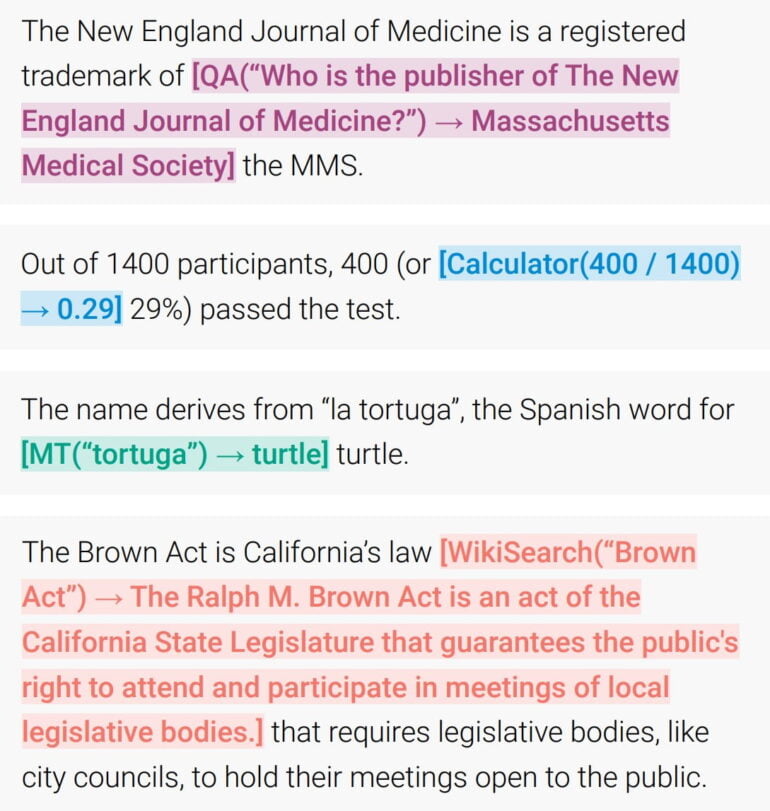

Exemples de prédiction d’API : le modèle décide de manière autonome d’appeler différentes API (de haut en bas : un système de réponses aux questions, une calculatrice, un système de traduction automatique et un Moteur de recherche Wikipédia) pour obtenir des informations qui sont utiles pour compléter un texte

Résultats

Toolformer a appelé une gamme d’outils, notamment une calculatrice, un système de questions-réponses, deux moteurs de recherche différents, un système de traduction et un calendrier. Il a amélioré considérablement les performances de tir zéro du Modèle GPT-J de paramètre 6.7B, a égalé ou surpassé un modèle GPT-3 beaucoup plus grand sur plusieurs

tâches en aval.

Référence :

“Language Models Can Teach Themselves to Use Tools” arXiv:2302.04761

Auteurs : Timo Schick, Jane Dwivedi-Yu, Roberto Dessì, Roberta Raileanu, Maria Lomeli, Luke Zettlemoyer, Nicola Cancedda, Thomas Scialom.