SIGGRAPH, la plus importante conférence mondiale sur l’infographie et les techniques interactives, se déroulera du 6 au 10 août prochain à Los Angeles et y célébrera ses 50 ans. NVIDIA y sera de nouveau présent et y présentera un nombre record de 18 articles de son laboratoire de recherche « NVIDIA Research » sur l’IA générative et le graphisme neuronal. Certains sont le fruit de collaborations avec plus d’une douzaine d’universités aux États-Unis, en Europe et en Israël.

NVIDIA Research compte des centaines de scientifiques et d’ingénieurs dans le monde entier, avec des équipes axées sur des sujets tels que l’IA, l’infographie, la vision par ordinateur, les voitures autonomes et la robotique.

Leurs innovations sont régulièrement partagées avec les développeurs sur GitHub et intégrées dans des produits, notamment la plate-forme NVIDIA Omniverse pour la construction et l’exploitation d’applications pour le métavers et NVIDIA Picasso, un service cloud présenté le mois dernier pour la création de modèles d’IA génératifs personnalisés pour la conception visuelle.

Des années de recherche graphique leur ont permis d’apporter un rendu de style film aux jeux, comme Cyberpunk 2077 Ray Tracing: Overdrive Mode, l’un des jeux les plus avancés technologiquement, utilisant plusieurs techniques de ray tracing, lancé le 11 avril dernier.

Les avancées de la recherche présentées à SIGGRAPH 2023 permettront aux développeurs et aux entreprises de générer rapidement des données synthétiques pour alimenter les mondes virtuels utilisés dans la robotique et la formation des véhicules autonomes. Elles permettront également aux créateurs d’art, d’architecture, de conception graphique, de développement de jeux et de films de produire plus rapidement des visuels de haute qualité pour le storyboard, la prévisualisation et même la production.

Des modèles de synthèse d’image personnalisés

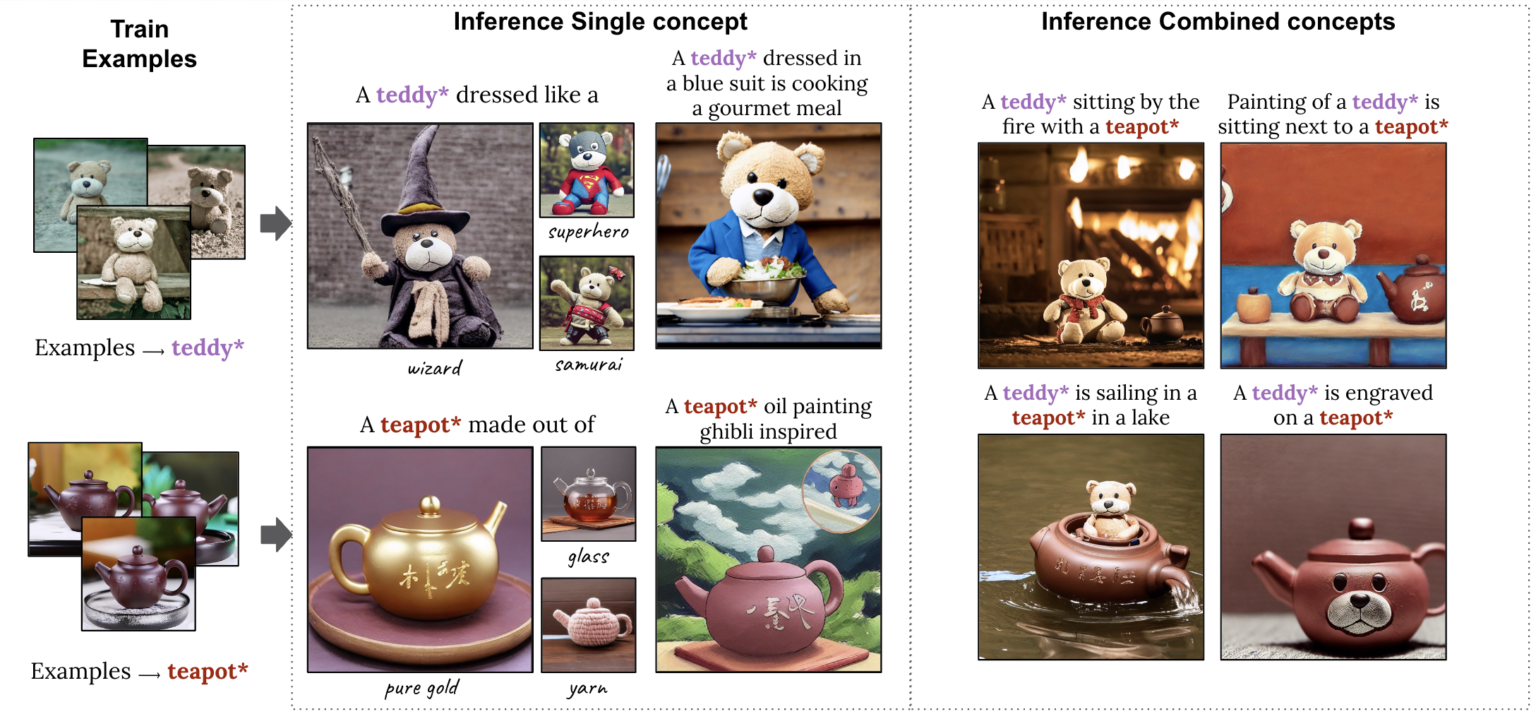

Les modèles text-to-image peuvent transformer une invite comme “jouets pour enfants” en une infinité de visuels dont un créateur peut s’inspirer, générant par exemple des images d’animaux en peluche, de blocs ou de puzzles.

Certains d’entre eux peuvent avoir des attentes plus précises. Dans son blog, NVIDIA cite l’exemple d’un directeur créatif pour une marque de jouets désirant planifier une campagne publicitaire autour d’un nouvel ours en peluche et voulant visualiser le jouet dans différentes situations, comme un thé d’ours en peluche. Pour permettre ce niveau de spécificité dans la sortie d’un modèle d’IA générative, des chercheurs de l’Université de Tel Aviv et de NVIDIA ont produit deux articles SIGGRAPH qui permettent aux utilisateurs de fournir des exemples d’images dont le modèle apprend rapidement.

Le premier décrit une technique qui nécessite un seul exemple d’image pour personnaliser sa sortie, accélérant le processus de personnalisation de quelques minutes à environ 11 secondes sur un seul GPU NVIDIA A100 Tensor Core, plus de 60 fois plus rapide que les approches de personnalisation précédentes.

Le second présente un modèle très compact appelé Perfusion, qui prend une poignée d’images conceptuelles pour permettre aux utilisateurs de combiner plusieurs éléments personnalisés – tels qu’un ours en peluche spécifique et une théière, en un seul visuel généré par l’IA.

Représentation en 3D : avancées dans le rendu inverse et la création de personnages

NVIDIA Research a développé des techniques d’IA pour transformer automatiquement les images et vidéos 2D en représentations 3D que les créateurs peuvent importer dans des applications graphiques pour un montage ultérieur.

Un troisième article écrit avec des chercheurs de l’Université de Californie à San Diego et de l’Université Stanford présente une méthode pour générer et rendre un modèle 3D photoréaliste de la tête et des épaules à partir d’un seul portrait 2D. C’est une percée majeure selon NVIDIA, qui rend la création d’avatars 3D et la vidéoconférence 3D accessibles avec l’IA. La méthode fonctionne en temps réel sur un bureau grand public, et peut générer une téléprésence 3D photoréaliste ou stylisée en utilisant de simples webcams ou des caméras de smartphone.

Un quatrième projet en collaboration avec l’Université de Stanford, apporte un mouvement réaliste aux personnages 3D. Les chercheurs ont créé un système d’IA capable d’apprendre une gamme de compétences de tennis à partir d’enregistrements vidéo 2D de vrais matchs de tennis et d’appliquer ce mouvement à des personnages 3D. Les joueurs de tennis simulés peuvent frapper la balle avec précision pour cibler des positions sur un court virtuel, et même jouer des rallyes prolongés avec d’autres personnages.

Au-delà du cas test du tennis, cet article SIGGRAPH aborde le défi difficile de produire des personnages 3D capables d’exécuter diverses compétences avec des mouvements réalistes, sans utiliser de données de capture de mouvement coûteuses.

Pas un cheveu déplacé : la physique neuronale permet des simulations réalistes

Superposer des détails réalistes tels que les cheveux à un personnage 3D est un défi complexe et coûteux en calcul, ce qui explique pourquoi les personnages virtuels d’un film à gros budget affichent des cheveux beaucoup plus détaillés que les avatars de jeux vidéo en temps réel.

Un cinquième article présente une méthode capable de simuler des dizaines de milliers de cheveux en haute résolution et en temps réel en utilisant la physique neuronale, une technique d’IA qui enseigne à un réseau neuronal à prédire comment un objet se déplacerait dans le monde réel.

Le rendu neuronal apporte des détails de qualité cinématographique aux graphiques en temps réel

Des recherches récentes de NVIDIA montrent comment les modèles d’IA pour les textures, les matériaux et les volumes peuvent fournir des visuels photoréalistes de qualité cinématographique en temps réel pour les jeux vidéo et les jumeaux numériques.

Dans un sixième article SIGGRAPH, NVIDIA présentera la compression de texture neuronale qui offre jusqu’à 16 fois plus de détails de texture sans prendre de mémoire GPU supplémentaire et peut augmenter considérablement le réalisme des scènes 3D.

Un article connexe annoncé l’année dernière est maintenant disponible en accès anticipé sous le nom de NeuralVDB, une méthode de compression de données basée sur l’IA qui diminue de 100 fois la mémoire nécessaire pour représenter les données volumétriques, comme la fumée, le feu, les nuages et l’eau.

NVIDIA a également publié ce 2 mai plus de détails sur la recherche sur les matériaux neuronaux qui a été présentée lors de sa dernière keynote. L’article décrit un système d’IA qui apprend comment la lumière se reflète à partir de matériaux photoréalistes à plusieurs couches, réduisant la complexité de ces actifs à de petits réseaux neuronaux fonctionnant en temps réel, permettant un ombrage jusqu’à 10 fois plus rapide.

Le niveau de réalisme peut être constaté dans cette théière rendue neuronale, qui représente avec précision la céramique, la glaçure imparfaite de la couche transparente, les empreintes digitales, les taches et même la poussière.

Outre ses 18 articles de recherche, NVIDIA présentera également six cours, quatre conférences et deux démonstrations de technologies émergentes lors de la conférence, avec des sujets tels que le suivi de chemin, la téléprésence et les modèles de diffusion pour l’IA générative.

Pour en savoir plus sur tous les documents NVIDIA à SIGGRAPH.

références de l’article : blog AARON LEFOHN NVIDIA