Avec son GPU MI250X, AMD alimente certains des supercalculateurs les plus rapides au monde, notamment le supercalculateur LUMI d’EuroHPC et le système Frontier du Oak Ridge National Laboratory, le premier à avoir franchi la barrière exascale. Lors du CES 2023, Lisa Su, la CEO d’AMD, avait présenté l’APU Instinct MI300A comme “le tout premier GPU et CPU intégrés au monde pour les infrastructures de données”. À l’occasion de l’évènement “AMD Data Center and AI Technology Premiere“, elle a dévoilé le GPU Instinct MI300X, conçu pour l’IA générative et le HPC, ainsi que la plateforme Instinct.

Un APU (Accelerated Processing Unit) est un type de processeur qui intègre à la fois un CPU (Central Processing Unit) et un GPU (Graphics Processing Unit) sur une même puce. Contrairement aux configurations traditionnelles où le CPU et le GPU sont des composants distincts, l’APU combine ces deux unités de traitement en une seule unité, ce qui permet des performances graphiques améliorées et une meilleure gestion de l’énergie.

Instinct MI300A est un APU conçu pour les centres de données, il combine 24 cœurs CPU Zen 4 et un GPU CDNA 3 avec 128 Go de mémoire HBM, compte 146 milliards de transistors et 13 chiplets. Huit fois plus performant que le GPU MI250X et d’une efficacité énergétique 5 fois supérieure, il alimentera le supercalculateur El Capitan de plus de deux exaflops au Laboratoire National Lawrence Livermore du département de l’Énergie des États-Unis.

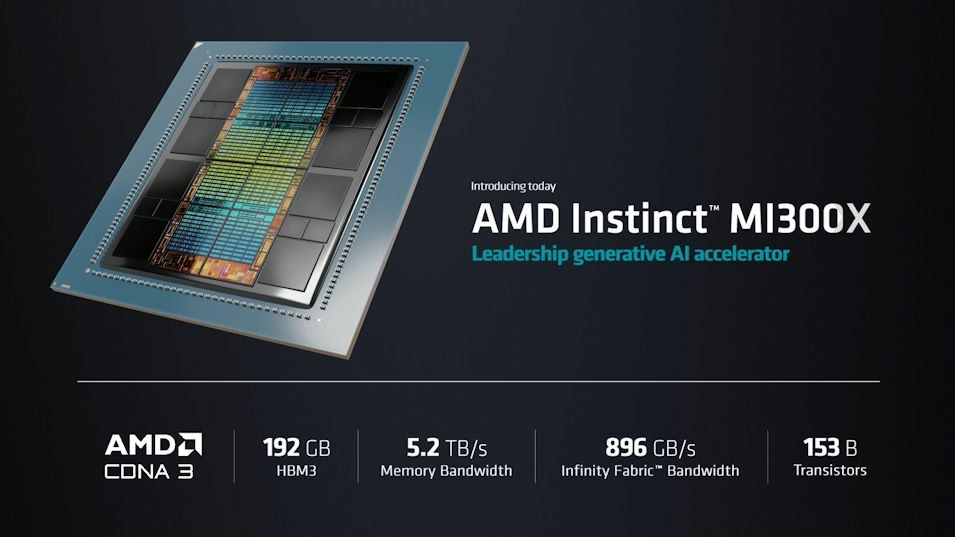

Le GPU Instinct 3100X pour entraîner les LLM et le HPC

Sa version optimisée pour l’entraînement des LLM et le HPC, Instinct MI300X, compte 153 milliards de transistors, 192 Go de mémoire HBM3 à large bande passante et 12 chiplets, AMD ayant remplacé les 3 CPU Zen 4 de MI300A par deux GPU CDNA 3. Le GPU dispose également d’une bande passante mémoire de 5,2 TB/s et de 896 Go/s de bande passante Infinity Fabric.

Lisa Su affirme :

“Notre utilisation des chiplets dans ce produit est très, très stratégique”.

Selon elle, Instinct MI300X fournira 2,4 fois plus de densité HBM et 1,6 fois plus de bande passante que le H100 de NVIDIA et est le premier GPU suffisamment puissant pour entraîner un LLM comme le Falcon 40B, le modèle d’IA open-source des Émirats arabes unis, développé par le Technology Innovation Institute. Ce qu’elle a démontré avec la génération d’un poème sur San Francisco.

Elle a affirmé :

“Avec plus de mémoire, plus de bande passante mémoire et moins de GPU nécessaires, nous pouvons exécuter plus de tâches d’inférence par GPU qu’auparavant. Pour les plus grands modèles, cela réduit en fait le nombre de GPU dont vous avez besoin, accélérant considérablement les performances, en particulier pour l’inférence, et réduisant le coût total”.

Ajoutant :

“Un seul MI300X peut exécuter des modèles jusqu’à environ 80 milliards de paramètres en mémoire”.

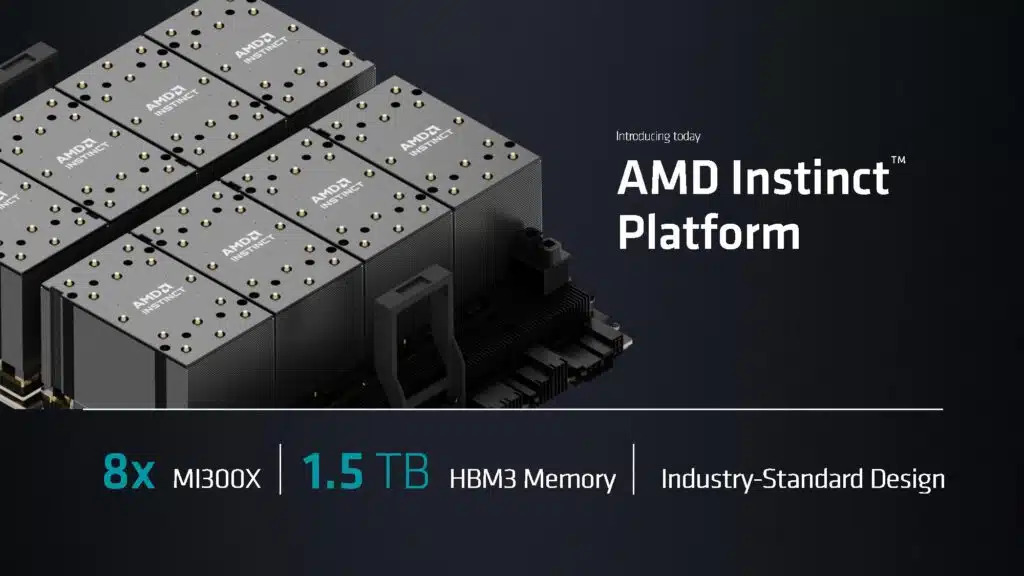

La plateforme Instinct

La CEO a également dévoilé la plateforme AMD Instinct qui réunit huit GPU MI300X sur une seule carte mère de serveur avec 1,5 To de mémoire HBM3. La conception de ce serveur est conforme aux normes et aux recommandations de l’Open Compute Platform.

Lisa Su commente :

“Les clients peuvent utiliser toute cette capacité de calcul d’IA en mémoire dans une plateforme standard de l’industrie qui s’intègre directement dans leur infrastructure existante”.