Nous avons consacré un dossier au rôle que l’IA peut jouer pour lutter contre le blanchiment d’argent dans le n°12 de notre magazine ActuIA, disponible sur notre boutique. Nous y avons vu que l’utilisation de l’IA permet de pallier les inconvénients et les limites des systèmes de lutte contre le blanchiment d’argent traditionnels basés sur des scénarios prédéfinis. Cet article de Fatoumata Dama propose d’approfondir le sujet.

Le blanchiment d’argent est le processus qui permet d’injecter des fonds illicites (générés par exemple par le trafic de stupéfiants ou le crime organisé) dans le système économique tout en dissimulant la provenance de ces fonds. Le blanchiment d’argent représente un enjeu financier colossal avec environ 2 à 5 % du PIB mondial blanchi chaque année à travers le monde. Outre l’enjeu financier, il fait également l’objet d’enjeux sécuritaires importants, non seulement à cause des activités illicites qui génèrent les fonds blanchis, mais également à cause de l’usage final de ces fonds tel que le financement du terrorisme. Pour toutes ces raisons, le blanchiment d’argent reçoit une attention particulière de la part des autorités économiques et judiciaires.

Les sanctions restent la meilleure arme de dissuasion à l’encontre des blanchisseurs. Cependant, l’identification des activités de blanchiment d’argent demeure une tâche complexe. Ainsi, diverses lois ont progressivement renforcé les obligations de vigilance et de surveillance des institutions financières (p. ex., banques, établissements de crédit, établissements de paiement et prestataires de services sur actifs numériques) en matière de lutte contre le blanchiment d’argent (LCB).

Afin de respecter leurs obligations légales, les institutions financières utilisent des dispositifs LCB capables de détecter les schémas dans les transactions qui sont indicatifs de blanchiment d’argent. Les dispositifs traditionnels, basés sur des règles prédéfinies, sont peu fiables (jusqu’à 95% de fausses alarmes, c’est-à-dire que seulement 5% des alarmes correspondent effectivement à des tentatives de blanchiment d’argent) et inflexibles. Dans ce contexte, les algorithmes d’IA représentent une opportunité pour la LCB en permettant la conception de dispositifs performants et flexibles (qui s’adaptent aux nouveaux schémas de blanchiment).

Cet article présente l’état de l’art relatif aux algorithmes d’IA, plus particulièrement les algorithmes de classification supervisée, utilisés dans le cadre de la LCB. Un algorithme de classification est dit supervisé lorsqu’il est entraîné sur des données labélisées correspondant aux exemples de transactions normales et de transactions illicites. Ces algorithmes sont donc entraînés à détecter les schémas de blanchiment d’argent similaires aux schémas connus identifiés dans le passé. Notre analyse s’appuie sur 23 études scientifiques réalisées entre 2010 et 2022. Ces études, présentées dans le tableau 1, considèrent chacune plusieurs algorithmes supervisés ou plusieurs variantes d’un même algorithme. Ensuite, ces algorithmes sont comparés entre eux sur un ou plusieurs jeux de données correspondant à des applications de la vie réelle.

Focus sur les données et les applications associées

De manière générale, les données sont indispensables à l’entraînement des algorithmes d’IA. Cependant, lorsqu’il s’agit de secteurs sensibles tels que la finance, les jeux de données disponibles pour les besoins de la recherche scientifique sont rares. Dans ces conditions, certaines études utilisent des données financières synthétiques comme alternatives aux données financières réelles, ou encore des données réelles issues de secteurs moins sensibles en complément aux données financières.

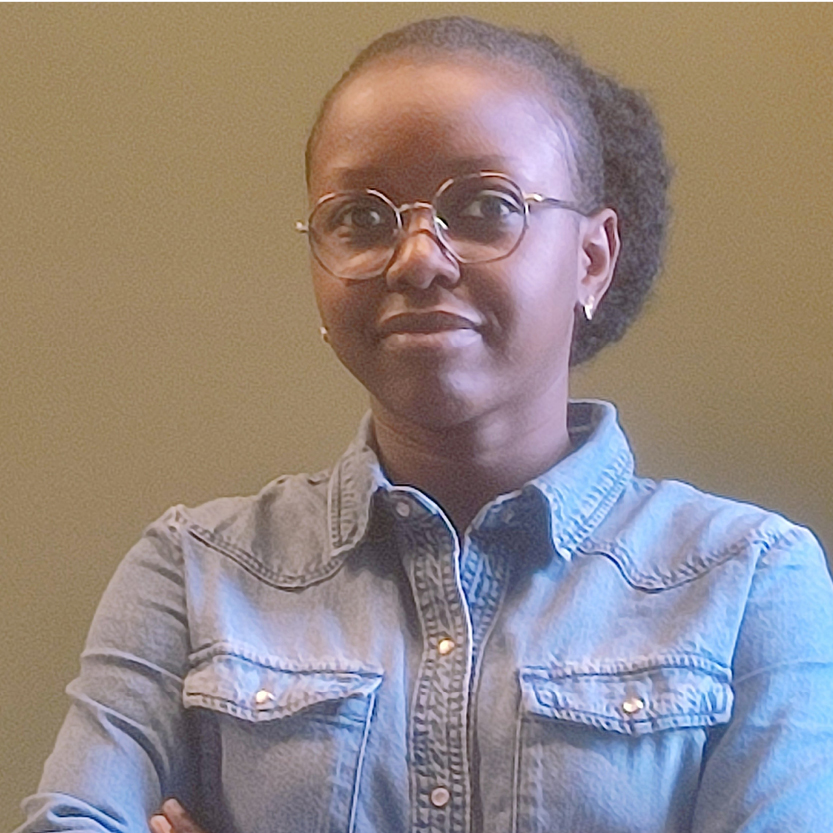

Dans les 23 études analysées ici, plusieurs types de données ont été considérés, comme présenté sur le graphique suivant.

La majorité des études adresse la problématique de la LCB dans le contexte du crypto-blanchiment, c’est-à-dire le blanchiment de fonds au travers de cryptoactifs tels que le Bitcoin ou l’Ether. L’intérêt de la communauté scientifique pour le crypto-blanchiment peut d’être expliqué par le fait que les données transactionnelles issues de la Blockchain sont plus facilement accessibles en comparaison aux données générées par les opérations bancaires traditionnelles. Par ailleurs, l’anonymat fourni aux utilisateurs fait de la cryptomonnaie un bon moyen de dissimulation de l’origine de fonds issus d’activités illégales. D’où l’intérêt d’analyser les transactions en cryptomonnaies afin d’identifier les comptes et transactions suspicieux, et lever l’anonymat des blanchisseurs.

En deuxième position, les données de transferts de fonds bancaires sont majoritairement utilisées. Il convient de noter que ces données sont souvent synthétiques en raison de la difficulté à obtenir des données réelles. Et lorsque les données sont réelles, elles sont également confidentielles et indisponibles à la communauté scientifique pour les besoins de reproductibilité, de validation et comparaison à l’état de l’art. En termes d’applications, les données de transferts de fonds bancaires sont analysées afin d’identifier les activités de blanchiment à l’échelle des comptes et à l’échelle des transactions.

Une seule étude porte sur la LCB dans l’industrie des jeux de hasard (Gamgling – étude 23). Et quatre études traitent le problème de la détection des fraudes financières différentes du blanchiment d’argent. On peut citer, par exemple, la détection des fraudes par carte de crédit (études 3, 6 et 23) et la détection des fraudes sur les marchés financiers (Stock – études 4).

Enfin, pour pallier le manque de données financières réelles, cinq études (études 2, 3, 5, 9 et 17) utilisent des données financières synthétiques tandis que trois études considèrent des données non financières (données météo – études 14 et 15 ; et données médicales – étude 23).

Les algorithmes d’IA utilisés dans la LCB

Les algorithmes d’IA utilisés dans le cadre de la LCB peuvent être répartis en deux grandes classes : les modèles de Machine Learning (ML) et les modèles de Deep Learning (DL).

Les modèles de ML

Le Machine Learning ou apprentissage machine est une sous-catégorie de l’intelligence artificielle qui regroupe les méthodes statistiques permettant de capturer automatiquement les patterns et les relations présents dans les données à des fins de description ou de prédiction d’un phénomène. Dans le cadre de la LCB, les algorithmes supervisés de ML suivants ont été considérés dans la littérature.

- Les arbres de décision (Decision Trees) : CART et C4.5

- Les classifieurs de gradient boosting : GBoost, XGB, LGBM, CatBoost, AXGB et ASXGB

- Les algorithmes d’ensemble à base d’arbre de décision : Random Forest, Extra Trees, Bagging classifier, AdaBoost et LogitBoost

- Les modèles probabilistes : Logistic Regression, Naive Bayes et Bayesian Belief Networks

- Autres modèles : SVM, KNN et RIPPER

Les modèles de DL

Le Deep Learning ou apprentissage profond désigne l’ensemble des algorithmes d’IA basés sur le cadre de travail des réseaux de neurones artificiels dont le but est de mimer le fonctionnement du cerveau humain. Dans la littérature, les modèles de DL suivants ont été utilisés dans la LCB :

- Le modèle Perceptron (MLP)

- Les modèles Auto-Encoder et Variationnal Auto-encoder

- Les graphes de réseaux de neurones (Graph Neural Network) : GNN, GCN, EvolveGCN et Skip-GCN et Inspection-L

Les modèles ML versus DL

À la différence des modèles de ML, les modèles de DL sont très opaques, ce qui leur vaut l’appellation de boîtes noires. Autrement dit, il est impossible pour un être humain d’interpréter la sortie de ces modèles, c’est-à-dire de comprendre le raisonnement suivi par le modèle pour arriver à un résultat final (appelé prédiction). Notons que l’interprétabilité est une propriété fondamentale des outils LCB dans la mesure où les institutions financières, pour des raisons de conformité et de transparence, sont ténues de documenter chaque signalement aux autorités compétentes avec les éléments d’analyse qui ont conduit à suspecter un client. Toutefois, les modèles de DL possèdent l’avantage d’être très flexibles en comparaison avec les modèles de ML. Ils présentent en conséquence une meilleure capacité de détection des schémas complexes de blanchiment d’argent

Fréquence de citation des algorithmes

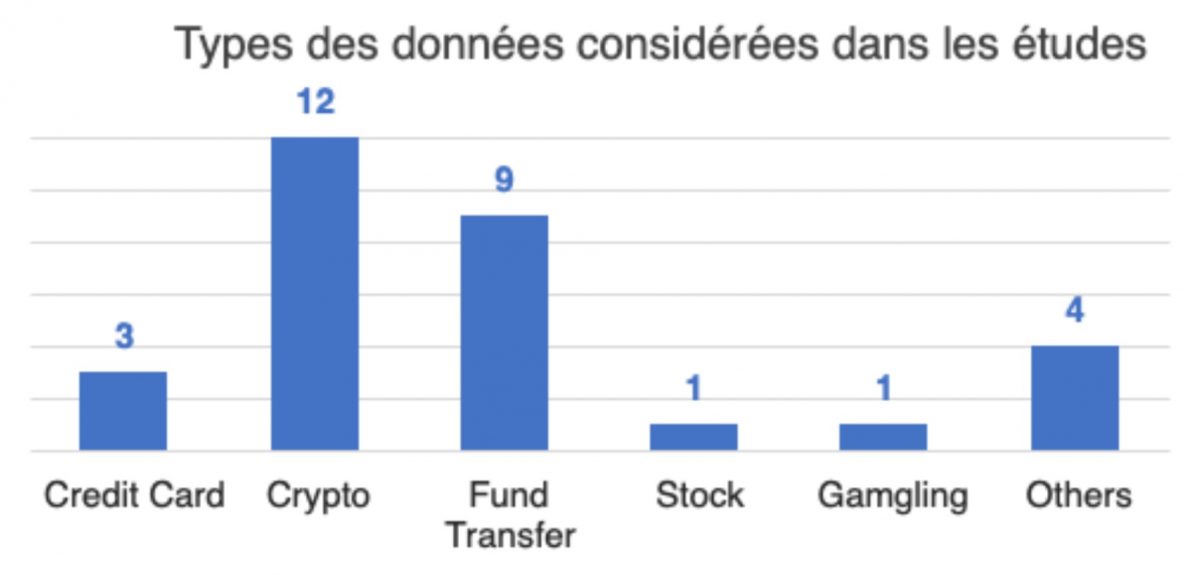

Parmi les 23 études analysées, chaque étude considère un sous-ensemble d’algorithmes (ou encore modèles) d’IA précédemment présentés (comme décrit dans le tableau 1). Le graphique suivant présente la fréquence de citation des algorithmes dans l’ensemble des études.

De manière générale, les modèles de ML (gradient boosting, modèles probabilistes, …) sont plus utilisés dans la LCB en comparaison avec les modèles de DL (MLP, GNN, auto-encoder, …). Ce constat peut être expliqué par deux facteurs, à savoir le facteur data et le facteur interprétabilité. En effet, la taille des jeux de données financières disponibles en accès libre est généralement insuffisante pour entraîner les modèles de DL. De plus, le manque d’interprétabilité des modèles de DL représente un frein à leur utilisation dans des applications sensibles telles que la LCB.

Remarquons l’utilisation majoritaire des modèles basés sur les arbres de décision (Decision Trees, Random Forest, Gradient Boosting, Bagging classifier, Extra trees, Adaboost et Logitboost) qui représentent plus de la moitié des citations. À l’instar des dispositifs LCB traditionnels, ces modèles utilisent des règles afin de déterminer le caractère normal ou suspect d’une transaction. Cependant, au lieu d’utiliser des règles prédéfinies (comme c’est le cas pour les dispositifs LCB traditionnels), ici, les règles sont construites par apprentissage automatique à partir de l’historique des données transactionnelles. Ainsi, la décision des modèles basés sur des arbres peut être interprétée en examinant les règles utilisées.

Performance des algorithmes

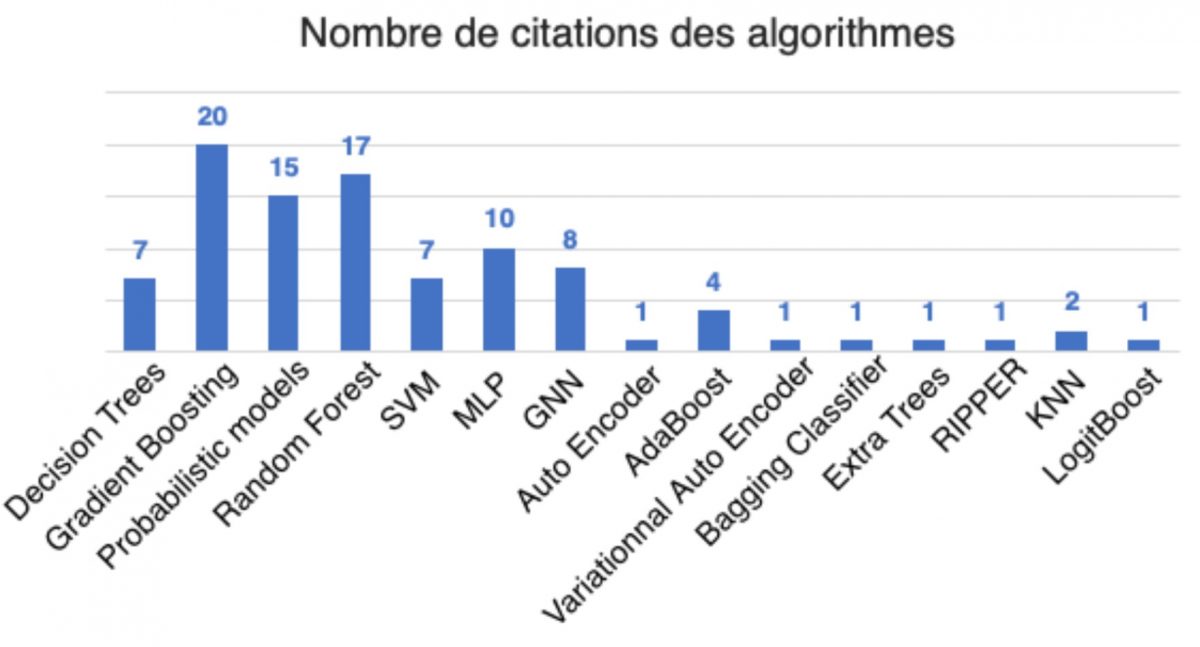

Il existe plusieurs métriques permettant d’évaluer la performance d’un algorithme de classification supervisée : la justesse, le score-F1, le score AUC, … Dans le cas spécifique des dispositifs LCB, l’accent est mis sur deux facteurs critiques :

- La fiabilité est la capacité pour un algorithme à détecter les tentatives de blanchiment. Elle est évaluée par le biais du rappel, calculé comme le ratio du nombre de vrais positifs (transactions frauduleuses effectives identifiées par l’algorithme) par rapport au nombre total de transactions frauduleuses.

- L’efficacité opérationnelle désigne la capacité d’un algorithme à minimiser le volume des fausses alarmes (i.e., le taux de faux positifs) et réduire par la même occasion le coût opérationnel lié au traitement manuel des alarmes. Cette métrique est mesurée au travers de la précision, définie comme le pourcentage de vrais positifs parmi les alarmes créées par l’algorithme (i.e., les fraudes identifiées par l’algorithme).

Le graphique suivant présente la moyenne et l’écart-type des scores de fiabilité et d’efficacité opérationnelle obtenus pour les algorithmes cités au minimum cinq fois dans l’ensemble des 23 études analysées. Notons que les expérimentations réalisées sur des données non financières n’ont pas été considérées.

Les résultats montrent que sur les études analysées, les algorithmes d’IA présentent un score d’efficacité opérationnelle moyenne entre 42% et 92%. Ces chiffres représentent une amélioration significative en comparaison avec les dispositifs LCB traditionnels qui génèrent jusqu’à 95% de fausses alarmes (soit une efficacité opérationnelle de seulement 5%). De plus, les transactions frauduleuses correspondant à du blanchiment d’argent sont détectées avec une fiabilité moyenne comprise entre 63% et 93%. Ces résultats donnent une idée du potentiel de l’IA en tant qu’outil de lutte contre le blanchiment d’argent.

Critique de l’état de l’art et perspectives

Plusieurs travaux de recherche ont abordé la problématique de l’utilisation de l’IA comme outils de détection et de lutte contre le blanchiment d’argent. Néanmoins, la littérature comporte principalement trois trous (gaps) ou aspects restant à couvrir.

La création de jeux de données de référence

La difficulté à obtenir des jeux de données financières (données transactionnelles et données clients) en qualité et quantité suffisantes constitue le principal frein au développement des dispositifs LCB basés sur l’IA. En effet, la très grande majorité des études (ici, 20 études sur les 23 études analysées) considère un unique jeu de données. De plus, ces jeux de données sont généralement confidentiels, rendant impossible la reproduction des résultats présentés dans les différentes études.

La création de jeux de données de référence permettrait non seulement de favoriser le développement de nouveaux algorithmes d’IA efficaces pour la LCB, mais aussi de faciliter l’évaluation et la comparaison des algorithmes existants. Ces données doivent donc pouvoir être analysées par les chercheurs sans risque de rupture de confidentialité pour les clients (i.e., divulgation d’informations sensibles sur les clients). Les jeux de données de référence peuvent être construits en appliquant des techniques d’anonymisation aux données financières (e.g., techniques de differential privacy) ; ou encore au moyen de modèles génératifs (e.g., Generative Adversarial Network – GAN) qui permettent de générer des données synthétiques réalistes reproduisant les caractéristiques importantes des données réelles.

L’évaluation de la performance de l’IA dans la LCB

Dans la littérature, les études évaluant la performance de l’IA dans la LCB considèrent seulement un certain nombre d’algorithmes souvent choisis arbitrairement. Parmi les 23 études que nous avons examinées, certains algorithmes (e.g., Auto Encoder, KNN et RIPPER) sont évalués dans seulement une ou deux études et sur un unique jeu de données. Par ailleurs, les conditions expérimentales diffèrent généralement d’une étude à une autre rendant difficile la comparaison des résultats.

Afin d’évaluer le potentiel de l’IA dans la LCB, des études comparatives exhaustives qui considèrent l’ensemble des algorithmes et des conditions expérimentales homogènes manquent dans la littérature.

De telles études permettraient d’identifier les forces et les faiblesses de chaque algorithme ou catégories d’algorithmes. Par ailleurs, l’utilisation d’un nombre important de jeux de données d’évaluation provenant de différentes sources (e.g., blockchain et données bancaires) permettrait d’obtenir des résultats généralisables.

L’interprétation de l’IA dans la LCB

Une IA est dite interprétable lorsque l’être humain est capable de comprendre les éléments clés conduisant l’IA à fournir un résultat donné. Par exemple, pourquoi l’IA conclut qu’une transaction est suspecte et qu’une autre ne l’est pas. À notre connaissance, la problématique de l’interprétation de l’IA dans le cadre de la LCB a été très peu abordée dans la littérature. Pourtant, l’interprétation de l’IA permettrait de faciliter le travail des analystes chargés d’examiner et documenter les alarmes et de réduire le délai de déclaration de soupçon, ce qui est essentiel pour que les banques restent conformes à la réglementation.

Conclusion

La lutte contre le blanchiment d’argent et le financement du terrorisme représente un enjeu économique et sécuritaire important à l’échelle mondiale. Les établissements financiers jouent un rôle central dans cette lutte notamment en respectant leurs obligations de vigilance et de surveillance des opérations réalisées dans leurs livres. Les dispositifs LCB standards utilisés à cet effet possèdent des limitations importantes en termes de fiabilité et d’efficacité opérationnelle. Pour pallier ces limitations, les algorithmes d’IA peuvent être utilisés. Plusieurs études ont montré le potentiel de l’IA à détecter les schémas de blanchiment d’argent avec une précision supérieure à celle obtenue par les dispositifs LCB standards ; et réduire en même temps le coût opérationnel de la surveillance des transactions.

Pour toutes ces raisons, les établissements financiers devraient mettre en place des projets test afin de concevoir de nouveaux algorithmes d’IA permettant de suivre l’évolution des pratiques et scénarios de blanchiment d’argent.

Références

Tableau 1 : Présentation des 23 études considérées. Pour chaque étude, les algorithmes testés et le nombre de jeux de données sont indiqués.

| Études | Algorithmes testés | Jeux de données |

| [1] | AdaBoost, Bagging Classifier, Extra Trees, GBoost, Random Forest, KNN | 1 |

| [2] | Decision Tree, SVM | 1 |

| [3] | MLP, CatBoost, Logisitic Regression, Naive Bayes, Random Forest | 1 |

| [4] | Decision Tree, Gradient Boosting, Logisitic Regression, Random Forest | 1 |

| [5] | MLP, Logisitic Regression, Random Forest, SVM | 1 |

| [6] | Decision Tree, SVM | 1 |

| [7] | AdaBoost, Decision Tree (CART, C4.5), Logisitic Regression, LogitBoost, Random Forest, Bayesian Belief Networks, MLP | 1 |

| [8] | MLP, Decision Tree, Logisitic Regression, Random Forest, SVM | 1 |

| [9] | SVM (avec différentes fonctions noyaux : linéaire, polynomial, sigmoid et RBF) | 1 |

| [10] | XGB (avec validation croisée et sélection d’hyperparamètres via une recherche par grille) | 1 |

| [11] | Random Forest, RIPPER, Bayes Network | 1 |

| [12] | MLP, Decision Tree, Logisitic Regression, Random Forest | 1 |

| [13] | GBoost, Logisitic Regression, Random Forest, KNN | 1 |

| [14] | ASXGB, AXGB, XGB, LGBM, CatBoost, Random Forest | 3 |

| [15] | ASXGB, AXGB, XGB, LGBM, CatBoost, Random Forest | 3 |

| [16] | XGB, Random Forest, MLP, GCN, Skip-GCN, EvolveGCN, Inspection-L | 1 |

| [17] | GNN, Random Forest, SVM | 1 |

| [18] | MLP, GCN, Skip-GCN, EvolveGCN, Logisitic Regression, Random Forest | 1 |

| [19] | AdaBoost, GBoost, Random Forest | 1 |

| [20] | Perceptron, MLP, AdaBoost, XGB, LGBM, SVM, Logisitic Regression | 1 |

| [21] | XGB (avec validation croisée et sélection d’hyperparamètres via une recherche par grille + une recherche aléatoire) | 1 |

| [22] | AutoEncoder, Variational AutoEncoder | 1 |

| [23] | MLP, Logistic Regession, Random Forest, XGB | 4 |

[1] Rtayli et al., 2020. Selection feature and support vector Machine for Credit Card Risk Identification

[2] Lokanan et al., 2022. Fraud prediction using machine learning – The case of investment advisors in Canada

[3] Lokanan 2022. Predicting Money Laundering using Machine and Artificial Neural Networks Algorithms in Banks

[4] Alarab et al., 2021. Comparative Analysis Using Supervised Learning

[5] Kumar et al., 2021. Analysis of Classifier Algorithms

[6] Sudjianto et al, 2010. Statistical Methods for Fighting Financial Crimes (ANN) (utilisation de scores comme features, baysiens belief network)

[7] Raiter et al., 2021. Supervised machine learning algorithms for fraud detection (ANN)

[8] Zhang et Trubey 2019. Machine Learning and Sampling Scheme: An Empirical Study of Money Laundering Detection (ANN)

[9] Pambudi et al., 2019. Improving Money Laundering Detection Using Optimized Support Vector Machine (SVM classifier, Random Under Sampling (RUS), Data mining)

[10] Farrugia and Azzopardi 2020. Detection of illicit accounts over the Ethereum blockchain (XGBOOST decision tree ensemble only, blockchain)

[11] Bartoletti et al., 2018. Data mining for detecting Bitcoin Ponzi schemes

[12] Badal-Valero et al., 2018. Combining Benfords Law and Machine Learning to detect Money Laundering. An actual Spanish court case

[13] Lorenz et al., 2020. Machine learning methods to detect money laundering in the Bitcoin blockchain in the presence of label scarcity

[14] Vassallo el al., 2021. Application of Gradient Boosting Algorithms for Anti‐money Laundering in Cryptocurrencies

[15] Bynagari et al., 2021. ANTI-MONEY LAUNDERING RECOGNITION THROUGH THE GRADIENT BOOSTING CLASSIFIER

[16] Weng Lo et al., 2022. Inspection-L – Self-Supervised GNN Node Embeddings for Money Laundering Detection in Bitcoin

[17] Bakhshinejad et al., 2022. A New Graph-Based Machine Learning Model For Anti-Money Laundering

[18] Weber et al., 2019_Anti-Money Laundering in Bitcoin – Experimenting with Graph Convolutional Networks for Financial Forensics

[19] Zola et al., 2019. Cascading Machine Learning to Attack Bitcoin Anonymity

[20] Lin et al., 2019. An Evaluation of Bitcoin Address Classification based on Transaction History Summarization

[21] Jullum et al., 2020. Detecting money laundering transactions with machine learning (XGBOOST only)

[22] Chen et al., 2021. Variational autoencoders and wasserstein generative adversarial networks for improving the anti-money laundering process

[23] Charitou et al., 2019. Synthetic Data Generation for Fraud Detection using GANs