“Assez grand”, c’est ainsi que Mistral AI a choisi d’intituler le communiqué présentant la deuxième génération de son modèle linguistique phare, le lendemain où Meta dévoilait ses modèles Llama 3.1. Par rapport à son prédécesseur, Mistral Large 2 est, selon la start-up, nettement plus performant en génération de code, en mathématiques et en raisonnement. Il fournit également une prise en charge multilingue beaucoup plus forte et des capacités d’appel de fonctions avancées.

Alors que le plus puissant modèle de la famille Llama 3.1 totalise 405 milliards de paramètres, Mistral Large 2 en compte 123. Avec une fenêtre contextuelle étendue à 128 000 jetons (32 000 pour Mistral Large) et un support pour plus de 80 langages de programmation, dont Python, Java, C, C++ et JavaScript, le modèle est conçu pour des applications complexes nécessitant une inférence à nœud unique et une gestion efficace des contextes longs. Il prend en charge des dizaines de langues, dont le français, l’allemand, l’espagnol, l’italien, le portugais, le néerlandais, le russe, le chinois, le japonais, le coréen, l’arabe et le hindi.

Il a été publié sous la licence Mistral Research License (MRL), permettant l’utilisation et la modification uniquement à des fins de recherche et d’utilisation non commerciale. Pour les utilisations commerciales nécessitant un auto-déploiement, une licence commerciale Mistral doit être acquise en contactant Mistral AI.

Génération de code et raisonnement

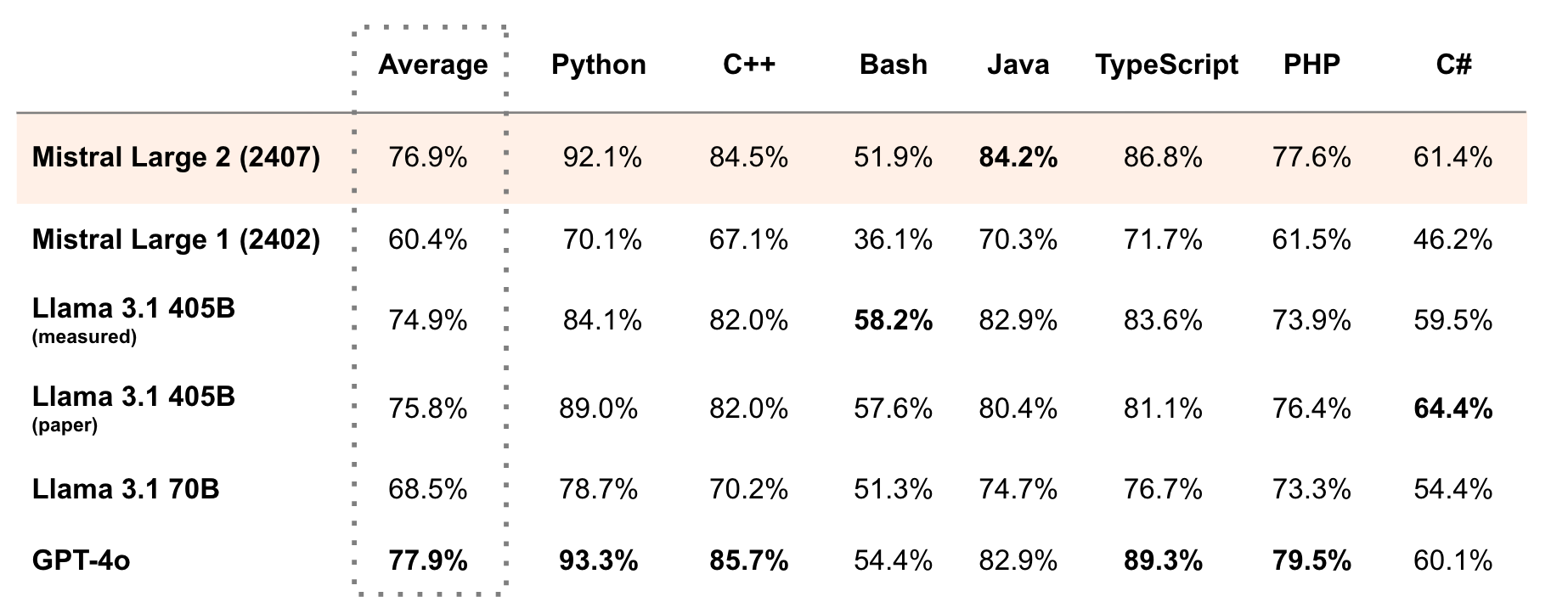

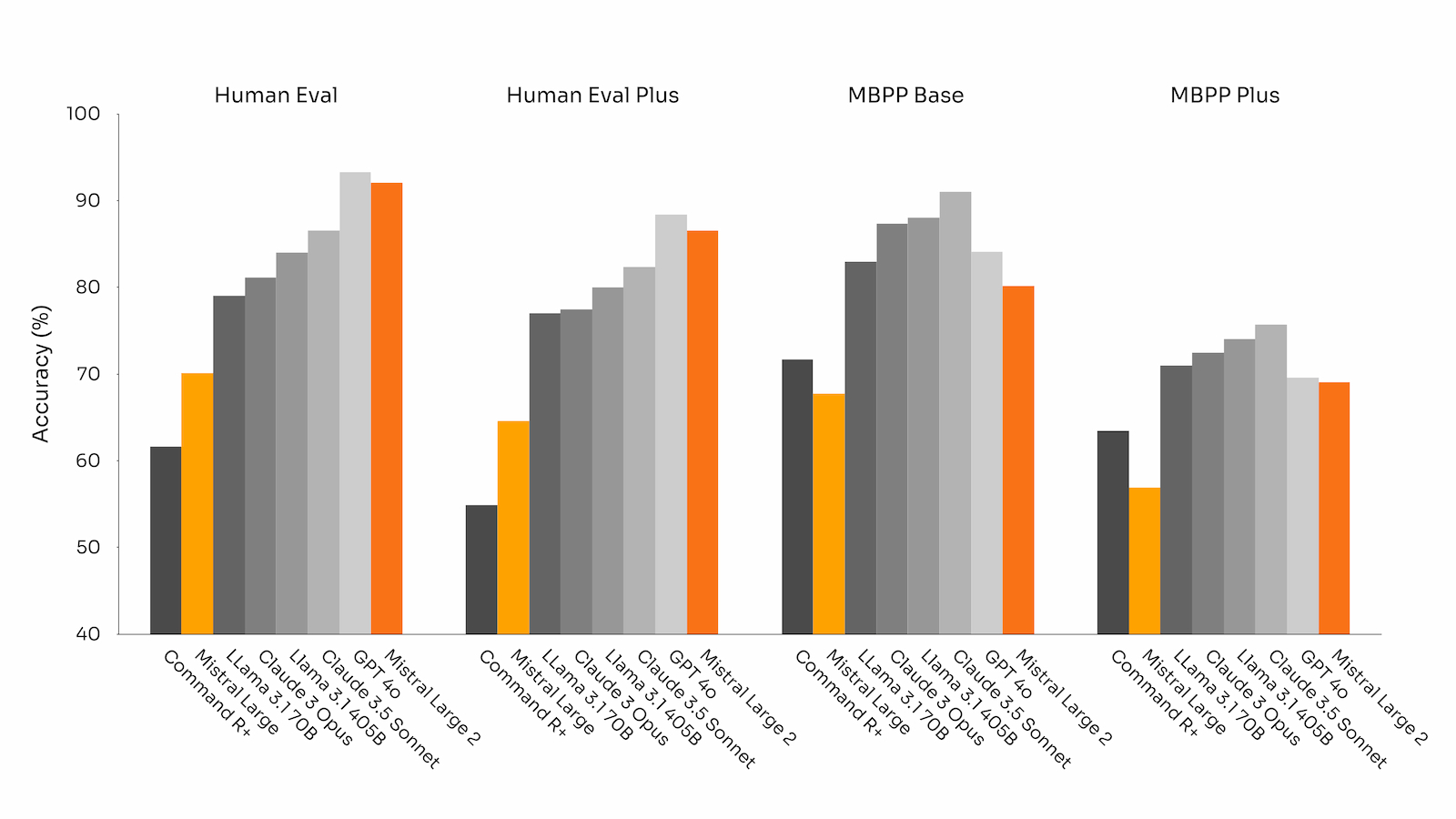

La première version de Mistral Large a été publiée en février dernier. La licorne a ensuite présenté en mai son premier modèle de génération de code Codestral et dernièrement, Codestral Mamba. Mistral Large 2, qui bénéficie des travaux réalisés pour ces 2 modèles, a été entraîné sur une large quantité de code. Il surpasse largement son prédécesseur et offre, selon Mistral AI, des performances égales à celles de modèles de premier plan tels que GPT-4o, Claude 3 Opus et Llama 3 405B.

En MMLU, il atteint une précision de 84,0 % sur le benchmark pré-entraîné, établissant un nouveau standard de performance/coût. Un effort particulier a été consacré à minimiser les “hallucinations” du modèle, ces moments où l’IA génère des informations incorrectes ou non pertinentes. Le résultat est un modèle plus prudent et perspicace, offrant des réponses fiables et précises.

Précision des performances de Mistral Large sur MultiPL-E (capacité du modèle à générer du code correct et fonctionnel dans plusieurs langages de programmation).

Raisonnement mathématique : précision des performances sur les benchmarks des générations GSM8K (8 coups) et MATH (0 coup, sans CoT).

Performance sur MMLU multilingue (mesurée sur le modèle de fondation pré-entraîné)

Suivi des instructions et conversations longues

Les capacités de Mistral Large 2 en matière de suivi des instructions et de gestion des conversations longues ont été considérablement améliorées. Le modèle excelle dans le suivi des instructions précises et dans la gestion des interactions complexes sur plusieurs tours, ce qui le rend particulièrement adapté pour des applications commerciales nécessitant des réponses succinctes et précises.

D’autre part, ses compétences améliorées en matière d’appel et de récupération de fonctions et sa capacité à exécuter efficacement des appels de fonctions parallèles et séquentiels, le rendent très utile pour des applications professionnelles complexes.

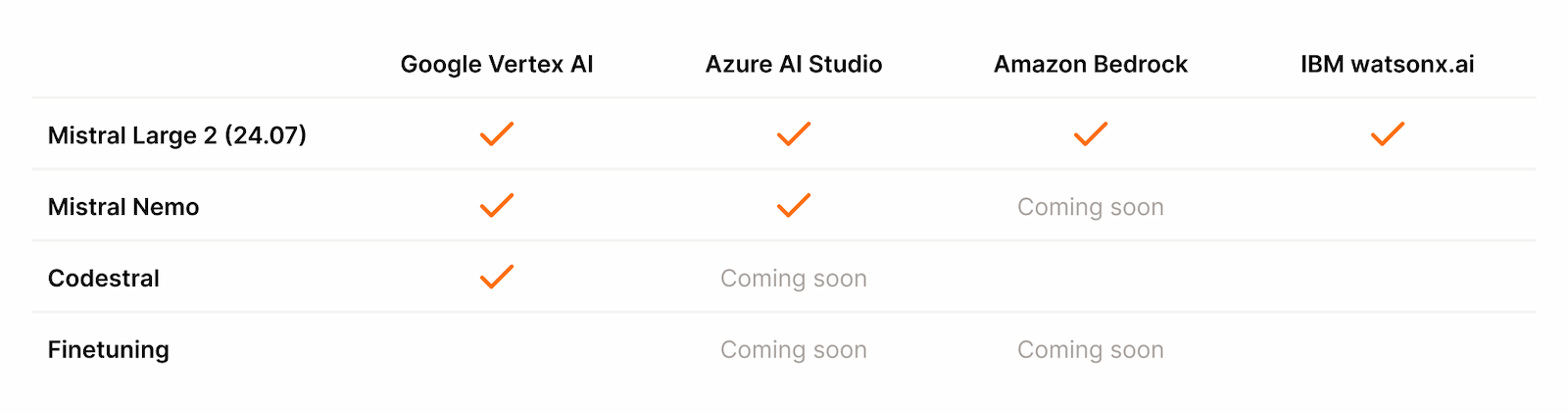

Disponibilité

Mistral Large 2, que l’on peut tester gratuitement sur Le Chat de Mistral AI, est dès à présent disponible via la Plateforme de la start-up sous la version 24.07 et les plateformes Google Cloud Platform, Azure AI Studio, Amazon Bedrock et IBM watsonx.ai. Les poids du modèle instruct sont hébergés sur HuggingFace.