Mistral AI a annoncé ce 16 juillet dernier deux nouveaux LLM publiés sous licence Apache 2.0 : Codestral Mamba 7B et Mathstral 7B. Le premier utilise la nouvelle architecture Mamba introduite fin 2023 par les chercheurs de renom Albert Gu et Tri Dao, et est destiné à la génération de code comme son prédécesseur Codestral. Mathstral, basé sur Mistral 7B, est un modèle spécialisé dans les tâches mathématiques et scientifiques, développé dans le cadre de la collaboration de Mistral AI avec le Projet Numina.

Codestral Mamba 7B : une architecture innovante

Codestral Mamba se distingue par une approche radicalement différente de celle des modèles Transformer traditionnels. Mistral AI explique :

“Contrairement aux modèles Transformer, les modèles Mamba offrent l’avantage de l’inférence temporelle linéaire et la capacité théorique de modéliser des séquences de longueur infinie. Ils permettent aux utilisateurs d’interagir de manière approfondie avec le modèle avec des réponses rapides, quelle que soit la longueur d’entrée. Cette efficacité est particulièrement pertinente pour les cas d’utilisation de la productivité du code. C’est pourquoi nous avons formé ce modèle avec des capacités avancées de code et de raisonnement, lui permettant d’être aussi performant que les modèles basés sur les transformateurs SOTA”.

Performances du modèle

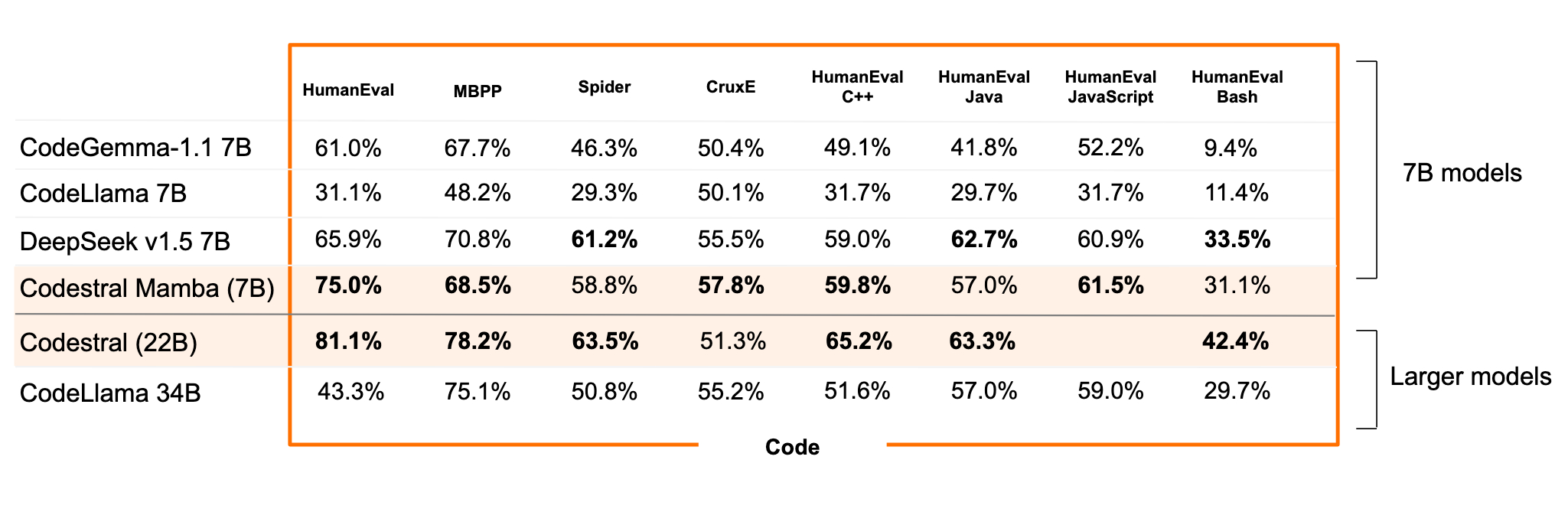

Codestral Mamba a été soumis à des benchmarks détaillés, testant sa capacité de récupération contextuelle jusqu’à 256 000 jetons. Les résultats confirment son potentiel en tant qu’assistant de code local et sa capacité à gérer des tâches complexes.

Le modèle a démontré des performances supérieures aux modèles open source concurrents CodeLlama 7B, CodeGemma-1.17B et DeepSeek dans les tests HumanEval.

Disponibilité

Codestral Mamba a été publié sous la licence Apache 2.0, offrant une liberté complète d’utilisation et de modification. Il est disponible à des fins de tests sur la plateforme de Mistral AI et sur Hugging Face, où il peut être déployé en utilisant le SDK mistral-inférence, qui s’appuie sur les implémentations de référence du dépôt GitHub de Mamba. Il peut également l’être sur TensorRT-LLM pour ceux qui préfèrent cette option de déploiement et bientôt sur llama.cpp pour l’inférence locale.

Mathstral 7B : une avancée dans les problèmes mathématiques complexes

Mathstral est une contribution significative de Mistral AI à la communauté scientifique, destinée à résoudre des problèmes mathématiques avancés nécessitant un raisonnement logique complexe et multi-étapes.

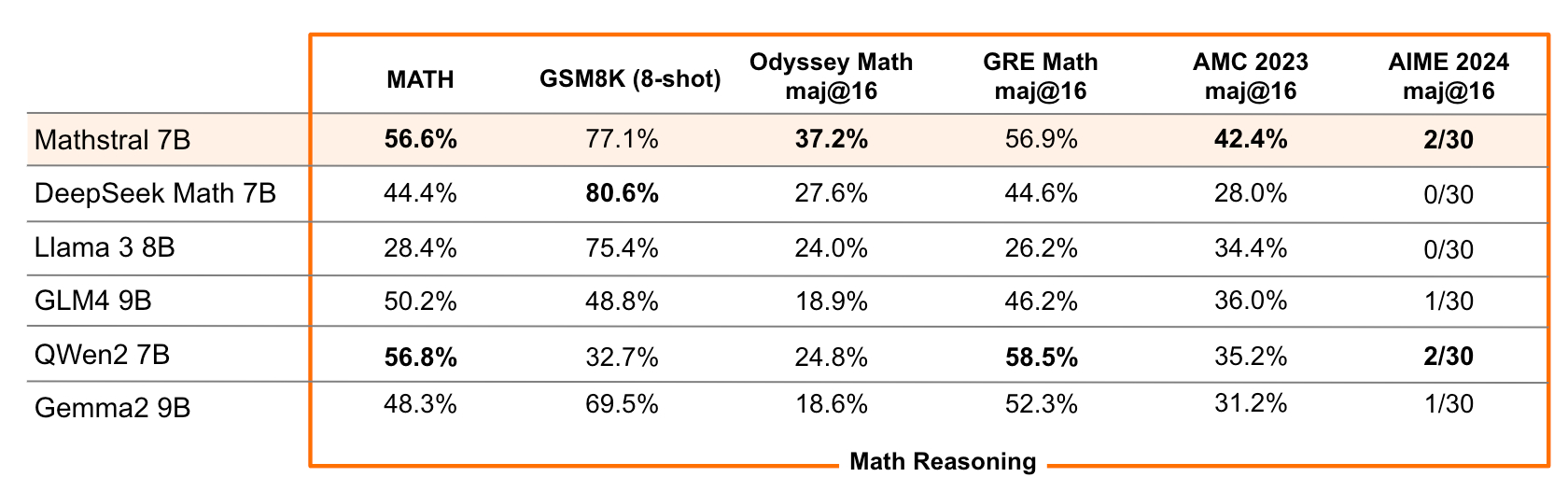

Basé sur Mistral 7B, disposant d’une fenêtre contextuelle de 32 000 jetons, Mathstral excelle dans les matières STEM, atteignant des performances de pointe dans sa catégorie. Il a obtenu 56,6 % sur MATH et 63,47 % sur MMLU.

Avec un calcul plus intensif au moment de l’inférence, le modèle peut atteindre des scores encore plus élevés : MATH avec vote majoritaire: 68,37%, MATH avec un modèle de récompense fort parmi 64 candidats: 74,59%.

Mathstral illustre les excellents compromis performance/vitesse obtenus en construisant des modèles pour des objectifs spécifiques, une philosophie que Mistral AI promeut activement. Les poids de Mathstral sont disponibles sur HuggingFace, et le modèle peut être utilisé tel quel ou affiné avec mistral-inference et mistral-finetune.