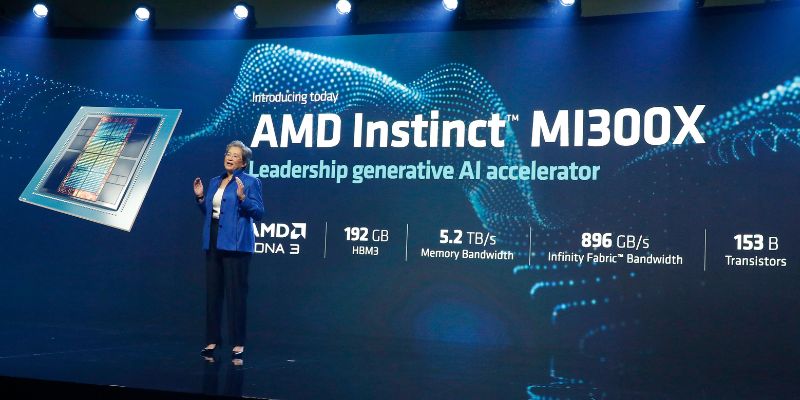

A l’occasion de l’évènement « AMD Data Center and AI Technology Premiere », en juin dernier, Lisa Su, la CEO d’AMD, avait dévoilé le GPU Instinct MI300X, conçu pour l’IA générative et le HPC, ainsi que la plateforme Instinct. Lors de l’annonce des résultats financiers du second trimestre 2023, début août, elle a annoncé que le GPU serait commercialisé au dernier trimestre cette année.

Les puces d’IA spécialisées de pointe sont nécessaires pour mettre en œuvre l’IA de manière rentable à grande échelle. L’essor de l’IA générative et des LLM nécessitent ainsi des GPU de plus en plus puissants pour effectuer les calculs nécessaires, AMD et NVIDIA sont en compétition sur le marché des accélérateurs d’IA estimé à 150 milliards de dollars d’ici 2027 par AMD.

De son côté, INTEL cherche à rattraper son retard et a revu l’architecture de ses puces Falcon Shores pour les adapter à l’IA générative mais elles ne devraient être commercialisées qu’en 2025.

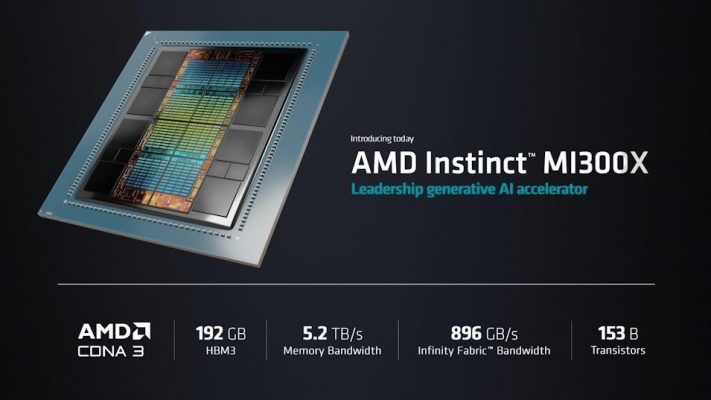

Le GPU Instinct MI300X

Le 1er août dernier, lors de l’annonce des résultats financiers, Lisa Su détaillait :

« Nous avons enregistré de solides résultats au deuxième trimestre, alors que Les processeurs Gen EPYC et Ryzen 7000 ont considérablement augmenté. Nos engagements en matière d’IA ont été multipliés par plus de sept au cours du trimestre, plusieurs clients ayant lancé ou élargi des programmes prenant en charge les futurs déploiements d’accélérateurs Instinct à grande échelle. Nous avons réalisé de grands progrès en atteignant les étapes clés en matière de matériel et de logiciels pour répondre à l’attrait croissant des clients pour nos solutions d’IA de centres de données et nous sommes sur la bonne voie pour lancer et accélérer la production des accélérateurs MI300 au quatrième trimestre »

Le GPU Instinct MI300X est une version optimisée de l‘APU MI300A qui alimentera le supercalculateur El Capitan de plus de deux exaflops au Laboratoire National Lawrence Livermore du département de l’Énergie des États-Unis.

Conçu pour l’entraînement des LLM et le HPC, il compte 153 milliards de transistors, 192 Go de mémoire HBM3 à large bande passante et 12 chiplets, AMD ayant remplacé les 3 CPU Zen 4 de MI300A par deux GPU CDNA 3. Le GPU dispose également d’une bande passante mémoire de 5,2 TB/s et de 896 Go/s de bande passante Infinity Fabric.

Selon la CEO, AMD aurait déjà des clients pour son GPU et s’attend à des déploiements dès le 1er semestre 2024. Ce qui lui donnerait une longueur d’avance sur NVIDIA dont la puce GH 200 nouvelle génération dédiée à l’IA générative ne devrait entrer en production qu’en fin d’année. Cependant, cette dernière dispose de 282 Go de la dernière technologie de mémoire HBM3e alors que le MI300X se contente de 192 Go de mémoire HBM3. NVIDIA affirme que la HBM3e est 50% fois plus rapide que la HBM3, ce qui donnerait un avantage évident à sa puce.