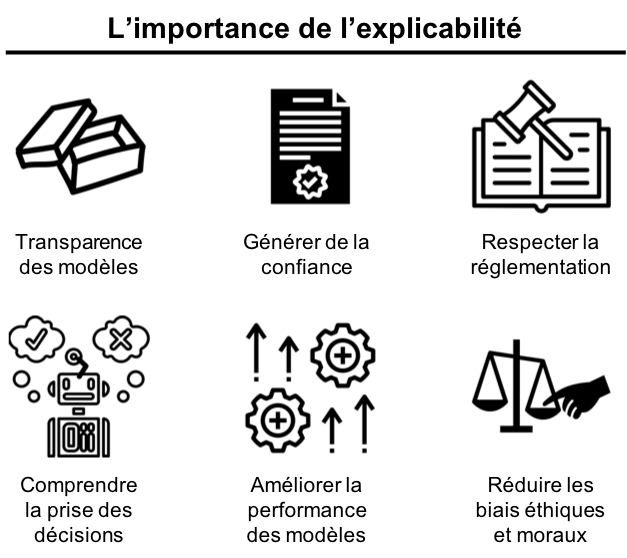

L’intelligibilité des algorithmes en général et particulièrement ceux de l’intelligence artificielle (IA) est devenue un critère prépondérant en raison du rapport Villani en France et à la mise en place du RGPD en Europe. Les mots explicabilité et interprétabilité, deux néologismes provenant de l’anglais, font référence à ce sujet et sont de plus en plus acceptés dans le contexte de l’intelligence artificielle. Par la suite, nous ne ferons pas de distinction entre ces deux mots dans l’article.

Le besoin d’explicabilité d’un algorithme peut être vu à travers l’exemple suivant : Imaginons une situation dans laquelle une personne se voit refuser sa demande de prêt bancaire par le logiciel de gestion. Ce dernier est basé sur un algorithme d’apprentissage automatique du risque de crédit. Si l’algorithme est très complexe et que la prise de décision est difficile à expliquer, les conseillers bancaires seraient incapables de justifier une telle décision. Cet exemple présente un des possibles scénarios dans lesquels l’incompréhension du fonctionnement de l’algorithme est un vrai handicap pour les métiers. En effet, les progrès de l’apprentissage automatique sont de plus en plus utilisés dans des secteurs critiques tels que la médecine, les systèmes judiciaires, les marchés financiers et les ressources humaines. Un algorithme explicable devient indispensable pour aider à réduire les biais moraux et éthiques dans la prise de décisions dans ces domaines.

« La complexité des produits basés sur l’apprentissage automatique ainsi que la manque de confiance à la prise de décisions par des logiciels suscitent de plus en plus d’inquiétudes en raison de leur manque d’explicabilité. »

Pendant de nombreuses années, la performance a été privilégiée par rapport à l’interprétabilité, ce qui a logiquement favorisé d’énormes progrès dans plusieurs domaines, notamment la vision par ordinateur, le traitement du langage naturel et la modélisation de séquences 1. Cependant, les questions cruciales suscitées par la réticence à accepter des décisions basées sur l’IA peuvent conduire à une nouvelle dynamique dans laquelle l’explicabilité peut être l’une des mesures clés pour l’évaluation des modèles. Et dans cet article, on discutera de raisons concrètes pour lesquelles ce serait un facteur de différenciation important. Nous présenterons également certaines approches visant à développer des algorithmes puissants tout en conservant un bon degré d’interprétabilité.

« Avoir un modèle précis, c’est bien, mais avoir un modèle explicable est encore mieux surtout pour le développement des produits performants et transparents. »

D’un point de vue mathématique, la recherche d’un bon modèle d’apprentissage automatique met l’accent sur la minimisation d’une fonction de coût ou la maximisation d’une fonction de vraisemblance. Ainsi, la performance du modèle est mesurée presque exclusivement sur les résultats par rapports à des métriques correctement choisies. Cette tendance a conduit à des algorithmes de plus en plus sophistiqués et complexes au détriment de l’explicabilité. En fait, on pourrait même affirmer que « Ce qui rend les algorithmes d’apprentissage automatique difficiles à comprendre, c’est aussi ce qui fait d’eux d’excellents prédicteurs ». Ils sont complexes, ce qui les fait ressembler à des boîtes noires pour la plupart des professionnels dans le domaine de l’IA.

Niveaux d’interprétabilité :

On peut distinguer 3 niveaux d’interprétabilité dans les algorithmes d’apprentissage automatique :

- Haute interprétabilité : ce niveau inclut les algorithmes de régression, les arbres de décision et les règles de classification traditionnelle. Fondamentalement, ils se rapprochent des fonctions monotones linéaires.

- Interprétabilité moyenne : ce niveau inclut des algorithmes plus avancés tels que les modèles graphiques. Ils sont contraints à l’approximation de fonctions monotones non linéaires.

- Faible interprétabilité : ce niveau inclut des techniques avancées d’apprentissage automatique telles que les SVM, les méthodes d’apprentissage ensembliste et d’apprentissage profond. Au mieux, ils fournissent des informations sur l’importance des variables pour l’explicabilité du modèle.

Aujourd’hui la tendance est que l’explicabilité d’un modèle est une métrique primordiale au même titre que la performance,, et un bon compromis entre explicabilité et précision est de plus en plus nécessaire. Cela pourrait être la clé pour rendre les algorithmes aussi transparents que possible pour les utilisateurs finaux. Le changement d’orientation vers un paradigme d’apprentissage automatique centré vers l’utilisateur peut probablement faire la différence sur l’appropriation et l’acceptation de cette technologie dans plusieurs domaines. Une bonne compréhension du modèle pourrait rendre son adaptation beaucoup plus confortable pour effectuer les tâches quotidiennes et répétitives de manière plus réaliste.

Même si certains aspects fondamentaux de l’apprentissage automatique sont appliqués dans différents domaines, ils ne sont pas utilisés de la même façon dans tous les secteurs. Les algorithmes doivent être transparents sur certains secteurs particulièrement réglementés tels que la banque, l’assurance et la santé. Les principales raisons pour cela sont les exigences légales et éthiques qui limitent l’utilisation des boîtes noires. En plus, les logiciels dotés d’intelligence artificielle ne pourront pas prendre de décisions tout seuls comme le signale le règlement général sur la protection des données (RGPD) dans son article 22 – 1 3 :

« La personne concernée a le droit de ne pas faire l’objet d’une décision fondée exclusivement sur un traitement automatisé, y compris le profilage, produisant des effets juridiques la concernant ou l’affectant de manière significative de façon similaire. »

Plus important encore, cela signifie que l’humain doit être impliqué dans la prise de décisions en utilisant des inputs provenant des algorithmes d’apprentissage automatique. Pour cela, la personne qui interagit avec le logiciel doit bien comprendre les raisons pour lesquelles une décision est prise par le logiciel.

Tous ces facteurs contribuent largement à la réticence générale de plusieurs secteurs à adopter et à déployer des produits basés sur de systèmes d’apprentissage automatique. Face à ces contraintes, les recherches sont de plus en plus axées sur l’explicabilité des modèles en gardant une bonne performance.

Critères d’interprétabilité :

On peut utiliser différents critères pour choisir le niveau d’interprétabilité d’un modèle 4 :

- Intrinsèque ou Post-hoc : L’interprétabilité intrinsèque implique que le modèle d’apprentissage automatique choisi est un modèle facile à expliquer tel qu’un arbre de décision. Tandis que l’interprétabilité post-hoc implique l’utilisation d’un modèle dit boîte noire pour l’entraînement et l’application des méthodes d’interprétabilité par la suite pour expliquer les résultats tels que la méthode « feature importance » pour Random Forest.

- Model-Specific ou Model-agnostic : Il existe quelques outils pour interpréter certains modèles d’apprentissage automatique mais ils sont limités à certaines catégories. Par exemple l’interprétation des poids d’une régression linéaire est une interprétation spécifique du modèle. En plus, un modèle de régression est un modèle intrinsèquement interprétable. Un outil qui est utilisé pour les réseaux de neurones convolutifs est aussi un outil model-specific. D’un autre côté, un outil model-agnostic peut être utilisé pour interpréter n’importe quel modèle après l’entraînement (post-hoc). Ces derniers analysent les paires variables prédictives-variable dépendante et par définition ils n’ont pas accès aux poids des variables ou à une autre information interne du modèle.

- Local ou global : Ces deux critères aident à définir le périmètre de l’interprétabilité du modèle. Le critère d’explicabilité globale vise à rendre le processus de la prise de décision transparent pour toutes les données, tandis que le critère d’explicabilité locale vise à fournir des explications pour une seule décision dans un voisinage restreint de données.

« Lorsque nous démarrons un projet Data Science, il peut être utile de déterminer d’abord le degré d’interprétabilité du modèle que nous souhaitons atteindre. »

Le choix du périmètre d’interprétabilité d’un modèle peut influencer la décision sur le choix des algorithmes qui peuvent être implémentés. Par exemple si on choisit un modèle simple et facile à expliquer, il est possible d’améliorer sa performance en complexifiant le modèle petit à petit afin d’obtenir une explicabilité globale. Tandis que si on choisit un modèle complexe, il est possible de le rendre plus interprétable en réduisant l’analyse à un voisinage afin d’obtenir une explicabilité locale. Le tableau suivant résume les différents périmètres d’interprétabilité pour un modèle d’apprentissage automatique :

Évaluation de l’interprétabilité :

Finalement, même s’il n’y a pas pour l’instant un vrai consensus autour de la définition et de la mesure de l’interprétabilité d’un modèle d’apprentissage, certains chercheurs tentent de définir trois niveaux pour évaluer l’interprétabilité 5 :

- Évaluation au niveau application (tâche réelle) : L’évaluation est faite par les utilisateurs finaux ou les experts métiers. Cela nécessite la mise en place d’un processus objectif qui permet de mesurer la qualité de l’évaluation. Un bon point de départ serait de comparer l’interprétation du résultat d’un modèle avec l’interprétation faite par un expert.

- Évaluation au niveau humain (tâche simple) : L’évaluation est faite par des personnes non-expertes dans le domaine. Par exemple, on peut montrer plusieurs explications pour une prédiction, et les personnes peuvent choisir la meilleure. Une agrégation des évaluations sera nécessaire pour évaluer le résultat du modèle.

- Évaluation au niveau fonctionnelle (tâche proxy) : L’évaluation est faite par des machines. Ce type d’évaluation est possible si le fonctionnement des modèles utilisés est facile à comprendre ou à expliquer tels que les modèles de régression ou les arbres de décision.

Nous espérons que vous avez apprécié votre cheminement à travers cette préoccupation « récente », pourtant très importante. Si vous avez des questions ou des remarques, nous serons heureux de les prendre en compte pour de futures discussions.

1 Z. Lipton, The Mythos of Model Interpretability, https://arxiv.org/pdf/1606.03490.pdf

2 H. Dam, T. Tran, A. Ghose, Explainable Software Analytics. https://arxiv.org/pdf/1802.00603.pdf

3 Règlement Général sur la protection des données – Article 22, https://www.cnil.fr/fr/reglement-europeen-protection-donnees/chapitre3#Article22

4 C. Molnar, Interpretable Machine Learning, https://christophm.github.io/interpretable-ml-book/

5 F. Doshi-Velez, B. Kim, Towards a Rigorous Science of Interpretable Machine Learning, https://arxiv.org/pdf/1702.08608.pdf