Cet article fait partie de la série d’articles “Make Data Science Great Again”, cliquez-ici pour accéder à la première partie.

Tout commence avec les données. Toutes les sociétés génèrent ou consomment des données, dont la quantité et qualité peuvent être très différentes. Un beau matin, le CTO ou le PDG se dit : « Nous avons des données, et les données semblent être la poule aux œufs d’or. Ce serait bien qu’on en profite, nous aussi ! On ne sait pas encore comment, donc on va faire de la data science ! »

Ça vous semble logique ? Alors cet axiome est pour vous.

Axiome # 1

Quand un data scientist sait ce qu’il doit chercher dans des données, il peut mettre beaucoup du temps à le trouver, et le résultat n’est pas garanti.

Alors quand il ne sait pas ce qu’il doit chercher, il est certain qu’il ne trouvera rien !

Quand on commence un projet de data science avec un objectif précis, on prévoit un plan d’attaque : les variables à étudier, l’algorithme qui doit bien s’adapter à la problématique, et la tâche semble avoir des mesures tout à fait abordables. Sauf qu’une fois qu’on est lancé, on découvre qu’il faut encore explorer énormément de choses : les variables qu’on avait prévu d’utiliser ne sont pas assez significatives et on va devoir étudier d’autres possibilités de variables (Feature Engineering), ce qui peut changer l’algorithme et l’approche générale. Suite à cela on va être amené à comparer et étudier plusieurs algorithmes, mais aussi plusieurs optimisateurs et plusieurs configurations pour chaque algorithme.

Ça peut être long (très long), et il est possible que le résultat soit loin d’être satisfaisant. Les ressources mises dans l’apprentissage des algorithmes sont loin d’être rentabilisées par le gain apporté.

Le problème peut aussi être caché dans la qualité des données, dans la nature de la problématique à résoudre… il existe beaucoup d’autres possibilités pour lesquelles la data science ne sera d’aucune aide.

L’exemple classique est la prédiction des conversions dans la publicité programmatique, où l’objectif est de prédire si une publicité affichée sur un site ou une application va mener à un clic, suivi par l’achat d’un produit ou par l’inscription à un service. L’état de l’art de cette problématique étant très important, la réalité du terrain témoigne que les taux de conversion ne s’améliorent pas autant que les articles scientifiques le promettent.

Même avec un objectif clairement défini, on n’est pas certain d’y arriver.

Mais si l’objectif n’est pas défini, c’est perdu d’avance.

Pour l’anecdote, dans une de mes premières missions, on m’a demandé de « trouver l’innovation » grâce aux données.

Disclaimer : « Trouver l’innovation » n’est pas un objectif valable pour un projet de data science.

Mais c’était la première fois que j’avais ce type d’objectif, j’ai donc testé cela pour vous…

On a mis à ma disposition une base de données (à moitié vide) qui comprenait de nombreux enregistrements incohérents. Et quand j’ai signalé cette problématique au début de la mission, on m’a répondu : « On s’en doutait, mais ça ne t’empêchera quand même pas de trouver l’innovation ! »

J’ai commencé à creuser, et j’ai proposé quelques idées et perspectives de data science. Bien évidemment celles-ci n’ont pas plu aux décideurs, parce que ce n’était pas assez innovant. Et puisque je n’avais aucune idée de l’innovation qu’ils voulaient, tout comme eux n’avaient aucune idée de l’innovation qu’ils attendaient, nous avons décidé d’un commun accord de stopper cette mission.

L’histoire finit assez bien : arrêter le projet était la meilleure décision à prendre, même si ça laisse un arrière goût de déception, c’était bien mieux que de persister à creuser à l’aveugle une voie qui ne créera aucune valeur.

Et pourtant de plus en plus d’entreprises font de la data science à l’aveugle, sans savoir ce qu’il veulent en tirer. La data science devient un buzzword, mettant la pression aux dirigeants qui pensent que sans data-science un produit ne sera pas pris au sérieux. En réalité, les projets de data science dans ce type d’entreprises ne vont jamais plus loin que le stade du POC (proof of concept, ou preuve de concept).

Mais comment trouver un objectif si on connait pas le potentiel des données et que l’on ne sait donc pas quelle valeur ajoutée elles peuvent apporter ? La première action pour comprendre le potentiel des données et pouvoir trouver un objectif est de mesurer.

Action # 1 : Mesurer

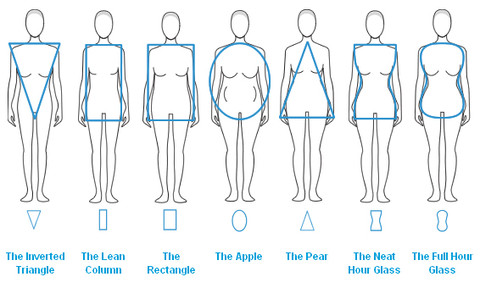

Les données, comme les gens, ont des morphologies différentes. Et s’il est indispensable de connaître la morphologie d’une personne pour lui proposer une coupe de costume adaptée, il est tout aussi important de connaître la morphologie de ses données pour identifier les opportunités et formuler les premiers objectifs de data science.

Mesurer efficacement vos données ne sera pas chose aisée, c’est une étape qui vous demandera beaucoup de temps. Heureusement, cette étape est relativement simple et vous pouvez la réaliser avec vos équipes métiers et développeurs non spécialisés en data science.

Commencez par organiser vos données dans des bases de données et mettez en place des pipelines ETL simples grâce auxquels vous pourrez récupérer des statistiques descriptives simples telles que les moyennes, variances, valeurs maximales, minimales… et suivre l’évolution de ces métriques au fil du temps.

Avoir une vision sur ces métriques et leurs évolutions vous permettra de découvrir des schémas intéressants dans vos données qui pourraient se concrétiser de manière lucrative pour votre organisation.

La mise en place de ces mesures nécessite également de prêter attention à la qualité et à l’accessibilité des données, et ainsi d’avoir un socle solide pour vos futurs projets impliquant le traitement des données.

Et peut-être arrêtez-vous là, au moins pour aujourd’hui.

À l’issue de cette étape, vous allez peut-être prendre conscience que vous n’avez pas du tout besoin de faire de la data science. En ayant vos données accessibles et propres, ainsi que des statistiques descriptives basiques, vous créez déjà de la valeur ajoutée : vous posez les bonnes questions et prenez de meilleures décisions, et au stade d’évolution actuel de votre société, c’est amplement suffisant.

Mais c’est aussi possible qu’au contraire, cette première étape d’analyse de vos données vous fasse découvrir un potentiel de data science pour votre entreprise. Vous pouvez donc définir des objectifs clairs de data science pour votre business. Et grâce à l’infrastructure que vous avez construit pour organiser et mesurer vos données, ainsi qu’avec la connaissance de la morphologie de ces données, vous partez avec tous les atouts en main pour réussir votre projet de data science.

C’est donc le moment idéal pour démarrer votre aventure de data science !