Google a présenté la semaine dernière dans un article TensorFlow Privacy, son outil pensé pour la protection des données personnelles utilisées dans les phases d’apprentissage avec TensorFlow des systèmes d’intelligence artificielle. Basé sur la « confidentialité différentielle », le module vise à répondre à certaines controverses vis-à-vis de l’utilisation des données de personnes dans l’entraînement des IA.

Le sujet a fait polémique ces dernières années, par exemple en ce qui concerne l’utilisation des données personnelles de patients pour l’apprentissage d’algorithmes spécialisés dans la détection de certaines pathologies par des entreprises privées. L’entraînement de tels systèmes requièrent d’importants volumes de données et leur obtention et utilisation, lorsqu’il s’agit de données personnelles de personnes, peut se révéler problématique. C’est à cet enjeu et à la demande d’une plus grande éthique en la matière qu’a souhaité répondre Google avec TensorFlow Privacy.

Carey Radebaugh et Ulfar Erlingsson ont indiqué dans leur article :

“Idéalement, les paramètres des modèles de machine learning formés devraient coder des modèles généraux plutôt que des faits concernant des exemples de formation spécifiques. Pour ce faire et pour donner de fortes garanties de confidentialité lorsque les données de formation sont sensibles, il est possible d’utiliser des techniques basées sur la théorie de la confidentialité différentielle.

lors de la formation sur les données des utilisateurs, ces techniques notamment offrent de solides garanties mathématiques que les modèles n’apprennent ni ne se souviennent des détails d’un utilisateur spécifique. En particulier pour le deep learning, les garanties supplémentaires peuvent renforcer utilement les protections offertes par d’autres techniques de protection de la vie privée, qu’elles soient établies, telles que le seuillage et la suppression de données, ou nouvelles, telles que TensorFlow Federated learning.”

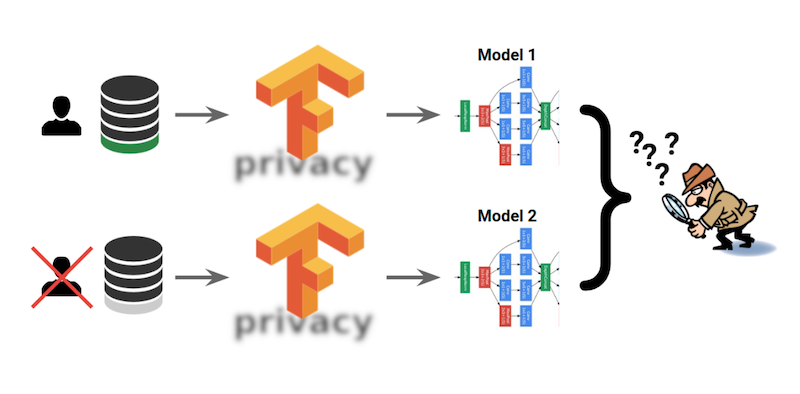

Basé sur la technique de Differential Privacy ou « confidentialité différentielle », ce module a pour objectif de protéger les données personnelles. Désormais disponible en open source sur Git Hub, il permet d’empêcher les systèmes IA en phase d’apprentissage de récupérer et d’encoder les informations des personnes et donc de pouvoir les identifier.

“Pour utiliser TensorFlow Privacy, aucune expertise en matière de confidentialité ni en mathématiques sous-jacentes ne devrait être requise : les personnes utilisant des mécanismes TensorFlow standard ne devraient pas avoir à modifier leurs architectures, procédures ou processus de modèle. Au lieu de cela, pour former des modèles qui protègent la confidentialité de leurs données de formation, il vous suffit souvent d’apporter quelques modifications simples au code et de régler les hyperparamètres pertinents pour la confidentialité.”

La nécessité d’anonymiser les données pour le développement d’intelligences artificielles est centrale. TensorFlow Privacy semble donc répondre à ce défi puisqu’il élimine les éléments pouvant permettre d’identifier un utilisateur. Cependant, les observateurs indiquent qu’il y a un risque de suppression dans le même temps de données pertinentes pour l’apprentissage d’un système et qu’il ne permet pas d’apprendre d’un événement s’étant produit une seule fois.

Google appelle de son côté les utilisateurs à étudier les exemples et tutoriels (tâche MNIST, TensorFlow 2.0, Keras…) fournis sur GitHub :

“Nous souhaitons que TensorFlow Privacy devienne une plaque tournante des meilleures techniques pour la formation de modèles d’apprentissage automatique avec de fortes garanties de confidentialité. Par conséquent, nous encourageons toutes les parties intéressées à participer.”