La Loi de Moore semblait régir la progression des circuits intégrés électroniques et donc de la puissance de calcul des machines. Cependant, les annonces concernant l’obsolescence de cette loi se multiplient. Sur le sujet, Intel et Nvidia divergent fondamentalement.

La loi de Moore, un fondement du domaine

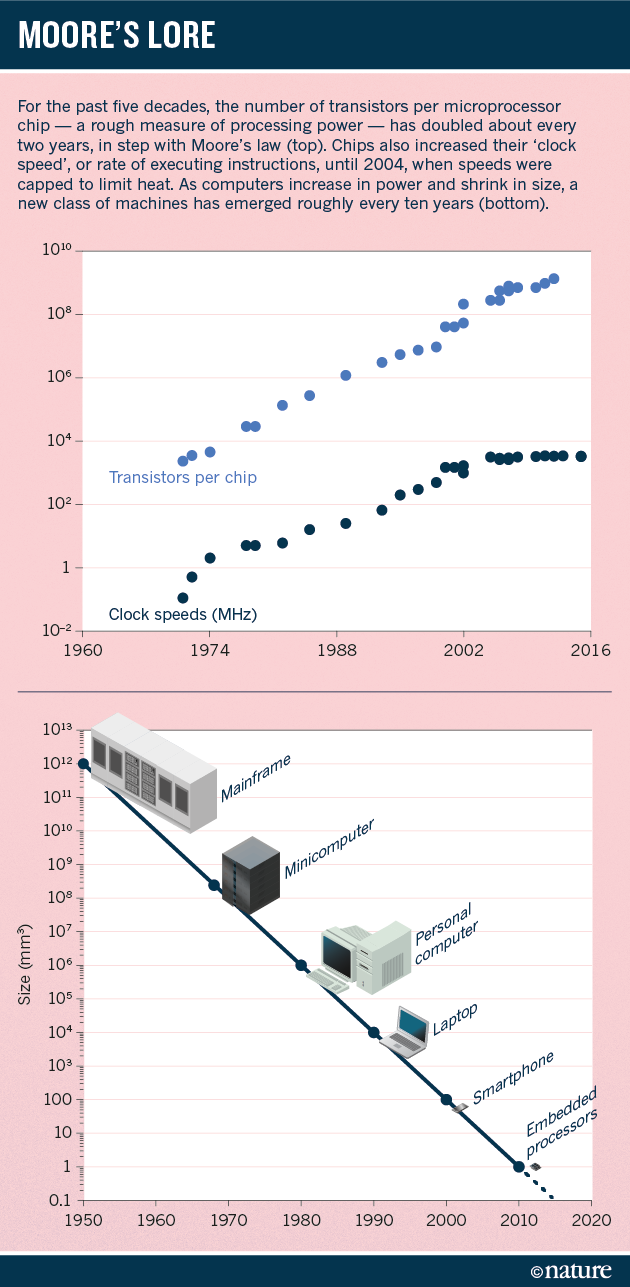

C’est en 1965 que Gordon Moore, un informaticien alors directeur R&D chez Fairchild Semiconductor, annonçait ce que deviendrait la Loi de Moore. Ce qui ressemblait à une prédiction s’est révélé au fil des années d’une incroyable exactitude. Gordon Moore, qui co-fondera Intel, affirmait que le nombre de transistors, l’élément central composant les processeurs, doublait tous les deux ans. Cela impliquait que la puissance des machines doublait en conséquence.

Ce rythme s’est révélé exact durant plusieurs décennies. Cependant de nombreux experts, dont Jensen Huang, PDG de Nvidia, expliquent aujourd’hui que nous vivons la fin de la Loi de Moore.

Une fin déjà amorcée?

L’an dernier, une annonce d’Intel avait commencé à faire craindre la possible fin de la Loi de Moore. Le géant des semi-conducteurs avait en effet indiqué que le doublement de la puissance de ses futurs processeurs n’aurait pas lieu dans deux ans, mais dans deux ans et demi.

Si la feuille de route des fabricants de processeurs se calquait sur cette loi depuis plus de 20 ans, il semblait que la fin d’une époque fondamentale approchait. À tel point que le consortium des grands constructeurs de puces électroniques annonçait qu’il abandonnerait bientôt la poursuite de la Loi de Moore.

À l’occasion d’une conférence sur le traitement graphique à Pékin en 2017, Jensen Huang, PDG de Nvidia, a pris part au débat sur cette loi. Pour lui, c’est certain, “la loi de Moore est morte” et nous sommes entrés dans une nouvelle ère. Huang pense en effet qu’il est temps de réfléchir à l’après-loi de Moore afin de poursuivre l’accélération du calcul. L’intelligence artificielle, le cloud, le big data mais aussi le calcul intensif sont des applications dans lesquelles l’industrie doit s’inscrire.

“Il est toujours possible de gonfler de 50% le nombre de transistors des processeurs classiques, comme Intel s’acharne à le faire. Mais le gain de performance n’est plus que de 10%”.

Un ralentissement certain

Mais certains refusent cependant de reconnaître la mort de cette fameuse loi et la voit comme un simple ralentissement. Brian Krzanich, patron d’Intel, assure en effet qu’elle est bien vivante. Il avait à ce propos déclaré l’an dernier:

“Pour ceux qui se demandent si la loi de Moore est en vie et si la technologie de 10 nanomètres va arriver, la réponse est absolument oui. Et je crois que la loi de Moore va se prolonger au-delà de ma propre carrière.”

Le secteur des puces électroniques a cependant connu un ralentissement certain. Pour Brian Krzanich, cela n’implique pas nécessairement pour autant qu’elle est devenue obsolète.

Face à lui, de très nombreux experts ont déjà pris acte de la fin proche de la Loi de Moore devant la stagnation de la feuille de route de l’industrie. Les trois étapes de miniaturisation des semiconducteurs, en 7, 5 et 3 nanomètres commencent à être franchies par les géants du secteur comme IBM ou Samsung. Et la génération d’après reste un mystère.

La démarche lancée l’an dernier et baptisée “More than Moore” essaie à ce titre de réfléchir au futur et à l’après miniaturisation. Fabrication de puces en 3D, changement de matériaux ou encore combinaison de plusieurs fonctions sont notamment à l’ordre du jour.

Cinq ans plus tard, Nvidia reste sceptique sur l’avenir de la loi de Moore. Le lien entre l’augmentation du nombre de transistors et l’augmentation de la puissance fait toujours autant débat. “L’après loi de Moore” est débattu, même si, selon certaines experts, elle sera épuisée d’ici deux décennies (ce qui laisse encore un facteur 1000 pour la croissance des capacités informatiques).

D’un autre côté, de récentes recherches du MIT sur la culture des cristaux en deux dimensions sur une plaque de silicium, tendent à montrer que le règne de la loi de Moore est compromis, et qu’un grand changement de paradigme pourrait avoir lieu.