Meta a dévoilé hier, lors de sa conférence annuelle Meta Connect, la dernière itération de sa famille Llama 3, Llama 3.2. Celle-ci se compose de quatre modèles : les deux plus grands (11B et 90B), multimodaux, peuvent traiter les images, tandis que les deux plus légers (1B et 3B) sont uniquement textuels, comme leurs prédécesseurs. Destinés aux smartphones et aux périphériques, ces modèles de petite taille sont disponibles pour l’Europe, contrairement aux modèles de vision, du moins jusqu’à ce que Meta et l’UE trouvent un terrain d’entente.

Pour rappel, c’est en juillet dernier que Meta avait dévoilé la famille de modèles Llama 3.1 : Llama 3.1 8B et Llama 3.1 70B, deux versions améliorées de Llama 3 7B et Llama 3 70B présentés en avril dernier, mais également Llama 3.1 405B. Ce nombre impressionnant de paramètres fait de ce dernier le plus grand modèle open source à ce jour.

Comme les modèles Llama 3.1, les quatre versions Llama 3.2 sont multilingues et disposent d’une fenêtre contextuelle pouvant aller jusqu’à 128 000 jetons.

Les modèles de vision 11B et 90B

Pour la première fois, les modèles Llama intègrent des capacités de traitement d’images grâce à une nouvelle architecture intégrant un encodeur d’image au modèle de langage. Ils prennent en charge les entrées de texte et d’image ainsi que la sortie de texte, ce qui les rend adaptés à des tâches comme l’analyse de graphiques, la génération de légendes d’images, ou le “visual grounding” comme la localisation directionnelle d’objets dans des images à partir de descriptions en langage naturel.

Les modèles sont prêts à l’emploi pour de nombreux cas d’usage dès leur téléchargement, sans avoir besoin d’entraînements supplémentaires complexes. Sinon, ils peuvent être peaufinés facilement avec TorchTune, puis déployés localement avec TorchChat, ce qui offre une flexibilité maximale pour des applications spécifiques tout en assurant un contrôle local des données et des ressources.

Les SLM 1B et 3B

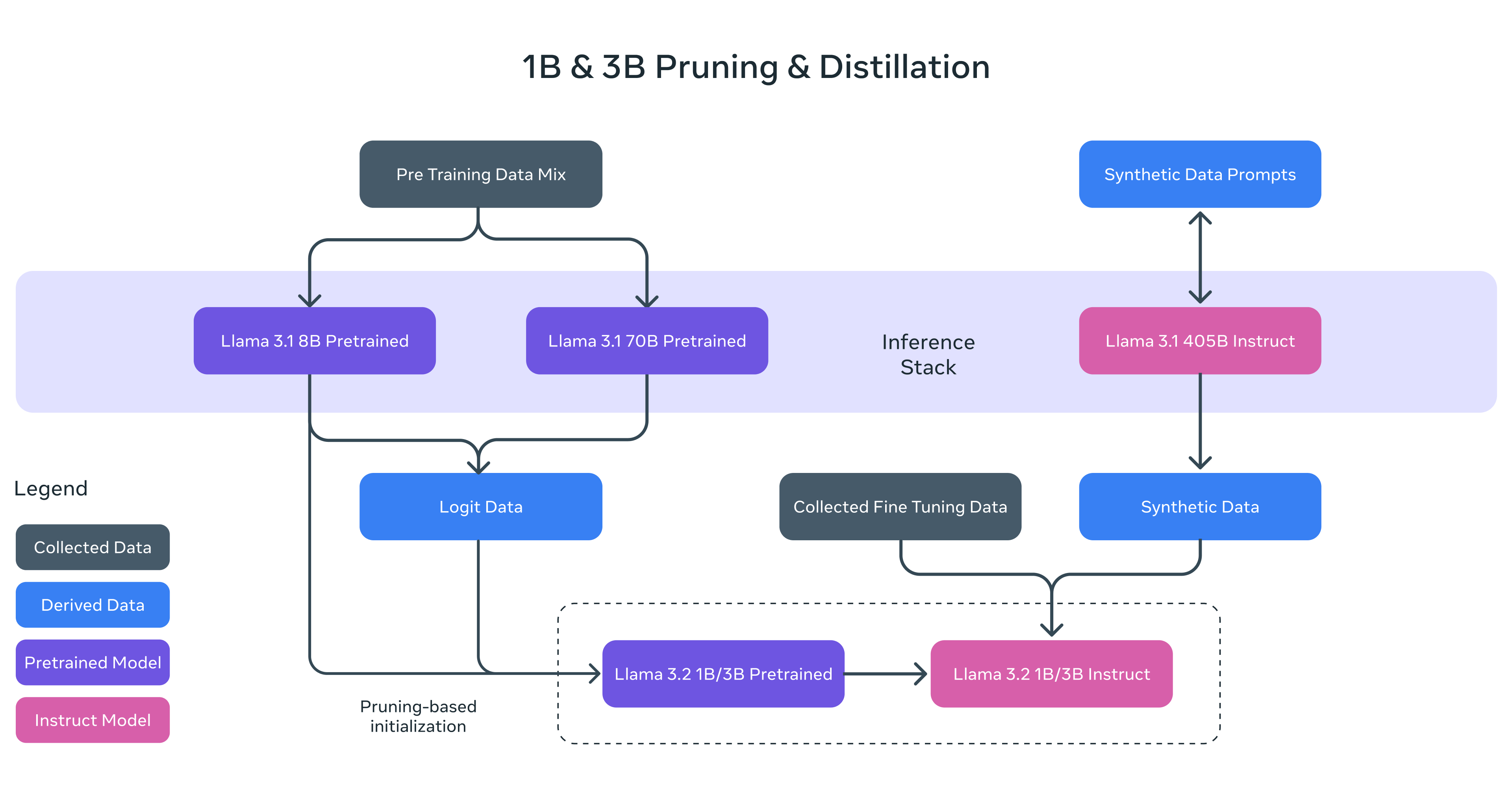

Ces modèles compacts sont conçus pour fonctionner de manière optimale sur des appareils légers, tels que les téléphones mobiles ou les dispositifs embarqués. Meta a utilisé des techniques d’élagage (pruning) et de distillation pour maintenir des performances élevées sur des tâches telles que la synthèse, le suivi d’instructions et la réécriture, tout en réduisant leur taille pour une meilleure efficacité sur ces appareils.

Disponibles en versions pré-entraînées ou adaptées pour le suivi d’instructions, ils permettent une personnalisation facile pour diverses applications. Optimisés pour les processeurs basés sur l’architecture Arm, ils sont d’ores et déjà disponibles pour les appareils équipés de puces Qualcomm et MediaTek.

Évaluation des modèles Llama 3.2

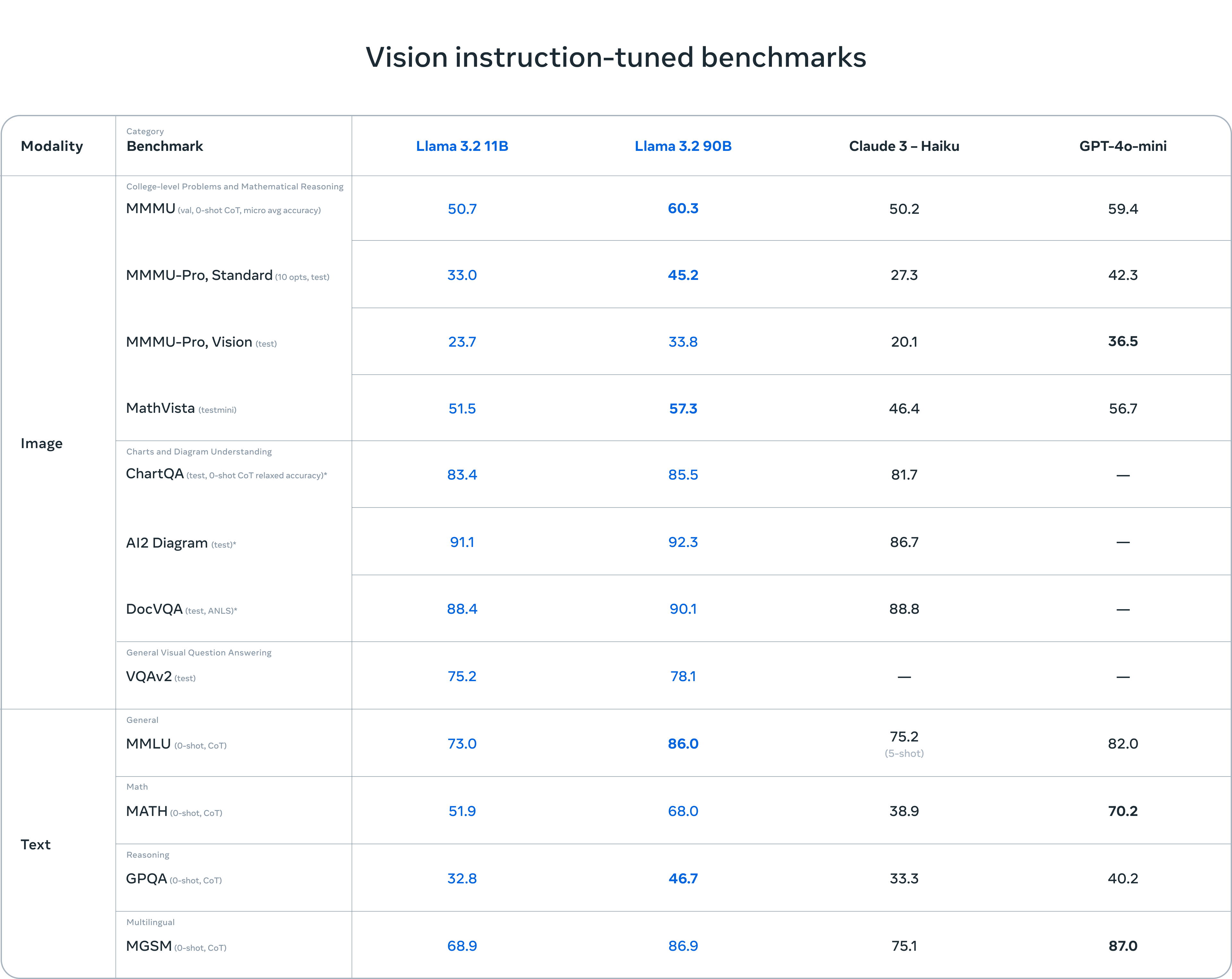

Les modèles de vision Llama 3.2 (11B et 90B) sont compétitifs avec des modèles leaders comme Claude 3 Haiku et GPT4o-mini sur des tâches de reconnaissance d’image et de compréhension visuelle.

Le modèle 3B surpasse des concurrents comme Gemma 2.6B et Phi 3.5-mini dans des tâches comme le suivi d’instructions, la synthèse et l’utilisation d’outils. Le modèle 1B, plus léger, reste compétitif avec Gemma.

Meta continue de promouvoir une approche ouverte pour encourager l’innovation. Les modèles Llama 3.2 sont disponibles au téléchargement via llama.com et Hugging Face, et peuvent être utilisés directement sur un large éventail de plateformes partenaires.

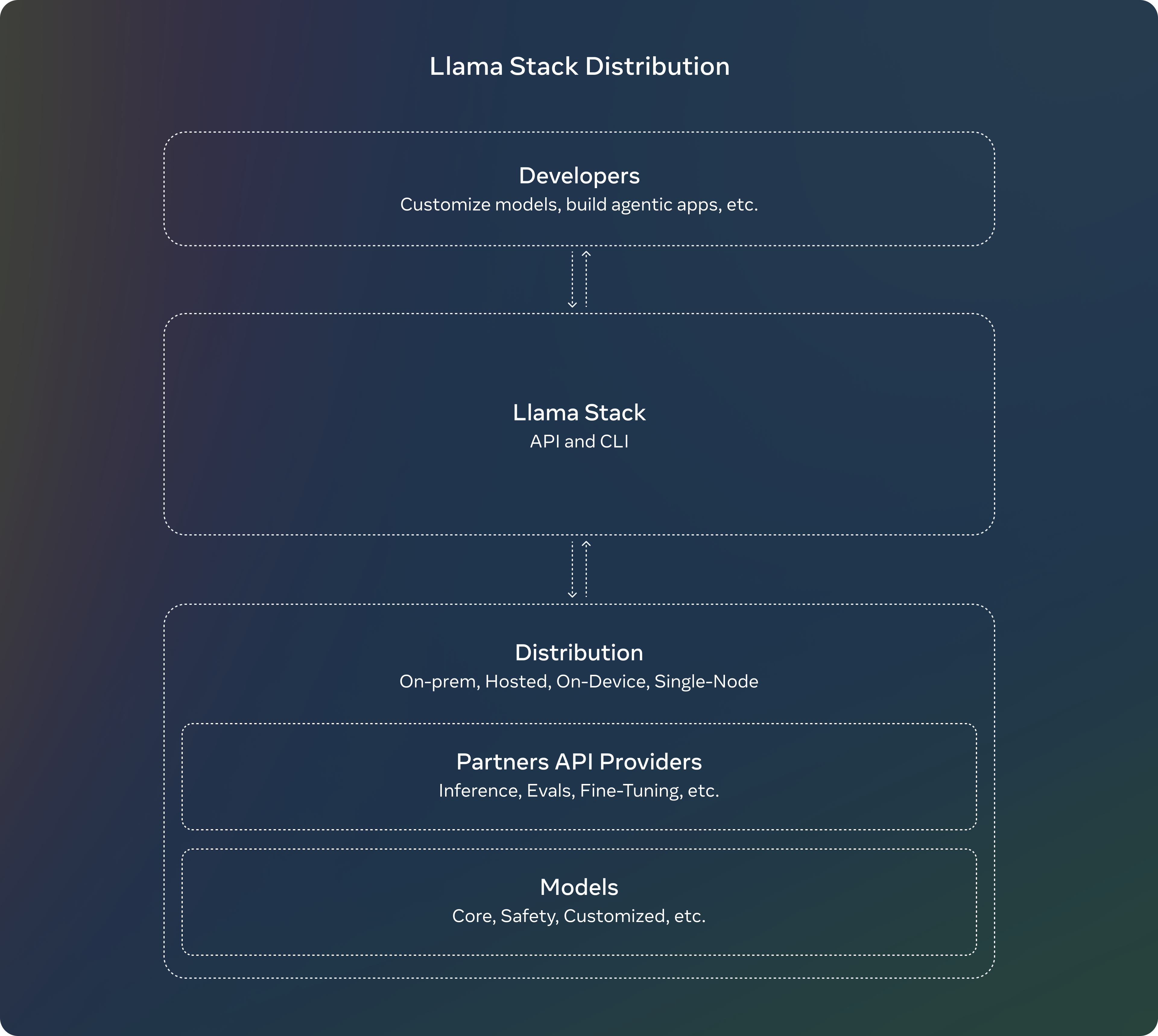

Llama Stack Distribution

Meta a également introduit les premières distributions de Llama Stack, une suite d’outils conçus pour simplifier le déploiement de ces modèles dans différents environnements y compris en mode nœud unique, sur site, dans le cloud et sur appareil. La distribution sur appareil se fait via PyTorch ExecuTorch, et la distribution en mode nœud unique via Ollama.

Les distributions regroupent plusieurs fournisseurs d’API pour offrir aux développeurs un point d’accès unique. Elles incluent une interface en ligne de commande (CLI), du code client en plusieurs langages (Python, Node, Kotlin, Swift), ainsi que des conteneurs Docker pour simplifier l’intégration. Elles offrent une solution clé en main pour travailler avec les modèles Llama 3.2 dans des contextes variés.