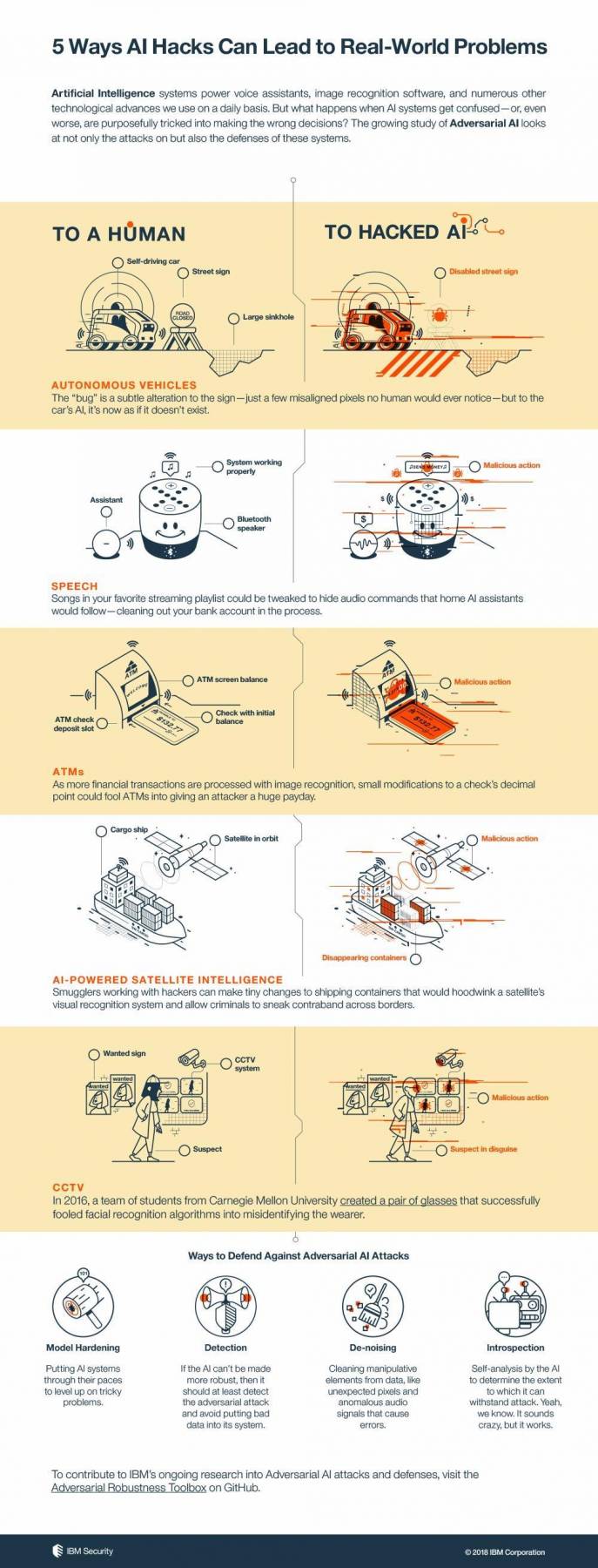

Les performances de l’intelligence artificielle ne cessent de progresser, il est toutefois encore très facile de l’induire volontairement en erreur, au moyen de ce que l’on appelle une attaque adverse (adversial attack). Le nouvel outil open source que vient de lancer le laboratoire de recherche d’IBM : L’Adversarial Robustness Toolbox a été pensé de façon à permettre aux développeurs et chercheurs en intelligence artificielle d’analyser les méthodes d’attaque adverse et mettre au point des stratégies de défense.

Proposé sur GitHub depuis quelques jours, le code contient des outils pour que les développeurs et chercheurs puissent tester leurs réseaux de neurones profonds (deep learning) et les sécuriser. Il inclut pour cela une implémentation des méthodes d’attaque et de défense les plus courantes. Comme l’ont indiqué Maria-Irina Nicolae et Mathieu Sinn de l’équipe de recherche d’IBM :

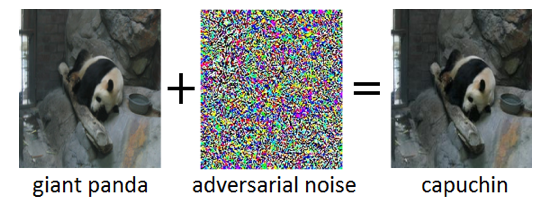

“Les Réseaux de neurones profonds sont des modèles complexes de machine learning présentant une certaine similitude avec les neurones interconnectés du cerveau humain. ILS sont capables de traiter des ENTRées de grande dimension (des millions de pixels dans des images haute résolution par exemple ), représentant dans ces ENTREES des motifs de différents niveaux d’abstraction, et reliant ces représentations à des concepts sémantiques de haut niveau.

Une propriété intrigante des réseaux de neurones profonds est que, bien qu’ils soient normalement très précis, ils sont vulnérables à des exemples dites “adverses” (adversarial). Ces attaques adverses se manifestent sous la forme d’entrées (disons des images) qui ont été délibérément modifiées pour produire une réponse souhaitée par un réseau de neurones”.

Ce type d’attaque adverse (adversarial) constitue une difficulté certaine quant au déploiement de systèmes basés sur l’intelligence artificielle, à cause des risques pour la sécurité. Des altérations d’images, de voix ou encore de vidéos peuvent être développées, sans même connaître l’architecture du réseau de neurones utilisé ou avoir accès à ses paramètres, pour tromper les algorithmes. La bibliothèque open-source proposée par IBM propose donc aux développeurs et aux chercheurs des outils pour se défendre contre ces attaques.

“La boîte à outils Adversarial Robustness est conçue pour aider les chercheurs et les développeurs à concevoir de nouvelles techniques de défense, ainsi qu’à déployer des défenses pratiques des systèmes d’IA. Les chercheurs peuvent utiliser l’Adversarial Robustness Toolbox pour évaluer les nouvelles défenses en comparaison à l’état de l’art. Pour les développeurs, la bibliothèque propose des interfaces qui prennent en charge la composition de systèmes de défense complets en utilisant des méthodes individuelles.

La bibliothèque est écrite en Python, le langage de programmation le plus couramment utilisé pour développer, tester et déployer des réseaux de neurones profonds. Il comprend des algorithmes de pointe pour créer des exemples adversarial ainsi que des méthodes pour défendre les réseaux de neurones contre ces derniers”.

Illustration officielle proposée par IBM Security :