La conférence des clients et des partenaires Intel Vision 2024 a été l’occasion pour Intel de dévoiler une suite de nouveaux systèmes évolutifs ouverts, de collaborations stratégiques pour accélérer l’adoption de GenAI et de produits de nouvelle génération. Parmi ces derniers, l’accélérateur Gaudi 3, spécialement conçu pour le calcul GenAI, une alternative hautement compétitive au Nvidia H100, selon Intel.

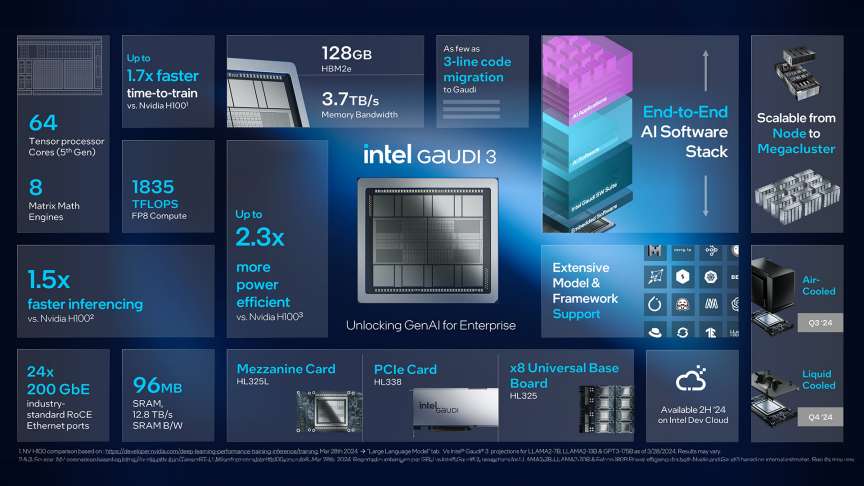

Cette nouvelle version offre des performances nettement améliorées par rapport à Gaudi 2 avec une multiplication par 4 du calcul d’IA pour BF16, une augmentation de 1,5 fois de la bande passante mémoire, et une multiplication par 2 de la bande passante réseau, permettant une évolutivité massive des systèmes.

Fabriqué selon un processus de 5 nm, doté de vingt-quatre ports Ethernet 200 gigabits intégrés, Intel Gaudi 3 est conçu pour permettre à chaque composant fonctionnel, comme le moteur de multiplication matricielle (MME), les cœurs de processeur Tensor (TPC) et les cartes d’interface réseau (NIC), de travailler simultanément, permettant ainsi d’accélérer le calcul et la mise à l’échelle des opérations de deep learning, où de nombreuses opérations doivent être effectuées en même temps sur de grandes quantités de données.

Chaque accélérateur dispose d’un moteur de calcul hétérogène composé de 64 TPC (Tensor Processor Cores) personnalisés qui peuvent être configurés pour exécuter une variété de tâches spécifiques à l’IA ainsi que de huit MME (Matrix Multiplication Engines). Chacun de ces MME peut effectuer un nombre impressionnant de 64 000 opérations parallèles, ce qui permet un haut degré d’efficacité de calcul et les rend aptes à gérer des opérations matricielles complexes, un type de calcul fondamental pour l’entraînement et à l’inférence des LLM. Cette conception permet à l’accélérateur Gaudi 3 de prendre en charge plusieurs types de données, y compris FP8 (Floating Point 8-bit) et BF16 (BFloat16), offrant ainsi une flexibilité accrue pour traiter une variété de charges de travail liées à l’IA.

L’augmentation de la mémoire, avec 128 Go de capacité HBMe2 et 3,7 To de bande passante mémoire, répond aux exigences croissantes des grands modèles de langage multimodaux, améliorant ainsi les performances et la rentabilité des charges de travail d’IA.

Pour démontrer les performances de sa nouvelle puce, Intel l’a comparé au H100, le GPU phare de NVIDIA qui domine le marché. Selon Intel, Gaudi 3 permettrait de réduire de 50% le temps d’entraînement du modèle Llama2 de paramètres 7B et 13B, ainsi que celui de GPT-3 175B.

Le débit d’inférence serait augmenté de 50% sur le modèle Llama 7B et 70B, ainsi que sur les modèles Falcon 180B tandis que l’efficacité énergétique d’inférence le serait de 40%. Intel a également comparé sa vitesse d’inférence sur ces mêmes modèles par rapport au Nvidia H200, une amélioration de 30% aurait été constatée.

“Dans le paysage en constante évolution du marché de l’IA, une lacune importante persiste dans les offres actuelles. Les commentaires de nos clients et de l’ensemble du marché soulignent le désir d’un choix accru. Les entreprises évaluent des considérations telles que la disponibilité, l’évolutivité, les performances, le coût et l’efficacité énergétique. Intel Gaudí 3 se distingue comme l’alternative GenAI présentant une combinaison convaincante de rapport qualité-prix, d’évolutivité du système et d’avantage en termes de délai de rentabilisation”.