En juin dernier, les chercheurs de Microsoft Research avaient démontré avec Phi-1, un LLM de 13 milliards de paramètres pour le code Python, que, la qualité des données d’entraînement prévalait sur leur nombre. Phi-1,5, également de 1,3B, entraîné principalement avec des données synthétiques, affiche ainsi de solides performances dans les tests de bon sens, la compréhension du langage et le raisonnement logique. Il a d’ailleurs surpassé LLAMA-2 7B dans différents benchmarks. L’équipe l’a publié en open-source exclusivement à des fins de recherche.

L’équipe de Microsoft Research travaille depuis quelque temps sur les capacités des LLM de taille réduite. En mai dernier, Ronen Eldan et Yuanzhi Li introduisaient TinyStories, un ensemble de données synthétiques de nouvelles ne contenant que des mots qu’un enfant de 3 à 4 ans comprend, générés par GPT-3.5 et GPT-4. Ils l’ont utilisé pour entraîner un modèle de seulement 10 millions de paramètres mais capable de produire du texte en anglais cohérent.

Rejoints par d’autres chercheurs de Microsoft, ils continuent à explorer les limites des modèles de petite taille et publient en juin dernier le modèle de langage Phi-1, un transformateur de 1,3 milliard de paramètres, spécialisé dans le codage Python de base. Il a été entraîné sur diverses sources de données, notamment des sous-ensembles de codes Python de The Stack v1.2, du contenu de questions-réponses de StackOverflow, du code de compétition de codecontests et des manuels et exercices Python synthétiques générés par gpt-3.5-turbo-0301. Ils ont nommé l’étude qui lui était consacrée : “Les manuels scolaires sont tout ce dont vous avez besoin”.

Les manuels scolaires sont tout ce dont vous avez besoin II: PH-1.5

Phi-1 a démontré un taux de précision impressionnant dépassant 50% sur le banc de référence de codage Python simple, HumanEval. Les chercheurs ont poursuivi leur approche consistant à utiliser les LLM pour générer des données de “qualité manuel” afin d’améliorer le processus d’apprentissage par rapport aux données Web traditionnelles.

Phi-1-5 13B a été entraîné avec l’ensemble de données existant de 7 milliards de tokens de Phi-1 et 20 milliards de tokens de données synthétiques qui lui apportent des capacités de raisonnement et des connaissances générales du monde, couvrant des domaines tels que la science, les activités quotidiennes, la théorie de l’esprit…

Les résultats

Phi-1.5 obtient des résultats comparables à Llama2-7B, Falcon-7B et Vicuna-13B sur presque tous les benchmarks de raisonnement de bon sens, la compréhension du langage et le raisonnement logique. Il surpasse LLAMA-2 7B, sur les benchmarks OpenbookQA ( questions-réponses pour mesurer la compréhension de lecture et SQUAD (EM) pour le codage.

Conclusions

L’équipe a entraîné son modèle durant deux semaines de temps sur huit GPU A100, pour un coût estimé à 1 000 dollars. Elle démontre ainsi que les modèles de langage peuvent être accessibles aux chercheurs et aux entreprises.

Pour elle, Phi-1.5 “ouvre potentiellement la voie à des systèmes d’IA plus efficaces et respectueux de l’environnement” et les résultats obtenus “remettent en question l’idée prédominante selon laquelle les capacités des modèles de langage sont uniquement déterminées par leur échelle, suggérant que la qualité des données joue un rôle encore plus important que précédemment pensé”.

Phi-1,5 n’échappe pas aux limitations des autres modèles de langage et l’équipe le publie en open source pour permettre aux chercheurs d’explorer l’apprentissage en contexte, l’atténuation des biais et les hallucinations.

De son côté, elle va augmenter son ensemble de données synthétiques pour couvrir un éventail plus large de sujets, et affiner Phi-1.5 pour des tâches plus spécifiques.

Elle conclut :

“Il est peut-être envisageable d’atteindre le niveau de compétence de ChatGPT à l’échelle d’un milliard de paramètres”.

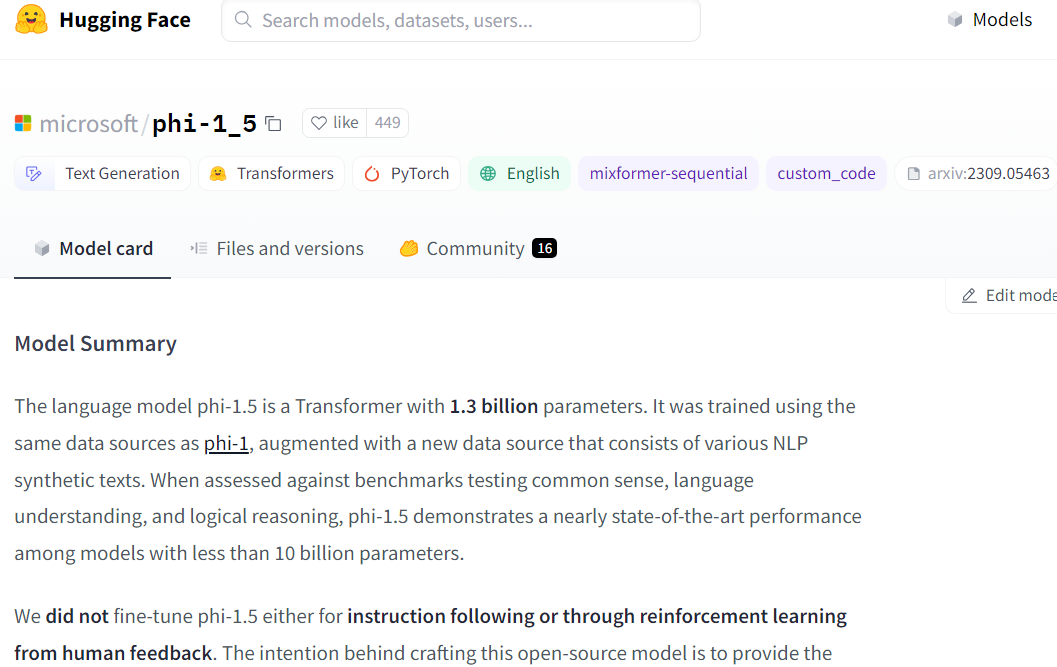

Découvrez Phi 1.5 sur Hugging Face.

Références de l’article : “Textbooks Are All You Need II: phi-1. Technical Report” https://doi.org/10.48550/arXiv.2309.05463

Auteurs : Yuanzhi Li, Sébastien Bubeck, Ronen Eldan, Allie Del Giorno, Suriya Gunasekar, Yin Tat Lee. Microsoft Research