L’AGI, ou Intelligence Artificielle Générale (IAG), fait référence à une forme avancée d’IA qui possèderait la capacité de comprendre, apprendre et exécuter n’importe quelle tâche intellectuelle humaine. Cependant, il n’existe pas de définition consensuelle de l’IAG, et les experts du domaine ont des visions différentes et parfois contradictoires. Dans un article publié sur arXiv, des chercheurs de DeepMind proposent un cadre pour classer les niveaux de performance, de généralité et d’autonomie des modèles d’IAG et de leurs précurseurs.

Contrairement à l’intelligence artificielle spécialisée, qui est conçue pour effectuer une tâche spécifique, l’IAG serait capable de s’adapter et d’exceller dans un large éventail de domaines, de manière similaire, voire supérieure, à l’intelligence humaine. Objectif de recherches au sein d’entreprises comme OpenAI, DeepMind et Meta, présentée comme une opportunité pour l’humanité, elle soulève également des inquiétudes quant à ses risques potentiels pour la société, notamment celui de perte de contrôle.

Pour les chercheurs de DeepMind, l’objectif fondamental était de créer un cadre conceptuel robuste et partagé autour de l’IAG, afin de favoriser la transparence, la collaboration et la responsabilité dans la recherche et son développement.

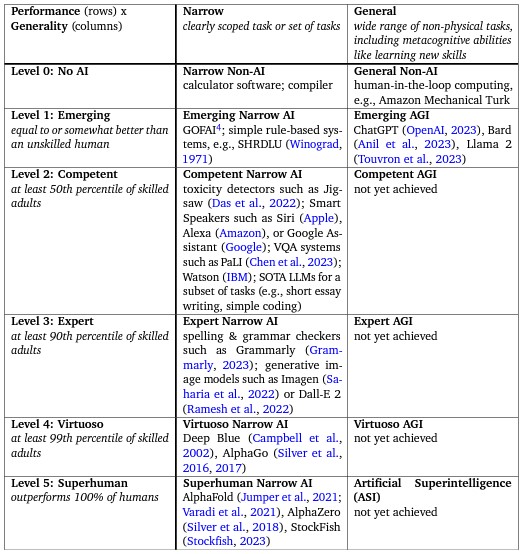

Ce cadre vise à définir et mesurer les capacités et le comportement des systèmes d’IA en fonction de leur performance et de leur généralité. Ils les ont classé du “niveau 0, sans AGI” au “niveau 5, surhumain”, chaque niveau étant associé à un ensemble de mesures/benchmarks, ainsi qu’aux risques identifiés introduits et aux changements résultants dans le paradigme d’interaction humain-IA.

Définitions existantes de l’IAG

Pour développer leur cadre, les auteurs analysent des définitions existantes de l’IAG, et proposent 9 études de cas.

- Etude de cas 1 : Le test de Turing : une tentative bien connue d’opérationnaliser un concept similaire à l’IAG. Le “jeu d’imitation” de Turing cherche à déterminer si les machines peuvent penser en demandant à un humain de distinguer si un texte est produit par un autre humain ou par une machine. Cependant, le test est critiqué pour sa facilité à tromper les gens plutôt que de mesurer réellement l’intelligence de la machine. Étant donné que les grands modèles de langage modernes réussissent certains aspects du Test de Turing, pour les chercheurs, ce critère est insuffisant pour opérationnaliser l’IAG, et ils proposent de définir l’IAG en termes de capacités plutôt que de processus.

- Etude de cas 2 : IA forte – Systèmes possédant la conscience. Le philosophe John Searle suggère que, selon l’IAF, un ordinateur correctement programmé pourrait réellement posséder une conscience. Cependant, il n’y a pas de consensus scientifique sur la détermination de tels attributs. L’IAF, bien que potentiellement un chemin vers l’IAG, présente des défis pratiques en raison de l’absence de méthodes consensuelles pour établir si les machines possèdent des attributs tels que la conscience.

- L’étude de cas 3 examine les analogies avec le cerveau humain, soulignant que l’origine du terme “intelligence artificielle générale” remonte à un article de 1997 sur les technologies militaires. Cette définition initiale met l’accent sur les processus basés sur le cerveau humain, bien que les architectures modernes de réseaux neuronaux ne nécessitent pas strictement ces processus.

- L’étude de cas 4 porte sur la performance au niveau humain sur les tâches cognitives : en 2001, l’IAG a été décrite comme une machine capable de réaliser des tâches cognitives typiques des humains. Cependant, des ambiguïtés subsistent quant aux tâches spécifiques et aux personnes visées par cette définition.

- Etude de cas 5 : la capacité d’apprendre des tâches. Shanahan considère l’IAG comme une intelligence artificielle capable d’apprendre un large éventail de tâches, mettant l’accent sur la valeur d’inclure des tâches métacognitives (apprentissage) parmi les exigences pour atteindre l’IAG.

- Etude de cas 6 : le travail économiquement valable : les IAG sont envisagées comme des systèmes hautement autonomes surpassant les humains dans la plupart des travaux économiquement précieux. Cette définition se concentre sur la performance indépendamment des mécanismes sous-jacents, mais il ne capture pas tous les critères qui peuvent faire partie de “l’intelligence générale”.

- L’étude de cas 7, Marcus, décrit l’IAG comme toute intelligence flexible et générale, comparable à l’intelligence humaine. Il propose des tâches concrètes pour opérationnaliser cette définition.

- L’étude de cas 8 introduit le concept d’Intelligence Artificielle Capable (IAC), soulignant la capacité de réaliser des tâches complexes et multi-étapes dans le monde réel, avec un accent économique spécifique.

- Etude de cas 9 : SOTA LLMs comme généralistes : les modèles linguistiques de pointe (LLM) sont déjà des IAG en raison de leur capacité à traiter et comprendre un large éventail de sujets et de tâches, à partir d’exemples zéro-shot ou peu-shot. Ce cadre se concentre sur la généralité, mais néglige la performance et la fiabilité.

Les 6 principes nécessaires à la définition de l’IAG

Ces neuf analyses de définitions existantes de l’IAG, (ou de concepts associés à l’IAG), ont permis aux chercheurs d’identifier des propriétés pouvant contribuer à une définition claire et opérationnelle de l’IAG. Pour eux, une ontologie utile pour l’IAG doit, entre autres :

- Se concentrer sur les capacités plutôt que sur les mécanismes ;

- Évaluer séparément la généralité et la performance ;

- Se focaliser sur les tâches cognitives et métacognitives (plutôt que physiques) ;

- Se concentrer sur le potentiel plutôt que sur la mise en œuvre ;

- Se focaliser sur la validité écologique pour les tâches de référence

- Définir des étapes le long du chemin vers l’IAG, plutôt que de se focaliser sur le point final.

Avec ces principes à l’esprit, les auteurs proposent une matrice de cinq niveaux de performance (de “émergent” à “surhumain”) et deux niveaux de généralité (de “étroit” à “général”). Ils donnent des exemples de systèmes existants qui correspondent à chaque cellule de la matrice, dans le tableau ci-dessous :

Ils discutent ensuite des exigences difficiles pour les futurs benchmarks qui quantifient le comportement et les capacités des modèles d’IAG par rapport à ces niveaux et de la façon dont ces niveaux d’IAG interagissent avec des considérations de déploiement telles que l’autonomie et le risque. Pour finir, ils soulignent l’importance de choisir soigneusement les paradigmes d’interaction homme-IA pour un déploiement responsable et sûr des systèmes d’IA hautement capables.

Références de l’article : “Levels of AGI: Operationalizing Progress on the Path to AGI” arXiv:2311.02462v2 [cs.AI] 5 Jan 2024

Auteurs : Meredith Ringel Morris, Jascha Sohl-dickstein, Noah Fiedel, Tris Warkentin, Allan Dafoe, Aleksandra Faust, Clement Farabet, Shane Legg, Google DeepMind