En avril dernier, Stability AI, après s’être intéressée à la génération d’images avec Stable Diffusion, publiait la version Alpha de StableLM, une suite de modèles de langage open source, disponible en 3 et 7 milliards de paramètres sur GitHub. Elle a lancé récemment le lancement d’une extension de StableLM-3B-4E1T, l’un deux : le modèle de chat Stable LM Zephyr 3B.

La suite StableLM peut générer du texte et du code et alimenter une gamme d’applications en aval. Stability AI déclarait en avril dernier :

“La version Alpha open-source de StableLM met en avant la puissance des modèles petits et efficaces capables de générer du texte et du code performants localement sur des appareils personnels”.

Ce que la société démontre aujourd’hui avec Stable LM Zephyr 3B, qui en dépit de sa petite taille, montre des capacités impressionnantes mais, grâce à elle, ne nécessite pas une grande puissance de calcul pour fournir rapidement des réponses précises. Ce qui lui permet d’être déployé efficacement sur une large variété d’appareils, y compris les smartphones et les ordinateurs portables.

Selon Stability AI, ce nouveau LLM, offrant des capacités de génération de texte, de résumé et de personnalisation de contenu, optimisé pour le suivi d’instructions et les tâches de type questions-réponses, s’inspire du modèle Zephyr 7B de HuggingFace, qui est lui-même une version affinée de Mistral-7B v0,1 de Mistral AI.

Stability AI s’est en effet inspirée du pipeline d’entraînement de Zephyr 7B, en utilisant l’optimisation des préférences directes (DPO) pour Stable LM Zephyr 3B.

L’entraînement a débuté avec une première étape de réglage fin supervisé sur plusieurs jeux de données d’instructions, notamment UltraChat, MetaMathQA, Evol Wizard Dataset et Capybara Dataset. La deuxième étape a consisté à aligner le modèle sur l’algorithme d’optimisation des préférences directes (DPO) à l’aide du jeu de données UltraFeedback, provenant du groupe de recherche OpenBMB, comprenant 64 000 prompts et réponses de modèles correspondantes.

Performances du modèle

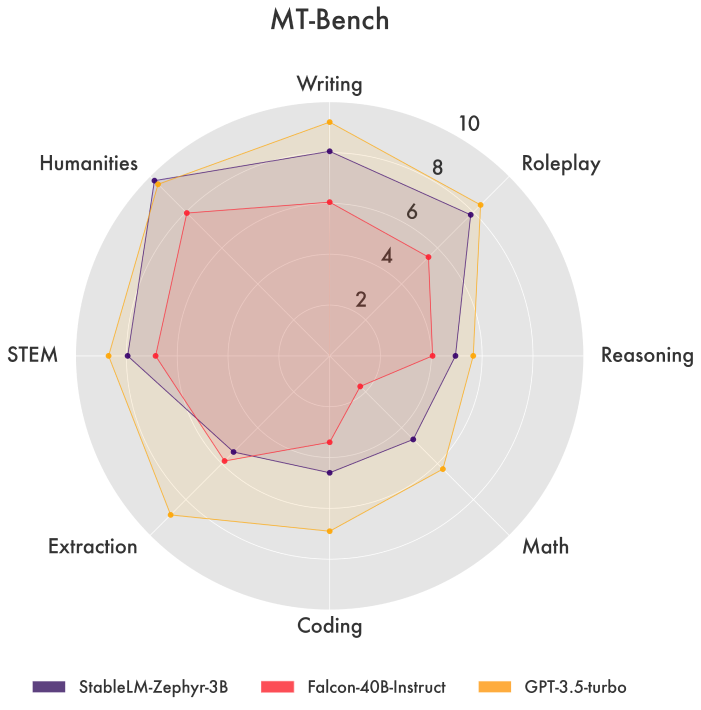

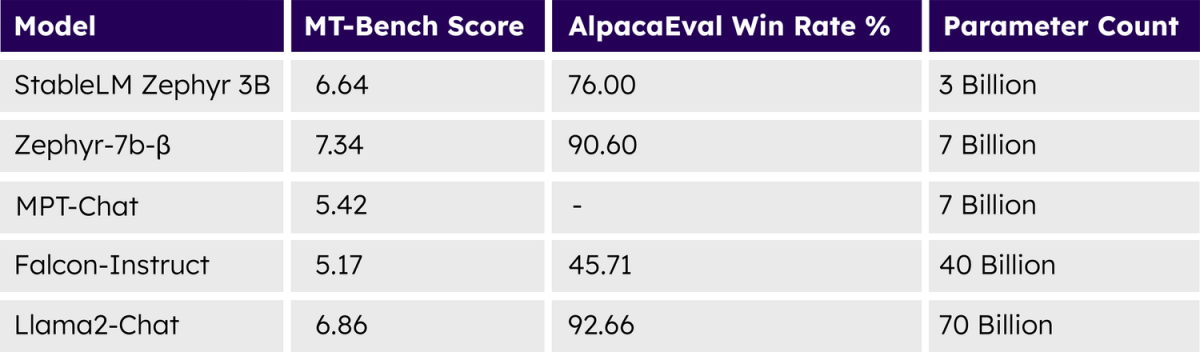

Stability AI a évalué son modèle sur les plateformes MT Bench et AlpacaEval où Stable LM Zephyr 3B a démontré des capacités supérieures à générer des textes contextuellement pertinents, cohérents et linguistiquement précis.

Lors de ces tests, les performances du Stable LM Zephyr 3B se sont avérées compétitives par rapport à plusieurs modèles de plus grande taille, tels que Falcon-4b-Instruct, WizardLM-13B-v1, Llama-2-70b-chat et Claude-V1.

Ces résultats compétitifs par rapport à des modèles de plus grande taille soulignent la pertinence de l’approche DPO pour un modèle de seulement 3 milliards de paramètres, mettant en lumière la puissance et l’efficacité intrinsèques à ce nouveau modèle.

Stable LM Zephyr 3B ouvre des perspectives prometteuses pour une intégration plus accessible et pratique de l’IA générative dans une gamme variée d’applications du monde réel.