L’intelligence artificielle est de plus en plus utilisée dans l’astrophysique : récemment, plusieurs chercheurs japonais ont exploité le deep learning pour mieux observer et comprendre l’Univers. Toujours dans le secteur de la cosmologie, l’Université de Paris a tiré pari des Intelligence Processing Unit (IPU) de Graphcore afin d’accélérer la recherche dans le domaine. Les réseaux de neurones utilisés ont ainsi pu être entraînés plus rapidement.

La problématique des données de simulation de plus en plus volumineuses et complexes

C’est dans une étude publiée au début du mois de juin que le chercheur Bastien Arcelin décrit deux études de cas impliquant le deep learning : la création d’une image de galaxie et l’estimation de la forme d’une galaxie. Ces recherches ainsi que celles qui seront mises en place à l’avenir produisent une quantité conséquente de données issues d’observations. Pour donner une idée de ce que cela peut représenter, le projet Vera C. Rubin Observatory’s Legacy Survey of Space and Time (LSST) devrait générer 20 téraoctets (1012) de données chaque nuit, soit environ 60 pétaoctets (1015) au bout de dix ans.

Afin de traiter ces données, les chercheurs en cosmologie se tournent vers les réseaux de neurones pour mieux gérer ces ensembles de données de plus en plus conséquents. Les données de simulation étant également complexes et nombreuses, le réseau de neurones associé doit être rapide, précis et, dans certains cas, capable de caractériser avec exactitude l’incertitude épistémique.

Une problématique s’est dégagée : des équipements conçus spécifiquement pour l’IA ont-ils des performances supérieures aux équipements standards pour l’apprentissage profond en cosmologie ? Pour les besoins de l’étude, les performances d’une puce Graphcore de première génération (la GC2 IPU) ont été comparées à celles du processeur Nvidia V100 GPU.

Estimation des paramètres de forme de galaxie à l’aide des réseaux de neurones

Bastien Arcelin, chercheur à l’Université de Paris, a développé une nouvelle technique impliquant des réseaux de neurones profonds et des couches convolutives capables de mesurer les paramètres d’ellipticité des galaxies isolées et superposées. Il a ensuite testé sa technique avec un réseau de neurones déterministes et sur un réseau bayésien (un modèle graphique probabiliste) :

- Pour les réseaux de neurones : une fois entraînés, les paramètres des réseaux déterministes sont associés à une valeur fixe et ne changent plus, même si la même image de galaxie isolée est ajoutée deux fois au réseau.

- Pour les réseaux bayésiens : les poids sont associés à des distributions de probabilité et non à des valeurs uniques. Par conséquent, si vous ajoutez deux fois la même image au réseau, vous obtenez deux échantillons différents de distributions de probabilité, et donc deux résultats légèrement différents.

Les IPU de Graphcore exploités dans les futures études cosmologiques

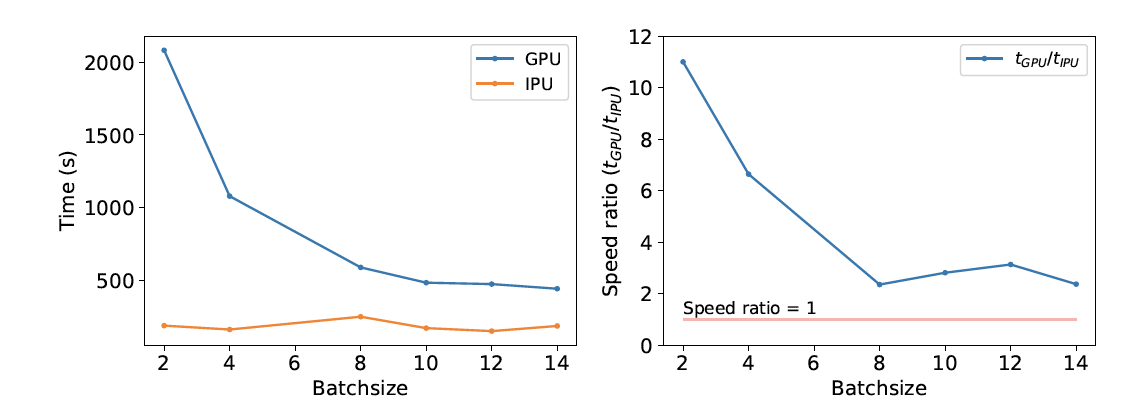

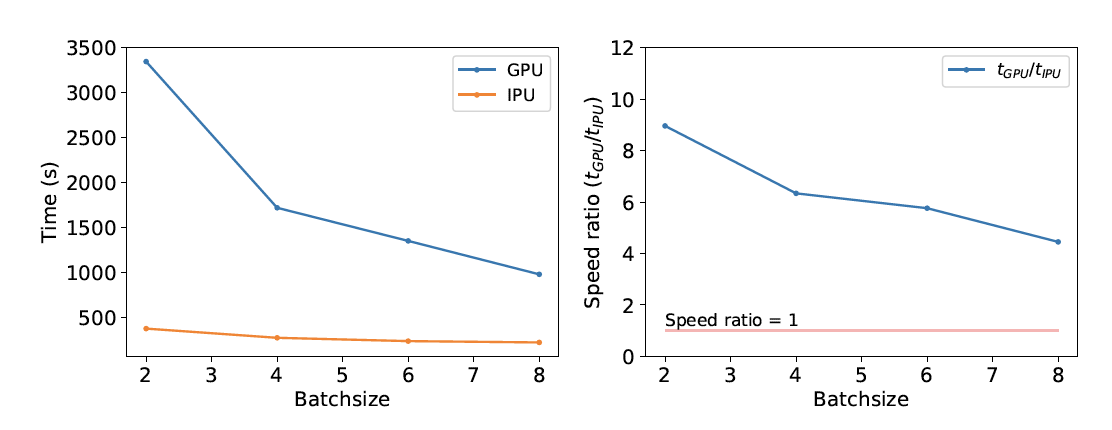

Dans le cadre de l’entraînement de petits lots, l’IPU s’est révélée deux fois plus rapide que le GPU avec les réseaux profonds, et au moins 4 fois plus rapide avec les réseaux bayésiens. L’IPU GC2 a pu atteindre de telles performances en consommant deux fois moins d’énergie que le GPU.

Selon Graphcore, cette étude a montré que la technologie IPU permet d’accélérer de façon considérable la phase d’entraînement pour les estimations de paramètres des formes de galaxie, et qu’un IPU propose de meilleurs résultats avec des lots de petite taille. Pour les lots plus importants, il est possible d’utiliser plusieurs IPU afin d’améliorer les performances.