En juin dernier, Graphcore et Aleph Alpha, deux leaders européens de l’IA, annonçaient qu’ils allaient collaborer dans le cadre la recherche et du déploiement des modèles multimodaux avancés d’Aleph Alpha, notamment Luminous, sur les systèmes IPU de Graphcore et le Good Computer de nouvelle génération. Mi-novembre, les partenaires ont dévoilé le premier fruit de leurs travaux : le modèle de langage « Luminous Base » de 13 milliards de paramètres clairsemé à seulement 2,6 milliards de paramètres.

Graphcore, créée en 2016, est une société britannique de semi-conducteurs qui développe des accélérateurs pour l’IA et le machine learning. La société a mis au point une « Intelligence Processing Unit », ou IPU, un microprocesseur que l’on retrouve sur les systèmes de calcul IPU-POD pour datacenter de Graphcore.

Ce nouveau type de processeur a été spécialement conçu afin de répondre aux besoins spécifiques et uniques requis pour l’IA et le ML. Il se caractérise, entre autres, par un parallélisme granulaire, une arithmétique à simple précision et la prise en charge de la sparsité. Les systèmes IPU de Graphcore accélèrent lIA et offrent un avantage concurrentiel dans les services financiers, les soins de santé, l’Internet grand public, la recherche universitaire et de nombreux autres domaines…

L’IPU-POD 64, utilisé pour cette architecture de références, permet de maximiser l’espace et la puissance disponibles des centres de données, quelle que soit la manière dont il est provisionné. Il peut fournir jusqu’à 16 petaFLOPS de calcul IA pour la formation et l’inférence pour développer et déployer sur le même système puissant.

Aleph Alpha

Créée en 2019, basée à Heidelberg en Allemagne, la start-up Aleph Alpha a été reconnue par l’indice technologique MAD 2021 (Machine Learning, AI and Data Landscape), comme la seule entreprise européenne d’IA à mener des activités de recherche, de développement et de conception d’intelligence artificielle générale (IAG) généralisable. Elle a récemment ouvert Alpha One, un centre de données d’IA commercial sur le GovTech Campus Germany. Son ambition est de faire de l’UE un acteur majeur dans le domaine de l’IA et de consolider sa souveraineté numérique.

Aleph Alpha développe des modèles multimodaux originaux, notamment Luminous, combinant la vision par ordinateur avec le traitement du langage naturel (NLP) pour traiter, analyser et produire un large éventail de textes, présenté à l’International Supercomputing Conference (ISC) l’an passé. Ce modèle est basé sur la méthode MAGMA (Multimodal Augmentation of Generative Models through Adapter-based Finetuning) développée par la société.

Jonas Andrulis, PDG et fondateur d’Aleph Alpha, déclare :

« Toute la diversité linguistique et culturelle de l’Europe doit se refléter dans les applications modernes de l’IA, car c’est le seul moyen pour chaque pays européen, grand ou petit, de bénéficier du potentiel des nouvelles technologies de l’IA. Cela garantit que le meilleur de l’IA n’est pas réservé à quelques-uns, mais est disponible pour tous de manière égale. Avec LUMINOUS et MAGMA, nous faisons un grand pas dans cette direction. Pour aller de l’avant, nous voulons travailler avec des partenaires pour nous assurer qu’en Europe, nous prenons notre destin numérique en main. »

Les deux partenaires ont présenté une variante clairsemée du chatbot commercial Luminous d’Aleph Alpha, au SC22 au Texas.

Luminous Base Sparse n’utilise que 20% des FLOPs de traitement et 44% de la mémoire de son équivalent dense. D’autre part, ses paramètres de 2,6 milliards peuvent être entièrement conservés dans la mémoire sur puce ultra-rapide d’un IPU-POD Classic, optimisant ainsi les performances.

Réduction des paramètres

Des grands modèles de langage comme GPT-3 d’OpenAI ou Gopher de deepMind reposent sur plus de cent milliards de paramètres, les prochains en compteront encore plus, exigeant une puissance de calcul de plus en plus grande.

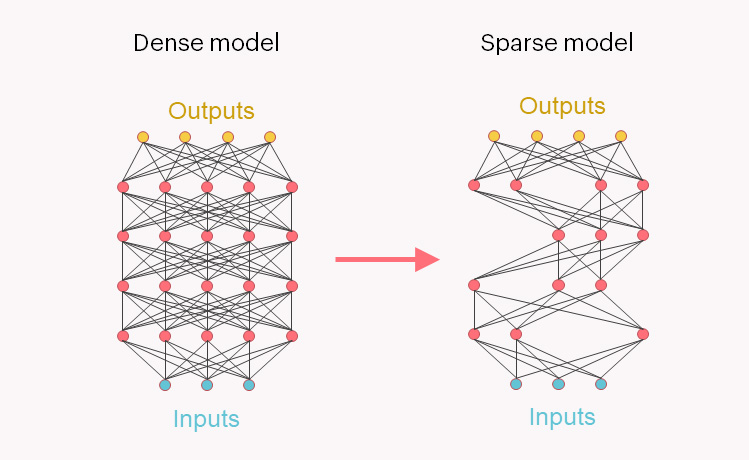

La plupart utilisent actuellement des modèles denses, où une représentation et un calcul égaux sont donnés à tous les paramètres, qu’ils contribuent ou non au comportement du modèle. Aleph Alpha et Graphcore ont supprimé les 80 % de poids les moins pertinents et réentraîné le modèle Luminous Base Sparse en utilisant uniquement les poids importants. Ceux-ci sont représentés à l’aide du format Compressed Sparse Row (CSR).

Les FLOPS de calcul requis pour l’inférence sont tombés à 20 % du modèle dense, tandis que l’utilisation de la mémoire a été réduite à 44 %, car une capacité supplémentaire est nécessaire pour stocker les informations d’emplacement et de valeur pour les paramètres non nuls restants. Par ailleurs, le modèle obtenu a permis de baisser le besoin énergétique de 38 % par rapport au modèle dense.

Sélectionner les paramètres importants

Selon Graphcore et Aleph Alpha, la parcimonie est considérée comme un contrepoids important à la croissance exponentielle de la taille des modèles d’IA et à l’augmentation correspondante de la demande de calcul.

Les modèles pour le langage, la vision et les modèles multimodaux nécessitent une mise à l’échelle des paramètres, augmentant ainsi les coûts de leur exploitation. La sélection des paramètres permettrait aux sous-modèles spécialisés de fonctionner plus efficacement et aux startups d’IA telles qu’Aleph Alpha, de déployer des modèles hautement performants avec des exigences de calcul minimales pour les clients.