Lors de sa conférence Google I/O 2024, Google a présenté VEO, un modèle text-to-video mais les vidéos qu’il génère manquent d’une composante essentielle : le son, ce à quoi DeepMind travaille. Il a dernièrement partagé les avancées de sa technologie vidéo-audio (V2A) qui combine des pixels vidéo avec des invites textuelles pour générer des bandes sonores synchronisées.

Si le modèle V2A peut être associé à des modèles de génération vidéo comme Veo pour créer des effets sonores, de la musique et des dialogues adaptés à chaque scène, il peut également ajouter des bandes sonores à des séquences variées, telles que des films muets, des documents d’archives et plus encore, élargissant ainsi les possibilités créatives.

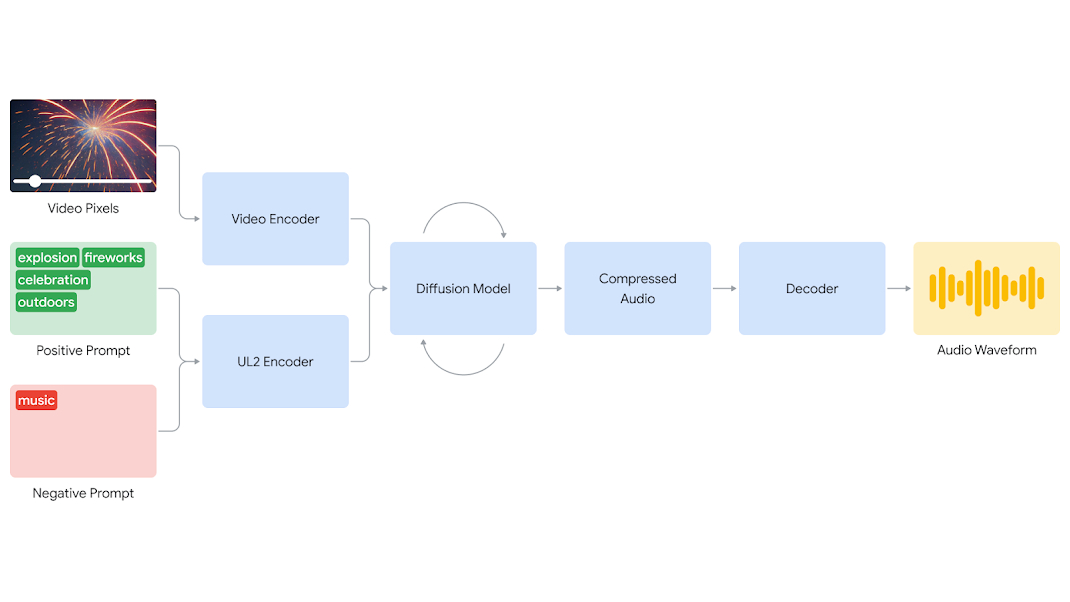

V2A permet aux utilisateurs d’avoir un contrôle précis sur la sortie audio. Grâce à des invites positives et négatives, les créateurs peuvent orienter la génération sonore vers des sons spécifiques ou éviter ceux qui ne conviennent pas. Cette flexibilité facilite l’expérimentation rapide de différentes options audio, permettant ainsi de choisir la meilleure correspondance pour chaque vidéo.

Processus de Génération

Le système V2A commence par encoder l’entrée vidéo dans une représentation compressée. Ensuite, un modèle de diffusion affine de manière itérative l’audio à partir de bruit aléatoire, guidé par les pixels vidéo et les invites textuelles. Finalement, l’audio généré est décodé en une forme d’onde et synchronisé avec la vidéo.

Pour améliorer la qualité et la pertinence des sons générés, V2A utilise des annotations et des transcriptions détaillées lors de son entraînement. Cette méthode permet au système d’apprendre à associer des événements audio spécifiques à diverses scènes visuelles, créant ainsi une synchronisation audio-vidéo convaincante.

Défis et limitations

Selon DeepMind, V2A se distingue des solutions vidéo-audio existantes car elle peut comprendre les pixels bruts et l’ajout d’une invite textuelle est facultatif.

Malgré ses avancées, V2A doit encore surmonter certains défis. La qualité de l’audio généré dépendant de celle de l’entrée vidéo, elle peut être affectée par les artefacts ou distorsions présents dans la vidéo. Il peut y avoir également une mauvaise synchronisation entre les dialogues avec les mouvements des lèvres, si le modèle text-to-vidéo n’est pas aligné avec les transcriptions.

Invite pour l’audio : Musique, Transcription : “cette dinde a l’air incroyable, j’ai tellement faim”.

Engagement éthique et sécurité

DeepMind développe V2A en collaboration avec des créateurs et cinéastes de renom pour s’assurer d’un impact positif. De plus, pour prévenir les abus potentiels, tout contenu généré est filigrané grâce à la boîte à outils SynthID. Avant une diffusion publique, V2A sera soumis à des tests de sécurité rigoureux pour garantir son efficacité et sa sûreté.