Nous allons tenter, dans cet article, de passer en revue les différentes intentions ou pensées controversées qui sont souvent prêtées à l’intelligence artificielle.

L’intelligence artificielle est-elle homophobe?

Une actualité mentionnant les travaux menés par Kerry Kawakami et M. Lynne Cooper chercheurs à l’université de Stanford fait actuellement le tour du web. Ces chercheurs se sont basés sur la base de données d’un site de rencontre afin d’analyser les photos de 35.000 de ses membres. Ils ont utilisé les données renseignées sur leur orientation sexuelle afin d’entraîner un réseau de neurones. Selon certains articles, l’intelligence artificielle “traquerait” les homosexuels en se basant sur la morphologie de leur visage.

Cet usage est discutable, nous pouvons imaginer toutes sortes de dérapages. Il convient toutefois d’insister sur le fait que l’intelligence artificielle n’est rien d’autre qu’un outil scientifique puissant sans compréhension du monde. Il se base sur les mathématiques et est absolument objectif, ce qui n’est pas forcément le cas des scientifiques qui l’exploitent.

L’intelligence artificielle basée sur des réseaux de neurones permet d’établir des liens entre des entrées et des sorties. C’est à dire par exemple, entre des causes et des conséquences, entre des images et les tags qui leur sont associés.

En revanche, jusqu’à preuve du contraire, une IA ne se “réveille” pas un beau matin en décidant de tenter de reconnaître l’orientation sexuelle des gens. Ce sont les chercheurs qui sélectionnent les jeux de données étudiés et les caractéristiques à y analyser. Toute utilisation de l’IA part donc forcément d’un postulat de la part de chercheurs. Dans le cas de la recherche menée par Kerry Kawakamii et M. Lynne Cooper, l’intelligence artificielle cherche à détecter l’orientation sexuelle en fonction des visages, parce que, et uniquement parce que, ces chercheurs supposaient qu’il était possible de détecter l’orientation sexuelle d’une personne à partir de sa morphologie. Ils ont donc entraîné l’intelligence artificielle pour qu’elle le fasse.

Pour ce faire, l’intelligence artificielle ne peut se baser que sur des critères visibles à l’œil nu. Or, si l’on cherche à distinguer l’orientation sexuelle d’une personne en la voyant, il n’est pas rare de se tromper. Il serait plus juste de dire que l’intelligence artificielle est capable, tout comme un humain, de reconnaître les clichés et stéréotypes qu’elle a été entraînée à reconnaître.

Permet-elle pour autant de détecter l’homosexualité comme semblent l’indiquer certains articles? Non. Penser qu’une IA est capable d’une telle (inutile) prouesse est d’autant plus inquiétant que l’informatique est souvent reconnue comme neutre. Ce que les ordinateurs indiquent est pris comme une vérité générale et indiscutable. Que penser des faux-positifs dans ce cas ?

L’intelligence artificielle est elle raciste?

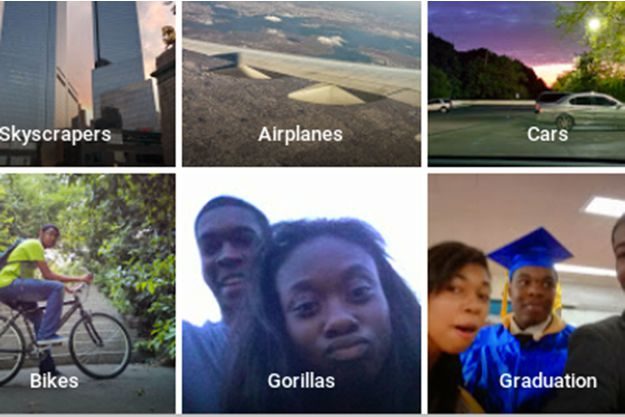

L’image de présentation de cet article est liée à l’un des plus gros bad buzz qu’a connu Google en matière d’intelligence artificielle. Son système d’IA a tagué une photo représentant deux personnes afro-américaines comme étant des gorilles. L’intelligence artificielle a-t-elle fait preuve de racisme ? Absolument pas. Nous pouvons parfaitement imaginer la stupeur de ces personnes lorsqu’elles ont vu le tag associé à la photo et comprendre qu’elles aient pu se sentir offensées. Mais l’intelligence artificielle ne met pas de sens derrière les choses. Elle fait simplement, rappelons-le, des calculs et rapprochements de façon froide et mathématique. Mais cette réponse est encore une fois incomplète. Elle pourrait laisser germer dans des esprits perturbés l’idée qu’il s’agit de la preuve que ces personnes sont mathématiquement proches d’être des gorilles. Et puisque l’ordinateur viendrait conforter leur opinion farfelue, leurs convictions seraient renforcées.

Le système a simplement tenté d’associer à la photo le tag le plus fréquemment associé aux images les plus proches d’un point de vue graphique.

Si vous entraînez un réseau de neurones à taguer des photos en ne lui proposant un jeu d’entraînement constitué que de 3 photos :

– une photo représentant une orange, centrée dans l’image;

– une photo représentant une personne, de la tête aux pieds, de dos;

– une photo de votre main.

Puis que vous soumettez à ce réseau de neurones votre photo d’identité, il associera la photo soumise avec la photo la plus proche graphiquement, donc celle de l’orange. Si vous lui soumettez une photo d’un chimpanzé de dos, il l’associera avec la photo de la personne de la tête aux pieds, de dos. Non pas parce que l’ordinateur “croit reconnaître” ces éléments dans les images, mais parce que les silhouettes et coloris sont les plus proches des images avec lesquelles elles ont été associées.

En revanche, si le réseau de neurones est entraîné avec un jeu de photos plus riche, incluant des photos d’identités et des chimpanzés de dos, alors les associations seront correctes.

Ce que nous dit le tag “Gorillas” associé à la photo taguée par Google n’est pas que ces personnes sont des gorilles, mais que la photo la plus proche dans la base ayant servi d’entraînement au réseau neuronal de Google était une photo de gorilles. Pour cela, il suffit par exemple qu’une photo cadrée de façon sensiblement similaire, représentant deux gorilles selon une composition analogue (emplacement des visages des gorilles dans la photo) soit présente dans le jeu d’entraînement.

Alors, pourquoi ce type de problème est-il moins fréquent avec des personnes caucasiennes? La qualité et l’objectivité du jeu de données utilisé pour entraîner un réseau de neurones représentent un biais important. Selon les données démographiques des employés de Google, 56% d’entre eux sont blancs, 35% asiatiques, 4% hispaniques et seulement 2% noirs. Sans prêter la moindre intention raciste aux équipes de Google, ce déséquilibre peut provoquer un biais inconscient.

Si l’échantillon du jeu de données représentant des personnes noires est trop pauvre, il est logique qu’il donne lieu à plus de problèmes de ce type, à l’image de notre orange dans l’exemple décrit ci-dessus. Et puisque les employés, majoritairement blancs, vont surtout tester le système avec leurs photos, celles de leurs familles ou proches, ils ne vont pas se rendre compte de ces problèmes. Google en a d’ailleurs pris conscience et forme ses employés contre ce biais depuis 2013.

La qualité d’une intelligence artificielle est intimement liée à la rigueur technique du data scientist qui se cache derrière et nous pouvons distinguer trois biais:

- L’intention de son concepteur:

L’intelligence artificielle est un outil qui peut être appliqué à tout et n’importe quoi. Attendons nous à voir dans le futur de nombreuses dérives reposant sur des clichés. Par exemple, une intelligence artificielle destinée à détecter si une personne est de confession juive à partir de son compte bancaire. Si une intelligence artificielle tente de tirer des conclusions de quelque chose, c’est que quelqu’un a eu l’idée de l’entraîner pour. Or des apprentis sorciers ont de tout temps essayé d’expliquer ou de prédire toutes sortes de choses en cherchant à s’appuyer sur des méthodes scientifiques ou pseudo-scientifiques. - La bonne identification des causes et conséquences:

Une intelligence artificielle fait des calculs, mais la pertinence de ceux-ci est totalement conditionnée par l’humain qui doit sélectionner les entrées et sorties. Il est par exemple tout à fait possible d’entraîner une intelligence artificielle en lui soumettant des longueurs de cheveux en entrée et des revenus en sortie. Elle détectera que les personnes ayant les cheveux les plus courts gagnent généralement plus d’argent. Certains risquent alors de bêtement recommander de se raser les cheveux pour gagner plus. Mais est-ce parce que ces personnes on les cheveux plus courts qu’elles gagnent plus, ou parce qu’il s’agit majoritairement d’hommes, et que les hommes dégarnis, plus âgés, gagnent probablement plus que des apprentis? Il aurait été plus utile d’entraîner le réseau de neurones à estimer le salaire en fonction du diplôme, de la branche sectorielle, du sexe et de l’âge de la personne. - La qualité des jeux de données

En plus d’être objectifs et de source fiable, les jeux de données utilisés doivent être les plus impartiaux possible. Cette impartialité ne se mesure pas qu’au niveau de l’honnêteté des données, mais également en terme de représentativité, étant donné que l’intelligence artificielle repose sur des notions statistiques. Dans le cas de Google, les employés étaient très certainement de très bonne volonté. Ils n’auraient probablement pas laissé passer des données volontairement biaisées, mais le manque de représentativité était un biais involontaire en tant que tel.

Pour conclure, il est important que tout le monde prenne l’intelligence artificielle pour ce qu’elle est, ni plus ni moins, et analyse les conclusions qu’elle semble tirer avec détachement et recul, sans lui prêter la moindre intention particulière. Tant qu’une IA forte ne sera pas mise au point, lui prêter la moindre intention relèvera de la pure fiction.

Si cet article vous a plus, partagez-le à votre tour avec le plus grand nombre afin de nous aider à éduquer, à notre petit niveau, la société à l’IA.