TLDR : Mistral AI가 Magistral이라는 추론 모델을 발표하여 DeepSeek에 도전하고 있다. Magistral은 설명 가능한 AI와 기업 운영에 적합한 AI를 목표로 하고 있으며, 다양한 언어를 지원하는 단계별 추론 과정을 제공한다.

목록

지난 1월 말, 모두의 시선이 DeepSeek과 그들의 모델 R1에 집중되어 있을 때, Mistral AI는 조용히 Small 3을 소개하면서 향후 개선된 추론 능력을 가진 Mistral 모델의 등장을 예고했다. 그리고 마침내 그 결과물이 나왔다. 지난 3월에 발표된 Small 3.1 이후, 이 유니콘 기업은 대규모 추론 모델 Magistral을 공개했다. 이는 오픈 소스인 "Magistral Small"과 기업용 "Magistral Medium"의 두 가지 변형으로 제공된다.

Magistral을 통해 Mistral AI는 새로운 단계를 밟고 있다. 단지 크기 경쟁이 아니라, 설명 가능한 인공지능, 인간의 추론에 더욱 밀접하게 연결된 AI, 그리고 특히 기업의 운영 현실에 더욱 적합한 AI를 추구하고 있다. 새로운 모델은 Small 3.1의 발전을 기반으로 하여 영어, 프랑스어, 스페인어, 독일어, 이탈리아어, 아랍어, 러시아어, 그리고 간체 중국어를 포함한 다양한 언어를 지원한다. 이는 사용자의 언어로 추적 가능하고, 질의 가능하며, 감사 가능한 체계적인 추론 과정을 구현하고 있다.

Magistral Small

Mistral AI는 Magistral Small을 Apache 2.0 라이선스로 공개하여 커뮤니티가 이를 사용, 개선 및 다양한 사용 사례에 배포할 수 있도록 하였다. 이는 https://huggingface.co/mistralai/Magistral-Small-2506 에서 다운로드할 수 있다.

이 버전은 Magistral Medium이 상호작용 중 생성한 추론 흔적을 기반으로 한 감독된 미세 조정(SFT)을 통해 최적화되었고, 강화 학습(RLHF)을 통해 추론의 품질과 일관성을 더욱 향상시켰다.

Small 3 모델처럼 240억 개의 매개변수를 가진 Magistral Small은 양자화되면 RTX 4090 GPU가 장착된 PC나 32GB RAM을 가진 Mac과 같은 접근 가능한 하드웨어 구성에서도 배포할 수 있어 개발자들이 중앙 집중식 클라우드 인프라에 의존하지 않고 민감한 데이터를 제어할 수 있다.

Magistral Medium

이 변형은 Magistral의 기업용 버전이다. 더욱 강력한 성능을 자랑하며, Mistral의 플랫폼인 Le Chat과 기업의 API를 통해 사용할 수 있다. 현재 Amazon SageMaker에 배포되어 있으며, 곧 IBM WatsonX, Azure AI 및 Google Cloud Marketplace에서도 제공될 예정이다.

유니콘 기업에 따르면, Chat 내의 Flash Answers는 응답 지연 시간을 대폭 줄여준다. 그에 따르면, Magistral Medium은 많은 경쟁자들보다 최대 10배 빠른 처리 속도를 자랑한다.

Magistral의 성능

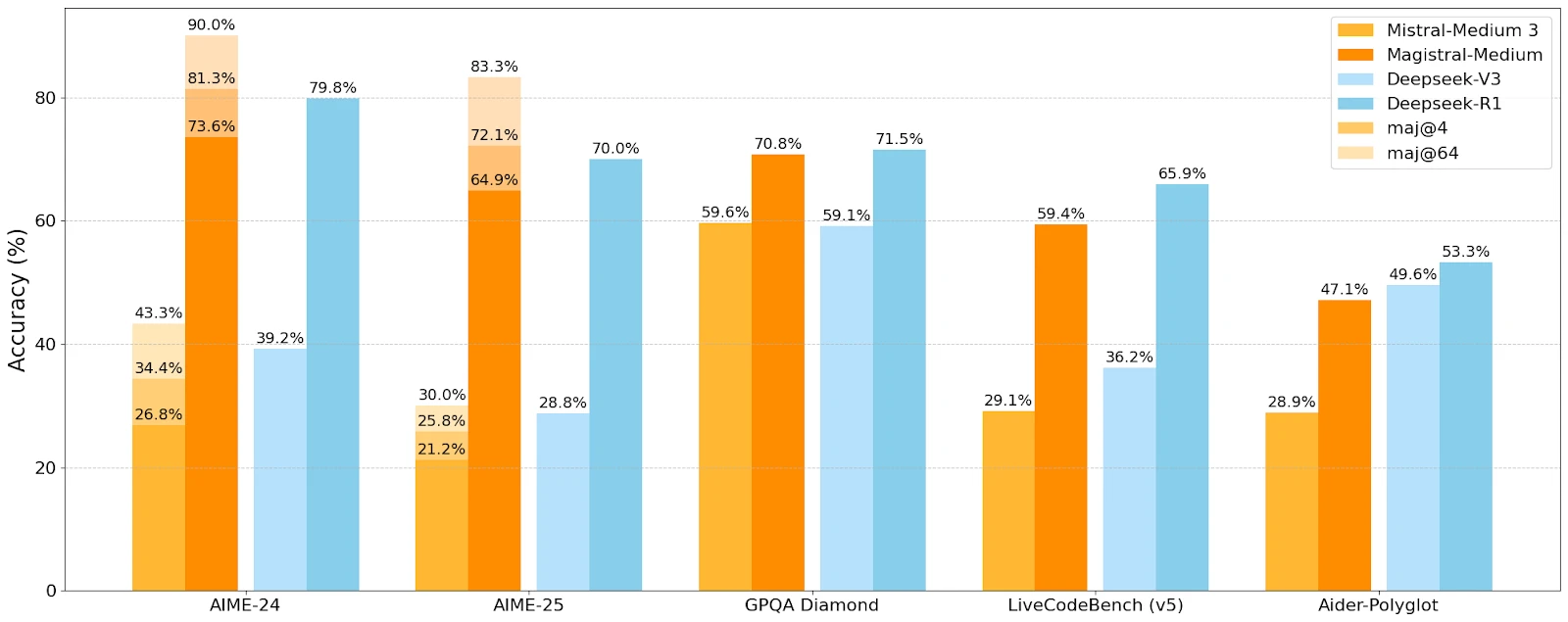

Mistral AI는 다양한 추론 및 이해 벤치마크에서 Magistral의 성능을 Mistral Medium 및 DeepSeek의 경쟁 모델과 비교했다.

Magistral-Medium은 모든 벤치마크에서 Mistral-Medium 3을 능가하여 향상된 추론의 효과를 입증했다. AIME 2024 벤치마크에서 Medium은 73.6%의 점수와 90%의 다수결 투표를 기록했으며, 이는 Small의 70.7%와 83.3%를 초과하는 결과이다. 경쟁력 있는 결과를 보여주었으나, 일부 벤치마크에서는 여전히 DeepSeek이 우위를 점하고 있다.

잘 맞춰진 사용 사례

Mistral AI는 단계별 사고가 결정적인 사용 사례를 목표로 하고 있다:

- 전략적 의사 결정

- 법률 연구

- 재무 예측

- 다단계 소프트웨어 개발

- 서사적 글쓰기 및 콘텐츠 생성

- 규제 분석 및 준수

이 다양성은 규제된 부문과 높은 인지 밀도의 기술 직종에 침투하려는 의지를 나타내며, 보다 "창의적인" 사용으로의 개방성을 희생하지 않고 있다.