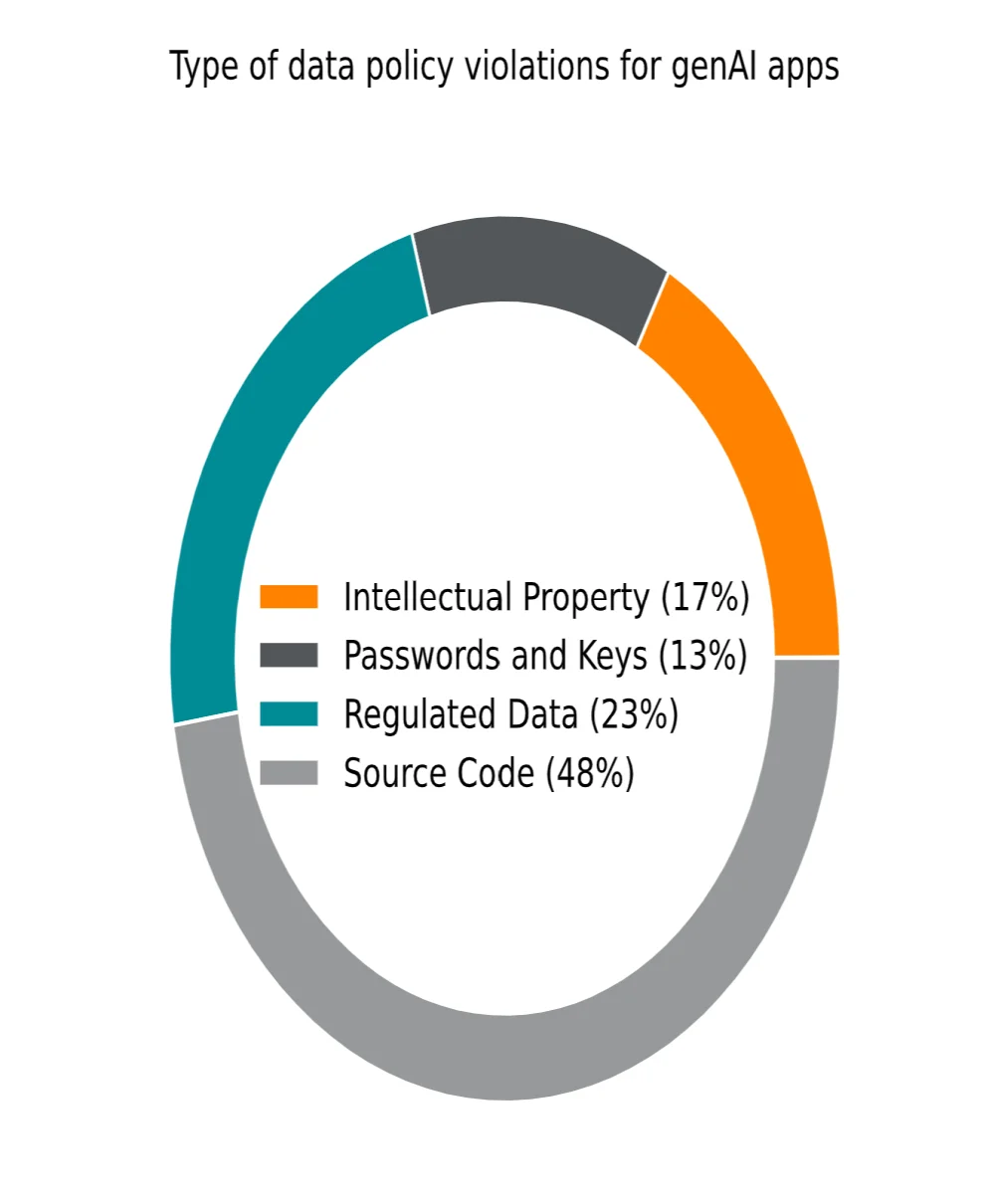

L'adozione crescente della GenAI sta ridefinendo il panorama tecnologico delle aziende, offrendo loro significativi incrementi di produttività mentre amplifica i rischi in materia di cybersicurezza e gestione dei dati. Secondo il 2025 Generative AI Cloud and Threat Report di Netskope, leader nella sicurezza e networking, il volume di dati condivisi con applicazioni di IA generativa è aumentato di 30 volte in un anno, includendo elementi sensibili come il codice sorgente, dati regolamentati, password o chiavi di crittografia. Questa trasformazione impone alle organizzazioni di riconsiderare le loro strategie di sicurezza per preservare l'integrità e la riservatezza delle loro informazioni critiche. Nel 2023, l'IA generativa era ancora una tecnologia emergente, dominata da ChatGPT e Gemini di

Google. Solo 1 utente aziendale su 100 accedeva a questi strumenti. Nel 2025, questa proporzione è aumentata considerevolmente: quasi un utente su 20 sfrutta direttamente applicazioni GenAI, mentre la maggioranza ne beneficia indirettamente grazie alla loro integrazione in diverse soluzioni professionali.

Netskope ha censito 317 applicazioni distinte di GenAI utilizzate da oltre 3.500 dei suoi clienti, confermando così la diffusione di questi strumenti nei flussi di lavoro moderni.

Ray Canzanese, Direttore dei

Netskope Threat Labs, sottolinea:

"I dati più recenti mostrano che l'IA generativa non è più una tecnologia di nicchia, ma è onnipresente. Si integra in modo crescente in tutti i campi, che si tratti di applicazioni dedicate o di integrazioni di back-end. Tale onnipresenza rappresenta una sfida crescente per la cybersicurezza." Rischi crescenti per la sicurezza dei dati

Questa adozione massiccia è accompagnata da rischi significativi. Le aziende vedono

i loro dati confidenziali potenzialmente esposti a applicazioni terze che potrebbero sfruttarli per addestrare nuovi modelli di IA. Inoltre, l'IA generativa alimenta il shadow IT: il 72% degli utenti della GenAI in azienda accede a questi strumenti da account personali non sicuri, sfuggendo così al controllo dei dipartimenti informatici.

Parallelamente, la crescita delle infrastrutture di IA in modalità locale, passate da meno dell'1% al 54% in un anno, limita alcuni rischi legati al cloud ma introduce nuove sfide, come fughe di dati interni all'interno delle catene di approvvigionamento e vulnerabilità.

James Robinson, CISO di

Netskope, commenta:

"Nonostante i seri sforzi compiuti dalle aziende per implementare strumenti di IA generativa gestiti internamente, il nostro studio mostra che lo shadow IT è stato sostituito da un'IA fantasma, con quasi tre quarti degli utenti che continuano ad accedere ad applicazioni di IA generativa dai loro account personali. Questa tendenza continua, associata ai dati che vengono condivisi, sottolinea la necessità di implementare mezzi di sicurezza dei dati avanzati, per permettere ai team incaricati della sicurezza e della gestione dei rischi di recuperare governance e visibilità, due elementi indispensabili, oltre a un controllo accettabile di come l'IA generativa è utilizzata all'interno della loro azienda." Strategie di riduzione dei rischi

Di fronte a queste minacce, quasi il 100% delle aziende si sforza di ridurre

i rischi legati all'IA. Tra le misure adottate,

Netskope riporta:

Blocco e restrizione dell'accesso: molte organizzazioni preferiscono vietare l'accesso alle applicazioni genAI fino a quando non viene effettuata una valutazione approfondita;

Prevenzione delle perdite di dati (DLP): vengono implementate soluzioni di monitoraggio e filtro per impedire la condivisione involontaria di dati sensibili con strumenti di IA;

Formazione degli utenti in tempo reale: formazioni e avvisi contestuali permettono di sensibilizzare

i dipendenti sui rischi e di guidarli verso migliori pratiche d'uso.

Le raccomandazioni di Netskope

Mentre

i cybercriminali sfruttano l'IA generativa per sviluppare minacce sempre più sofisticate, le aziende devono evolversi. Come sottolinea Ari Giguere, vicepresidente di

Netskope, una

cybersicurezza efficace deve combinare creatività umana e potenza tecnologica per tenere il passo con l'innovazione. L'adozione di quadri specifici e sistemi di sicurezza avanzati consente non solo di ridurre i rischi, ma anche di sfruttare i numerosi vantaggi offerti dall'IA generativa.

Per proteggere dati, utenti e reti,

Netskope preconizza di mettere in atto un approccio strutturato:

:

Per capire meglio

Cos'è il 'shadow IT' e come influisce sulla sicurezza delle aziende che utilizzano GenAI?

Il 'shadow IT' si riferisce all'uso di sistemi informatici, software o applicazioni senza l'approvazione ufficiale dei dipartimenti IT. Rappresenta un rischio per la sicurezza poiché bypassa i protocolli di controllo e sicurezza stabiliti, aumentando la vulnerabilità alle violazioni dei dati, soprattutto con l'uso crescente della GenAI.

Come ha impattato l'evoluzione dell'infrastruttura AI, dal cloud al locale, le strategie di cybersecurity aziendali?

Il passaggio a un'infrastruttura AI locale ha consentito alle aziende di controllare meglio i propri dati, riducendo così alcuni rischi associati al cloud, come le violazioni dei dati. Tuttavia, ha anche introdotto nuove sfide, come la necessità di proteggere le catene di approvvigionamento interne e gestire le vulnerabilità locali, spingendo le aziende ad adattare le loro strategie di cybersecurity.