Alla fine di gennaio scorso, mentre tutti avevano gli occhi puntati su DeepSeek e il suo modello R1, Mistral AI introduceva discretamente Small 3, annunciando l'arrivo imminente di modelli Mistral con capacità di ragionamento migliorate. Ora è realtà: dopo Small 3.1 presentato lo scorso marzo, l'unicorno ha appena svelato Magistral, il suo primo modello di ragionamento su larga scala, disponibile in due varianti, una open source "Magistral Small", l'altra orientata alle imprese, "Magistral Medium".

Con Magistral, Mistral AI fa un nuovo passo avanti. Non nella corsa alle dimensioni, ma nella ricerca di un'IA più spiegabile, più radicata nel ragionamento umano, e soprattutto, più adatta alle realtà operative delle imprese. Il nuovo modello si basa sui progressi di Small 3.1, supporta molte lingue, tra cui inglese, francese, spagnolo, tedesco, italiano, arabo, russo e cinese semplificato. Implementa una catena di ragionamento esplicita, passo dopo passo, che può essere seguita, interrogata e verificata nella lingua dell'utente.

Magistral Small

Mistral AI ha pubblicato Magistral Small sotto licenza Apache 2.0, permettendo così alla comunità di utilizzarlo, affinarlo e distribuirlo per vari casi d'uso. È scaricabile su https://huggingface.co/mistralai/Magistral-Small-2506 .

Questa versione è stata ottimizzata grazie a un fine-tuning supervisionato (SFT) basato sulle tracce di ragionamento generate da Magistral Medium durante le sue interazioni e poi rafforzata da un apprendimento (RLHF) per affinare la qualità e la coerenza del ragionamento.

Contando, come i modelli Small 3, 24 miliardi di parametri, Magistral Small, una volta quantificato, può essere distribuito su configurazioni hardware accessibili, come un PC funzionante con un solo GPU RTX 4090 o un Mac con una memoria RAM di 32 GB, consentendo agli sviluppatori di mantenere il controllo sui propri dati sensibili senza dipendere da un'infrastruttura cloud centralizzata.

Magistral Medium

Questa variante è la declinazione aziendale di Magistral. Più potente, è disponibile sulla piattaforma Le Chat di Mistral e tramite l'API dell'azienda. Attualmente distribuito su Amazon SageMaker, sarà presto disponibile su IBM WatsonX, Azure AI e Google Cloud Marketplace.

Secondo l'unicorno, Flash Answers nel Chat permette di ridurre drasticamente la latenza delle risposte. Secondo quanto affermato, Magistral Medium raggiunge una velocità di elaborazione fino a 10 volte superiore rispetto a molti concorrenti.

Le prestazioni di Magistral

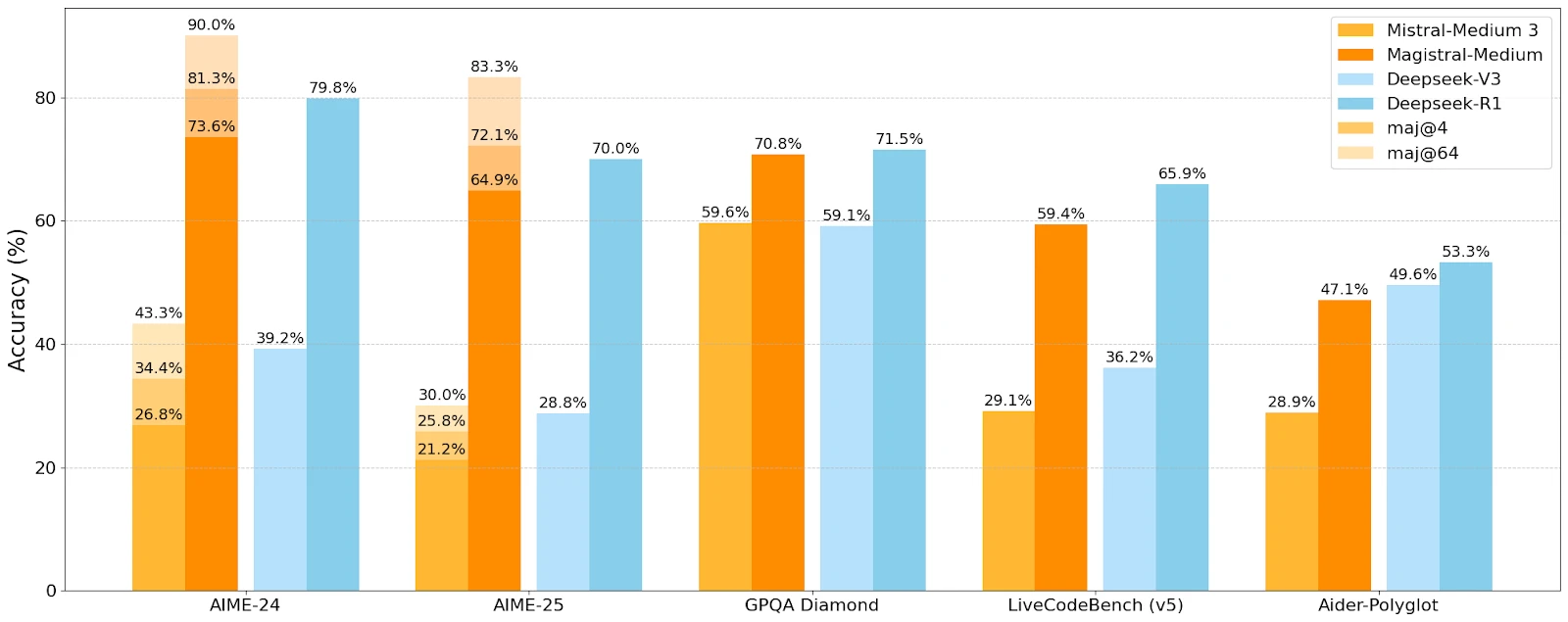

Mistral AI ha confrontato le prestazioni di Magistral con quelle di Mistral Medium e dei modelli concorrenti di DeepSeek su diversi benchmark di ragionamento e comprensione.

Magistral-Medium supera Mistral-Medium 3 su tutti i benchmark, dimostrando l'efficacia del ragionamento migliorato. Sui benchmark AIME 2024, Medium raggiunge un punteggio del 73,6% con il 90% di voto maggioritario, contro il 70,7% e l'83,3% per Small. Risultati competitivi, anche se Deepseek mantiene un vantaggio su alcuni benchmark.

Casi d'uso ben mirati

Mistral AI mira a casi d'uso in cui il ragionamento passo dopo passo è determinante:

- Presa di decisioni strategiche

- Ricerca legale

- Previsione finanziaria

- Sviluppo software multi-fase

- Redazione narrativa e generazione di contenuti

- Analisi normativa e conformità

Questa diversità suggerisce una volontà di penetrare sia i settori regolamentati che i mestieri tecnici ad alta densità cognitiva, senza sacrificare l'apertura verso usi più "creativi".