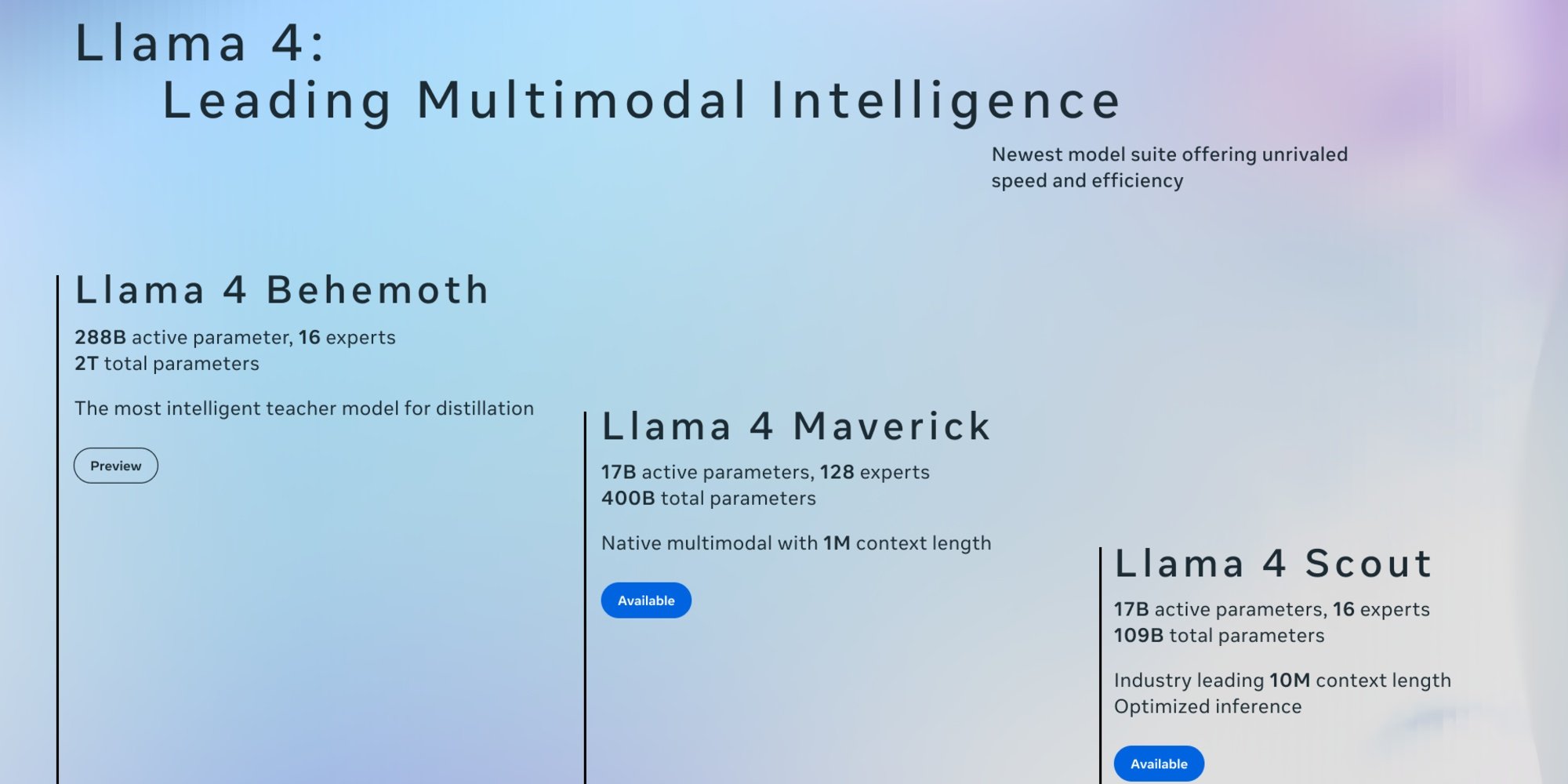

Il 5 aprile, Meta ha svelato le due prime versioni di Llama 4: Scout e Maverick. Questi modelli open, progettati per essere nativamente multimodali, possono elaborare testo, immagini e video. Grazie a un processo di distillazione basato su Llama 4 Behemoth, il modello più grande e potente della serie ancora in sviluppo, si distinguono per la loro velocità di esecuzione e efficienza.

Contrariamente alle versioni precedenti di Llama che utilizzavano un'architettura basata sui Transformers, Llama 4 si basa su un'architettura di Mixture-of-Experts (MoE), dove solo alcuni parametri sono attivati per ogni richiesta. Questo approccio migliora l'efficienza e riduce il costo del calcolo, con Scout e Maverick che attivano "solo" 17 miliardi di parametri per richiesta. Meta ha anche ampliato il supporto linguistico, che passa da 8 per Llama 3.3, presentato lo scorso dicembre, a 12. Tuttavia, va notato che la loro base di conoscenze si ferma ad agosto 2024.

Llama 4 Scout: una finestra di contesto inedita

Scout con 109 miliardi di parametri è il più leggero della serie. Il suo principale punto di forza è una finestra contestuale che può arrivare fino a 10 milioni di token, un balzo rispetto ai 128.000 token di Llama 3. Aggiunto al fatto che può funzionare su una sola scheda Nvidia H100, il modello è particolarmente adatto alle aziende con risorse limitate per compiti come la sintesi multi-documento o l'analisi approfondita delle attività utente. Secondo le valutazioni interne di Meta, Llama 4 Scout offre prestazioni migliori rispetto a Gemma 3, Mistral 3.1 e Gemini 2.0 Flash Lite.

Llama 4 Maverick

Maverick, conta invece 400 miliardi di parametri e 128 esperti, il che lo rende più performante. Con una finestra di contesto di 1 milione di token, apre la strada ad applicazioni come:

- Agenti aziendali intelligenti, capaci di ragionare e interagire in tutta sicurezza con vari strumenti e flussi di lavoro;

- Sistemi di comprensione dei documenti, facilitando l'estrazione di dati strutturati da PDF, scansioni e moduli;

- Assistenti multilingue, offrendo risposte sfumate e adattate alle specificità culturali;

- Strumenti di creazione dedicati alla redazione di storie, contenuti di marketing e testi personalizzati.

Secondo Meta, Maverick Llama 4 è il miglior modello multimodale della sua categoria, superando GPT-4o e Gemini 2.0 Flash su un ampio ventaglio di benchmark. Raggiunge anche risultati comparabili a quelli di DeepSeek v3 in ragionamento e programmazione, pur utilizzando meno della metà dei parametri attivi.

Inoltre, Llama 4 Maverick offre un rapporto prestazioni/costo eccezionale, con una versione sperimentale di chat che raggiunge un punteggio ELO di 1417 su LMArena.

Llama 4 Behemoth

Meta ha anche condiviso un'anteprima di Llama 4 Behemoth, il modello insegnante di 2 trilioni di parametri (2.000 miliardi), che ha servito come base per queste 2 prime versioni. Contando 288 miliardi di parametri attivi con 16 esperti, offre prestazioni di punta sebbene non sia un modello specializzato per il ragionamento. Eccellerebbe secondo la società in matematica, multilinguismo e sui benchmark di immagini.

Secondo le sue valutazioni, Behemoth supererebbe così GPT-4.5, Claude Sonnet 3.7 e Gemini 2.0 Pro su diversi benchmark.

Disponibilità

Scout e Maverick sono accessibili su Llama.com e Hugging Face, distribuiti in open source sotto la licenza di Meta che richiede tuttavia che le aziende con più di 700 milioni di utenti attivi mensili chiedano l'autorizzazione per utilizzarli. Se Llama 4 alimenta già Meta AI, l'assistente IA delle sue piattaforme WhatsApp, Messenger, Instagram in una quarantina di paesi, le funzionalità multimodali sono attualmente disponibili solo negli Stati Uniti. Per quanto riguarda l'UE, bisognerà attendere...