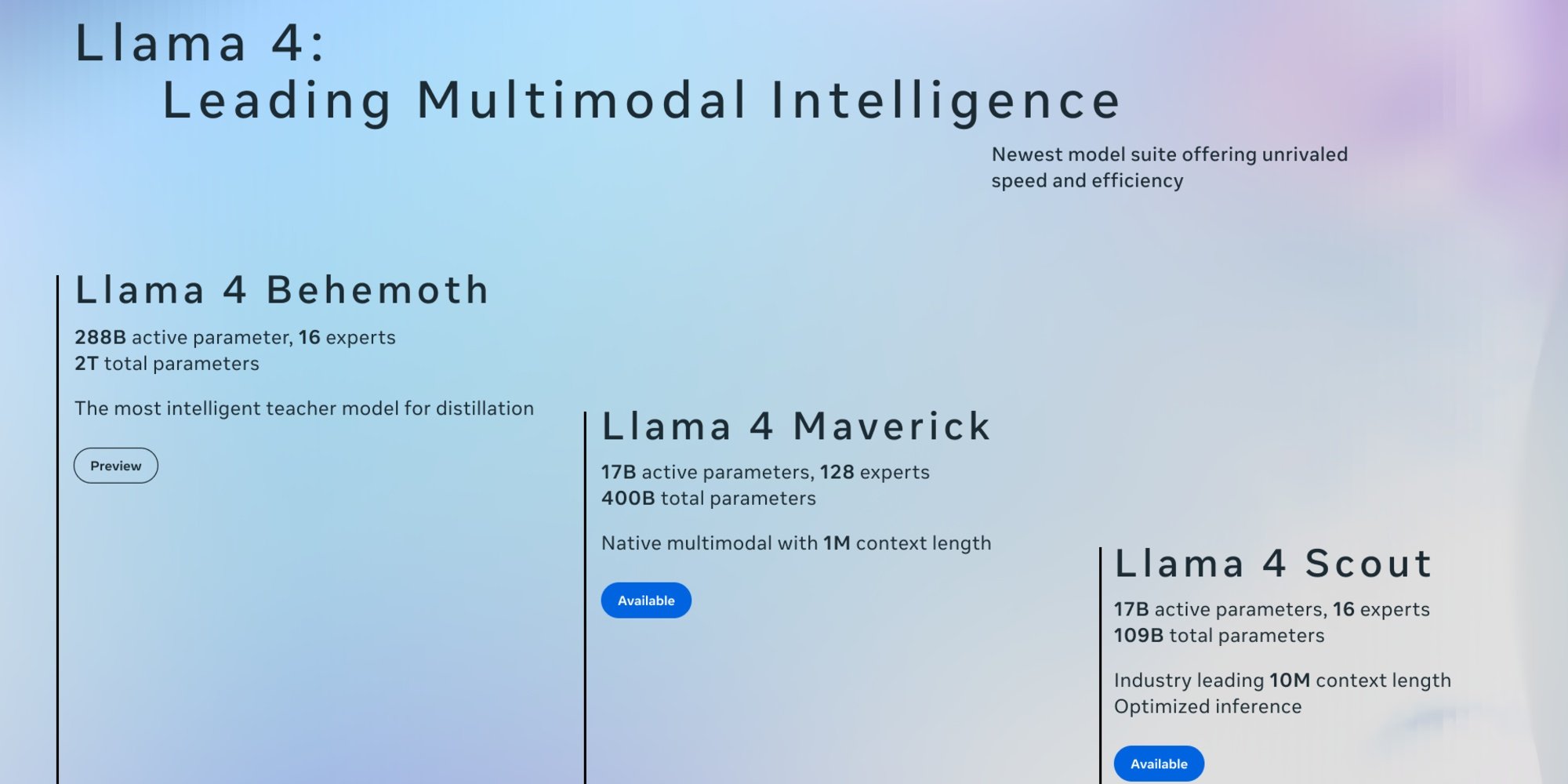

Este 5 de abril, Meta reveló las dos primeras versiones de Llama 4: Scout y Maverick. Estos modelos abiertos, diseñados para ser nativamente multimodales, pueden procesar texto, imágenes y videos. Gracias a un proceso de destilación basado en Llama 4 Behemoth, el modelo más grande y poderoso de la serie aún en desarrollo, se destacan por su rapidez de ejecución y su eficacia.

A diferencia de las versiones anteriores de Llama que utilizaban una arquitectura basada en transformadores, Llama 4 se basa en una arquitectura de Mixture-of-Experts (MoE), donde solo ciertos parámetros se activan para cada solicitud. Este enfoque mejora la eficiencia y reduce el costo del cálculo, ya que Scout y Maverick activan "solo" 17 mil millones de parámetros por solicitud. Meta también ha ampliado el soporte de idiomas, que pasa de 8 para Llama 3.3, presentado en diciembre pasado, a 12. Sin embargo, cabe destacar que su base de conocimientos se detiene en agosto de 2024.

Llama 4 Scout: una ventana de contexto inédita

Scout con 109 mil millones de parámetros es el más ligero de la serie. Su principal ventaja es una ventana contextual que puede alcanzar hasta 10 millones de tokens, un salto frente a los 128,000 tokens de Llama 3. Añadido al hecho de que puede funcionar en una sola tarjeta Nvidia H100, el modelo es particularmente adecuado para empresas con recursos limitados para tareas como síntesis de documentos múltiples o análisis profundo de actividades de usuario. Según las evaluaciones internas de Meta, Llama 4 Scout ofrece mejores desempeños que Gemma 3, Mistral 3.1 y Gemini 2.0 Flash Lite.

Llama 4 Maverick

Maverick, por su parte, cuenta con 400 mil millones de parámetros y 128 expertos, lo que lo hace más potente. Con una ventana de contexto de 1 millón de tokens, abre el camino a aplicaciones como:

- Agentes empresariales inteligentes, capaces de razonar e interactuar de manera segura con diversas herramientas y flujos de trabajo;

- Sistemas de comprensión de documentos, facilitando la extracción de datos estructurados a partir de PDF, escaneos y formularios;

- Asistentes multilingües, ofreciendo respuestas matizadas y adaptadas a las especificidades culturales;

- Herramientas de creación dedicadas a la redacción de historias, contenidos de marketing y textos personalizados.

Según Meta, Maverick Llama 4 es el mejor modelo multimodal de su categoría, superando a GPT-4o y Gemini 2.0 Flash en una amplia gama de benchmarks. También alcanza resultados comparables a los de DeepSeek v3 en razonamiento y programación, utilizando menos de la mitad de los parámetros activos.

Además, Llama 4 Maverick ofrece una relación rendimiento/costo excepcional, con una versión experimental de chat alcanzando una puntuación ELO de 1417 en LMArena.

Llama 4 Behemoth

Meta también compartió una vista previa de Llama 4 Behemoth, el modelo maestro de 2 billones de parámetros (2,000 mil millones), que sirvió como base para estas dos primeras versiones. Con 288 mil millones de parámetros activos y 16 expertos, ofrece desempeños de punta aunque no es un modelo especializado en razonamiento. Según la compañía, sobresaldría en matemáticas, multilingüismo y en benchmarks de imágenes.

Según sus evaluaciones, Behemoth superaría así a GPT-4.5, Claude Sonnet 3.7 y Gemini 2.0 Pro en diferentes benchmarks.

Disponibilidad

Scout y Maverick están disponibles en Llama.com y Hugging Face, distribuidos en open source bajo la licencia de Meta que exige, sin embargo, que las empresas con más de 700 millones de usuarios activos mensuales soliciten permiso para usarlos. Si bien Llama 4 ya alimenta Meta AI, el asistente de IA de sus plataformas WhatsApp, Messenger, Instagram en una cuarentena de países, las funcionalidades multimodales están actualmente disponibles solo en los Estados Unidos. En cuanto a la UE, habrá que esperar...