Ende Januar, als alle Augen auf DeepSeek und sein Modell R1 gerichtet waren, stellte Mistral AI leise Small 3 vor und kündigte die baldige Einführung von Mistral-Modellen mit verbesserten Denkkapazitäten an. Nun ist es soweit: Nach der Vorstellung von Small 3.1 im vergangenen März hat das Einhorn nun Magistral enthüllt, sein erstes groß angelegtes Modell für logisches Denken, das in zwei Varianten erhältlich ist: das Open-Source-Modell "Magistral Small" und das unternehmensorientierte Modell "Magistral Medium".

Mit Magistral macht Mistral AI einen weiteren Schritt nach vorne. Nicht im Rennen um Größe, sondern in der Suche nach einer KI, die erklärbarer, stärker im menschlichen Denken verankert und vor allem besser an die operativen Realitäten von Unternehmen angepasst ist. Das neue Modell basiert auf den Fortschritten von Small 3.1, unterstützt zahlreiche Sprachen, darunter Englisch, Französisch, Spanisch, Deutsch, Italienisch, Arabisch, Russisch und vereinfachtes Chinesisch. Es implementiert eine explizite Kette des Denkens, Schritt für Schritt, die in der Sprache des Nutzers verfolgt, hinterfragt und geprüft werden kann.

Magistral Small

Mistral AI hat Magistral Small unter der Apache 2.0-Lizenz veröffentlicht, sodass die Community es nutzen, verfeinern und für verschiedene Anwendungsfälle einsetzen kann. Es kann heruntergeladen werden auf https://huggingface.co/mistralai/Magistral-Small-2506 .

Diese Version wurde durch ein überwacht feingetuntes (SFT) Verfahren optimiert, das auf den von Magistral Medium generierten Denktrainingsdaten basiert und durch verstärkendes Lernen (RLHF) die Qualität und Kohärenz des Denkens weiter verbessert hat.

Mit 24 Milliarden Parametern wie die Modelle Small 3 kann Magistral Small nach der Quantifizierung auf zugänglichen Hardware-Konfigurationen eingesetzt werden, wie einem PC mit einer einzigen RTX 4090 GPU oder einem Mac mit 32 GB RAM, was es Entwicklern ermöglicht, die Kontrolle über ihre sensiblen Daten zu behalten, ohne auf eine zentralisierte Cloud-Infrastruktur angewiesen zu sein.

Magistral Medium

Diese Variante ist die Unternehmensausführung von Magistral. Leistungsstärker ist es auf der Plattform Le Chat von Mistral und über die API des Unternehmens verfügbar. Derzeit auf Amazon SageMaker eingesetzt, wird es bald auf IBM WatsonX, Azure AI und Google Cloud Marketplace verfügbar sein.

Laut dem Einhorn ermöglicht Flash Answers im Chat eine drastische Reduzierung der Antwortlatenz. Es wird berichtet, dass Magistral Medium eine Verarbeitungsgeschwindigkeit erreicht, die bis zu 10 Mal höher ist als die vieler Konkurrenten.

Die Leistung von Magistral

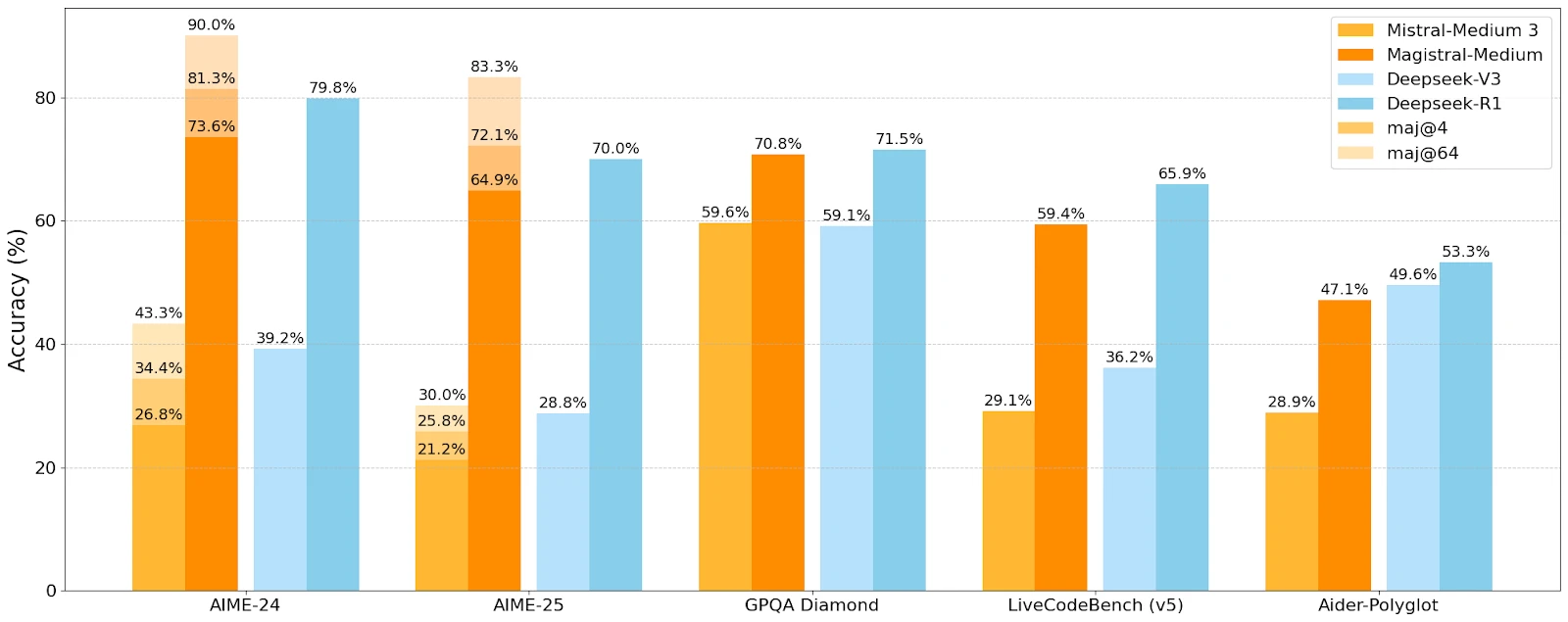

Mistral AI hat die Leistung von Magistral mit der von Mistral Medium und konkurrierenden Modellen von DeepSeek auf verschiedenen Benchmarks für logisches Denken und Verständnis verglichen.

Magistral-Medium übertrifft Mistral-Medium 3 in allen Benchmarks und beweist die Effektivität des verbesserten Denkens. In den AIME 2024-Benchmarks erreicht Medium eine Punktzahl von 73,6 % mit 90 % Mehrheitsstimme, verglichen mit 70,7 % und 83,3 % für Small. Kompetitive Ergebnisse, auch wenn DeepSeek in einigen Benchmarks weiterhin einen Vorsprung hat.

Gezielte Anwendungsfälle

Mistral AI zielt auf Anwendungsfälle ab, bei denen das schrittweise Denken entscheidend ist:

- Strategische Entscheidungsfindung

- Juristische Recherche

- Finanzielle Prognosen

- Mehrstufige Softwareentwicklung

- Narrative Erstellung und Inhaltserzeugung

- Regulatorische Analyse und Compliance

Diese Vielfalt deutet auf den Wunsch hin, sowohl in den regulierten Sektoren als auch in kognitiv anspruchsvollen technischen Berufen Fuß zu fassen, ohne die Offenheit für kreativere Anwendungen zu opfern.