TLDR : Die internationale Mission "ICHIBAN" unter der Leitung der Deutschen Raumfahrtagentur (DLR) und der Japanischen Raumfahrtagentur (JAXA) hat erfolgreich zwei Assistenzroboter zur Kommunikation und Zusammenarbeit an Bord der ISS gebracht. Diese Errungenschaft, die neue Perspektiven für robotische Interaktionen in der Umlaufbahn eröffnet, ist ein bedeutender Fortschritt im Hinblick auf zukünftige Mond- und Marsmissionen.

Die Deutsche Raumfahrtagentur (DLR) und die Japanische Raumfahrtagentur (JAXA) geben bekannt, dass die internationale Kooperationsmission "ICHIBAN" erfolgreich war. Erstmals haben zwei Assistenzroboter aus unterschiedlichen nationalen Programmen an Bord der ISS in der Umlaufbahn kommuniziert und kooperiert.

Eines der Ziele der Mission ICHIBAN (bedeutet "erste" auf Japanisch), die am 29. Juli endete, war es, die Koordination mehrerer gleichzeitig und in Echtzeit operierender Roboter an Bord der ISS zu testen.

Die beiden in das Experiment einbezogenen Roboter sind CIMON, entwickelt von DLR, Airbus und IBM, sowie Int-Ball2, entworfen von JAXA, die sich jeweils in den europäischen Columbus- und japanischen Kibo-Experimentiermodulen befinden.

Erstmals 2018 eingesetzt, ist CIMON (Crew Interactive Mobile Companion) ein kugelförmiger Roboter in der Größe eines Balls, der mit Hilfe von 3D-Druck hergestellt wurde und durch die Sprach- und Kognitionstechnologien von watsonx, der KI-Plattform von IBM, angetrieben wird. Während der ICHIBAN-Mission wurde CIMON vom BIOTESC, dem Schweizer ESA-Zentrum für wissenschaftliche Operationen an Bord der internationalen Station, betrieben.

Int-Ball2 hingegen ist eine Weiterentwicklung des ersten Kameradrohnen-Prototyps der JAXA. Seit 2023 im japanischen Modul integriert, ermöglicht er dem Bodenkontrollzentrum in Tsukuba (Japan), die Aktivitäten der Astronauten aus der Ferne zu filmen und damit die wissenschaftliche Dokumentation zu optimieren, ohne die Besatzung der internationalen Raumstation zu beanspruchen. Bisher war keine Interaktion mit anderen Robotern vorgesehen.

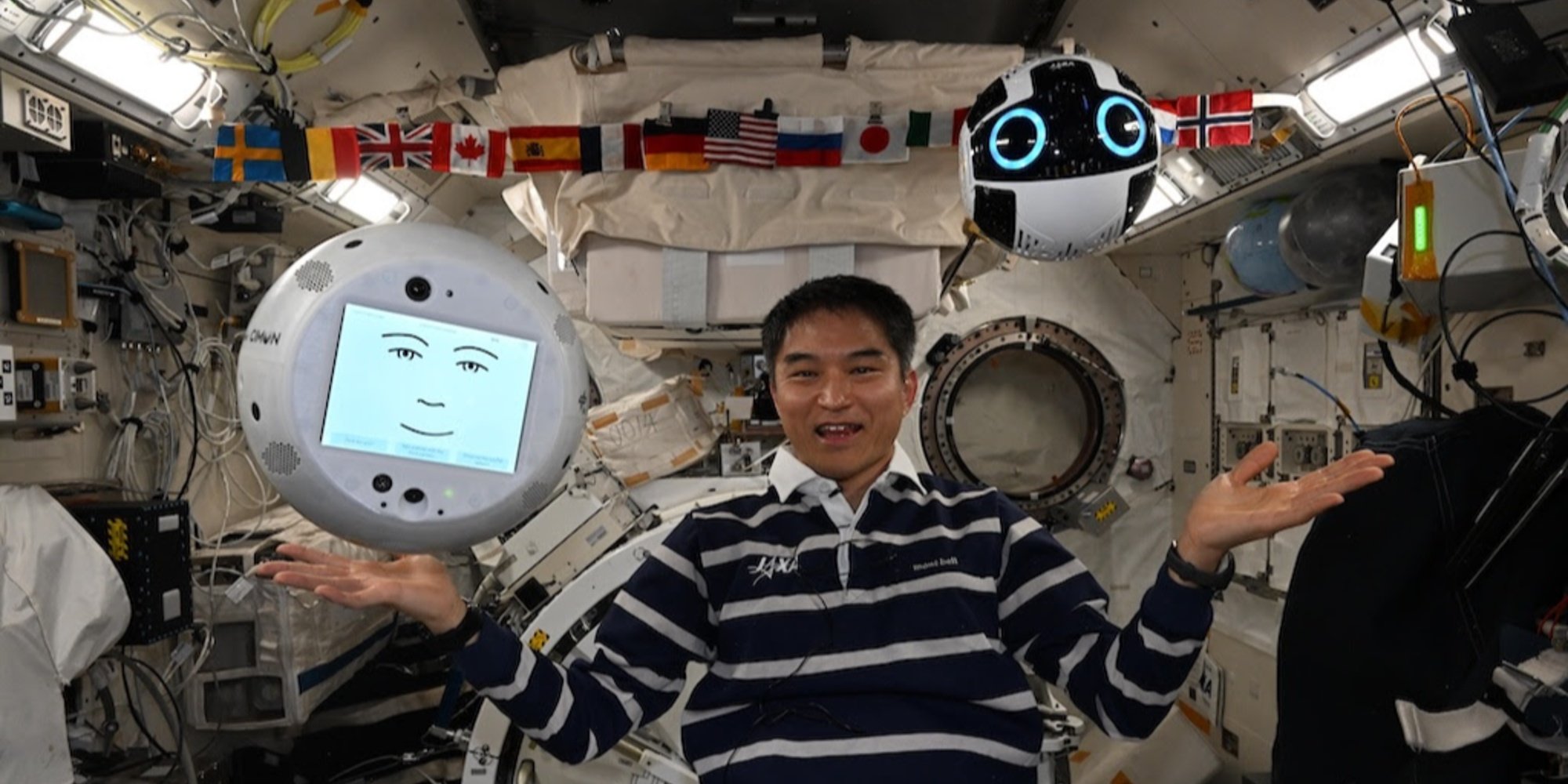

Die Demonstration wurde von Takuya Onishi, einem JAXA-Astronauten an Bord der ISS, durchgeführt. Aus dem Columbus-Modul heraus übermittelte er Sprachbefehle an CIMON, der als intelligente Sprachschnittstelle diente. Die Anweisung wurde von der IBM watsonx-Plattform verarbeitet und dann in operationale Befehle für Int-Ball2 übersetzt.

Dieser navigierte dann im Kibo-Modul, um verschiedene versteckte Objekte zu suchen und zu lokalisieren: ein Rubik's Cube, ein Hammer, mehrere Schraubendreher und eine außer Betrieb gesetzte frühere Version von Int-Ball. Er übermittelte die Live-Bilder an den Bildschirm von CIMON, wodurch Onishi ihre Position aus der Ferne visuell überprüfen konnte.

Credit: JAXA/DLR;

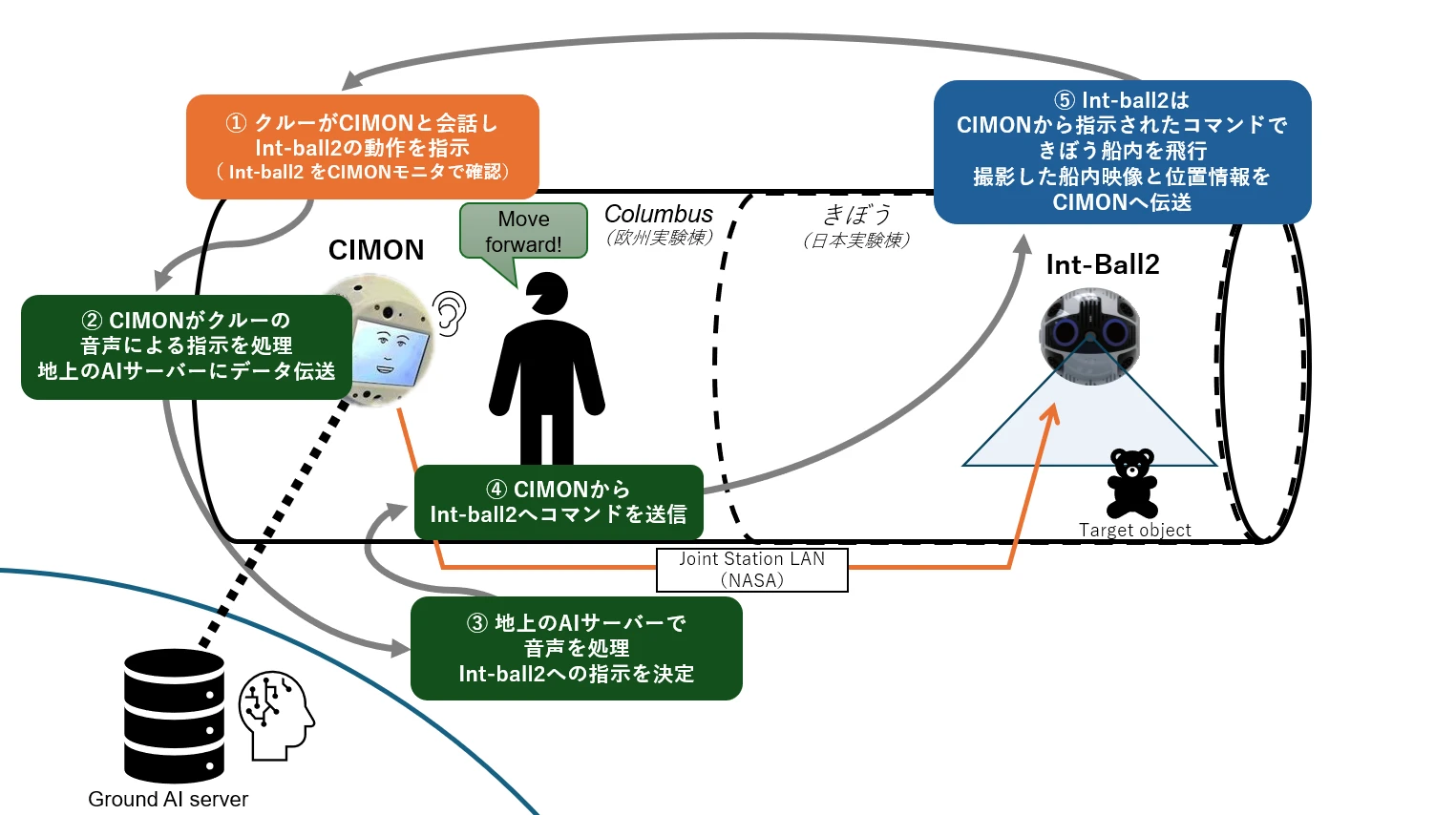

Illustration des ICHIBAN-Missions-Kooperationsplans

Illustration des ICHIBAN-Missions-Kooperationsplans

Der Astronaut gibt CIMON einen Sprachbefehl, damit Int-Ball2 eine Aufgabe ausführt (Schritt ①). CIMON überträgt diesen Sprachbefehl an einen KI-Server am Boden, der die Absicht des Befehls analysiert (Schritte ② und ③). Rücksendung der Anweisung zur ISS: Nach der Verarbeitung wird der Befehl vom Boden über das LAN der Station (Joint Station LAN/NASA) an CIMON gesendet, der ihn an Int-Ball2 übermittelt (Schritt ④). Dieser handelt entsprechend im japanischen Modul "Kibo", führt seine Aufgabe aus (z.B. ein Objekt lokalisieren) und sendet die Bilder und Positionsdaten an CIMON zurück.

Die Innovation liegt darin, dass die bislang von Int-Ball2 erfassten Bilder nur an das Kontrollzentrum in Tsukuba übermittelt werden konnten. Die Möglichkeit, sie in Echtzeit an einen anderen Roboter an Bord zu senden, eröffnet ein neues Feld für verteilte robotische Interaktionen in der Umlaufbahn.

Ein erster Schritt, der angesichts zukünftiger Mond- und Marsmissionen an Bedeutung gewinnt.