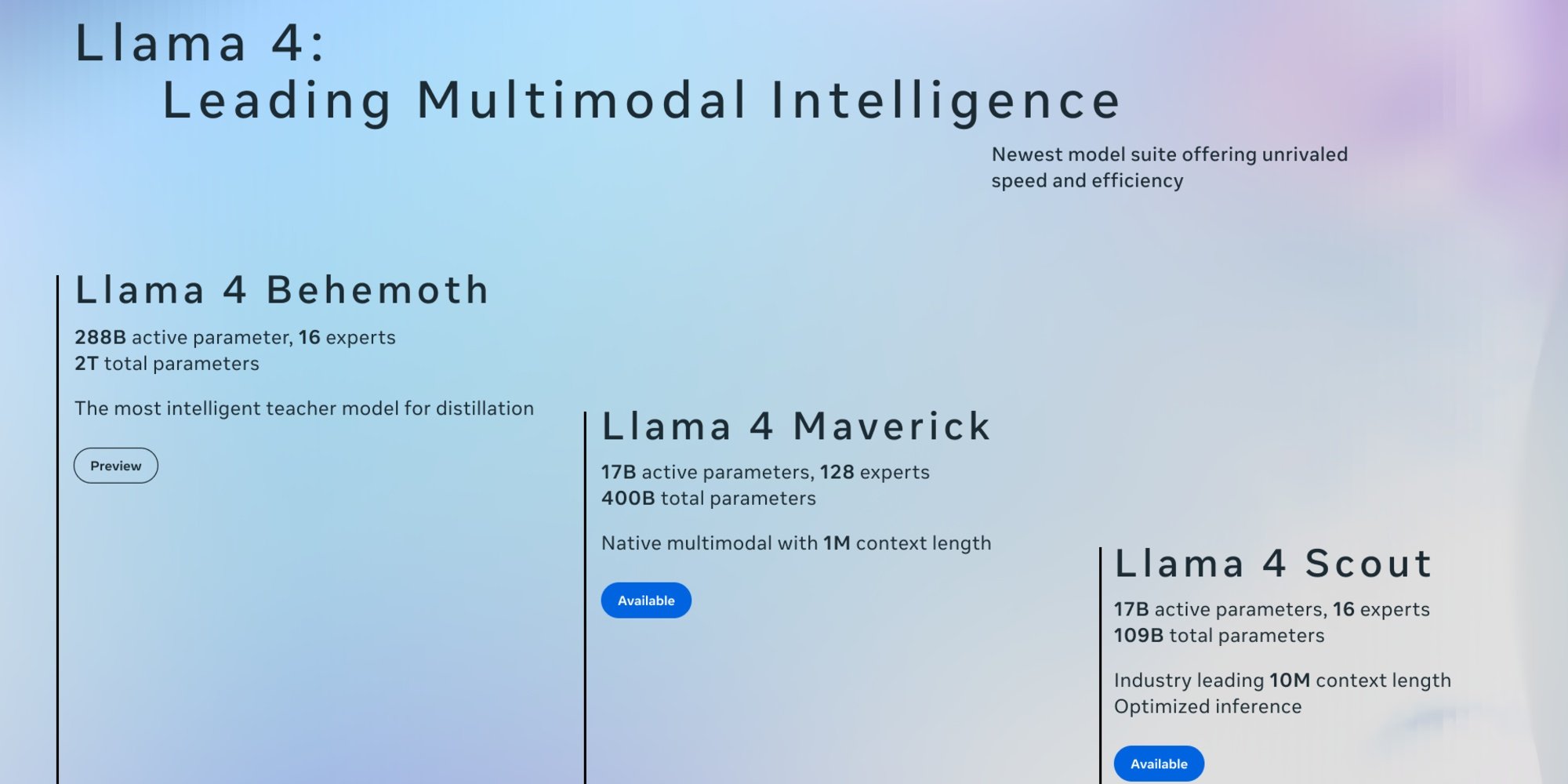

Am 5. April hat Meta die beiden ersten Versionen von Llama 4 enthüllt: Scout und Maverick. Diese offenen Modelle, die nativ multimodal konzipiert sind, können Text, Bilder und Videos verarbeiten. Dank eines Destillationsprozesses basierend auf Llama 4 Behemoth, dem größten und leistungsstärksten Modell der Serie, das sich noch in der Entwicklung befindet, zeichnen sie sich durch ihre Ausführungsgeschwindigkeit und Effizienz aus.

Im Gegensatz zu den vorherigen Versionen von Llama, die auf einer Transformer-Architektur basierten, beruht Llama 4 auf einer Mixture-of-Experts (MoE)-Architektur, bei der nur bestimmte Parameter für jede Anfrage aktiviert werden. Dieser Ansatz verbessert die Effizienz und senkt die Berechnungskosten, da Scout und Maverick „nur“ 17 Milliarden Parameter pro Anfrage aktivieren. Meta hat auch die Sprachunterstützung erweitert, die von 8 bei Llama 3.3 im vergangenen Dezember auf 12 gestiegen ist. Es ist jedoch zu beachten, dass ihre Wissensbasis im August 2024 endet.

Llama 4 Scout: ein neuartiges Kontextfenster

Scout mit 109 Milliarden Parametern ist das leichteste der Serie. Sein Hauptvorteil ist ein Kontextfenster, das bis zu 10 Millionen Tokens erreichen kann, ein Sprung gegenüber den 128.000 Tokens von Llama 3. Hinzu kommt, dass er auf einer einzigen Nvidia H100-Karte laufen kann, was das Modell besonders für Unternehmen mit begrenzten Ressourcen geeignet macht, um Aufgaben wie die Multi-Dokumenten-Synthese oder die tiefgehende Analyse von Benutzeraktivitäten durchzuführen. Laut den internen Bewertungen von Meta bietet Llama 4 Scout bessere Leistungen als Gemma 3, Mistral 3.1 und Gemini 2.0 Flash Lite.

Llama 4 Maverick

Maverick verfügt über 400 Milliarden Parameter und 128 Experten, was ihn leistungsfähiger macht. Mit einem Kontextfenster von 1 Million Tokens eröffnet er Anwendungen wie:

- Intelligente Unternehmensagenten, die sicher mit verschiedenen Tools und Arbeitsabläufen argumentieren und interagieren können;

- Dokumentenverständnissysteme, die die Extraktion strukturierter Daten aus PDFs, Scans und Formularen erleichtern;

- Mehrsprachige Assistenten, die nuancierte und kulturell angepasste Antworten bieten;

- Kreationstools, die sich dem Verfassen von Geschichten, Marketinginhalten und personalisierten Texten widmen.

Laut Meta ist Maverick Llama 4 das beste multimodale Modell seiner Kategorie und übertrifft GPT-4o und Gemini 2.0 Flash in einer breiten Palette von Benchmarks. Es erreicht auch vergleichbare Ergebnisse wie DeepSeek v3 im Bereich des logischen Denkens und der Programmierung, während es weniger als die Hälfte der aktiven Parameter verwendet.

Darüber hinaus bietet Llama 4 Maverick ein außergewöhnliches Leistungs-/Kostenverhältnis, mit einer experimentellen Chat-Version, die eine ELO-Wertung von 1417 auf LMArena erreicht.

Llama 4 Behemoth

Meta hat auch einen Einblick in Llama 4 Behemoth gegeben, das Lehrermodell mit 2 Billionen Parametern (2.000 Milliarden), das als Grundlage für diese ersten beiden Versionen diente. Mit 288 Milliarden aktiven Parametern und 16 Experten bietet es Spitzenleistungen, obwohl es kein spezialisiertes Modell für logisches Denken ist. Laut dem Unternehmen würde es sich in Mathematik, Mehrsprachigkeit und in Bild-Benchmarks auszeichnen.

Laut seinen Bewertungen übertrifft Behemoth somit GPT-4.5, Claude Sonnet 3.7 und Gemini 2.0 Pro in verschiedenen Benchmarks.

Verfügbarkeit

Scout und Maverick sind auf Llama.com und Hugging Face zugänglich, die als Open Source unter der Meta-Lizenz verteilt werden, die jedoch erfordert, dass Unternehmen mit mehr als 700 Millionen aktiven monatlichen Nutzern die Erlaubnis zur Nutzung einholen. Während Llama 4 bereits Meta AI, den KI-Assistenten seiner Plattformen WhatsApp, Messenger, Instagram in etwa vierzig Ländern antreibt, sind die multimodalen Funktionen derzeit nur in den USA verfügbar. In der EU muss man sich noch gedulden...