TLDR : Das chinesische Start-up DeepSeek hat sein Modell R1 aktualisiert und dabei dessen Leistungen in den Bereichen logisches Denken, Logik, Mathematik und Programmierung verbessert. Dieses Update reduziert Fehler und verbessert die Anwendungsintegration, sodass R1 mit Flaggschiff-Modellen wie o3 von Open AI und Gemini 2.5 Pro von Google konkurrieren kann.

Inhaltsverzeichnis

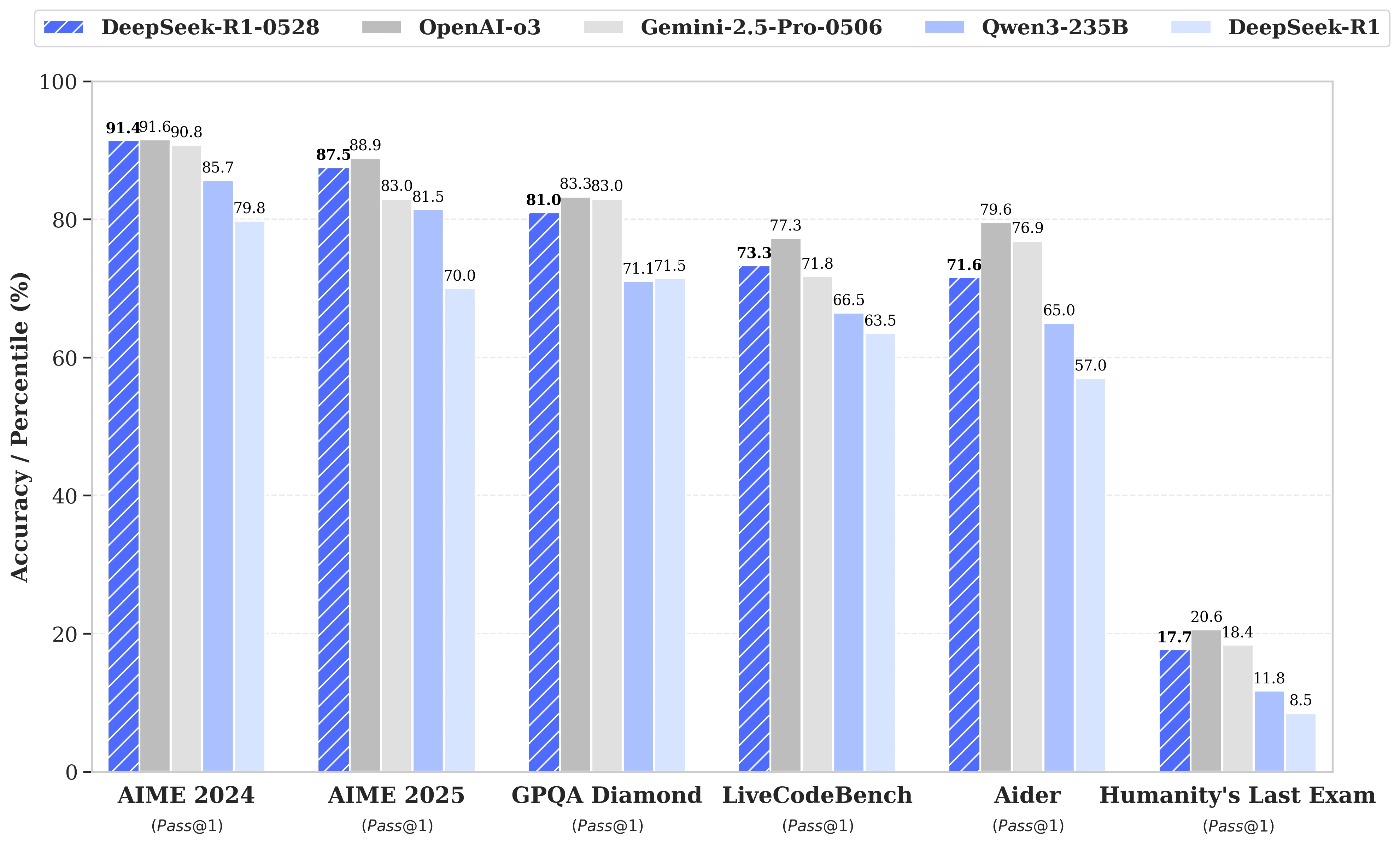

Während die Spekulationen um den bevorstehenden Start von DeepSeek R2 zunahmen, hat das gleichnamige chinesische Start-up am 28. Mai schließlich ein Update des R1-Modells angekündigt. Dieses unter dem Namen DeepSeek-R1-0528 veröffentlichte Update stärkt die Fähigkeiten von R1 in Schlüsseldomänen wie logisches Denken, Logik, Mathematik und Programmierung. Die Leistung dieses unter MIT-Lizenz veröffentlichten Open-Source-Modells nähert sich nun den Flaggschiff-Modellen o3 von Open AI und Gemini 2.5 Pro von Google an.

Signifikante Verbesserungen bei der Bewältigung komplexer Denkaufgaben

Das Update basiert auf einer effizienteren Nutzung der verfügbaren Rechenressourcen, kombiniert mit einer Reihe von algorithmischen Optimierungen, die nach dem Training implementiert wurden. Diese Anpassungen führen zu einer gesteigerten Reflexionstiefe beim logischen Denken: Während die vorherige Version im Durchschnitt 12.000 Tokens pro Frage in den AIME-Tests verbrauchte, nutzt DeepSeek-R1-0528 nun fast 23.000, was zu einer bemerkenswerten Erhöhung der Genauigkeit von 70 % auf 87,5 % in der 2025er Ausgabe des Tests führt.

- In der Mathematik erreichen die erzielten Werte 91,4 % (AIME 2024) und 79,4 % (HMMT 2025), was die Leistungen einiger geschlossener Modelle wie o3 oder Gemini 2.5 Pro fast erreicht oder übertrifft;

- In der Programmierung steigt der LiveCodeBench-Index um fast 10 Punkte (von 63,5 auf 73,3 %), und die SWE Verified Bewertung steigt von 49,2 % auf 57,6 % Erfolg;

- Beim allgemeinen logischen Denken steigt der Score im GPQA-Diamant-Test von 71,5 % auf 81,0 %, während er beim Benchmark „Letzter Test der Menschheit“ mehr als verdoppelt wird, von 8,5 % auf 17,7 %.

Verringerung von Fehlern und bessere Anwendungsintegration

Zu den bemerkenswerten Entwicklungen, die dieses Update mit sich bringt, gehört eine spürbare Reduzierung der Halluzinationsrate, ein kritisches Thema für die Zuverlässigkeit von LLMs. Durch die Verringerung der Häufigkeit faktisch ungenauer Antworten gewinnt DeepSeek-R1-0528 an Robustheit, insbesondere in Kontexten, in denen Präzision unerlässlich ist.

Das Update führt auch auf den Einsatz in strukturierten Umgebungen ausgerichtete Funktionen ein, insbesondere die direkte Erzeugung von Ausgaben im JSON-Format und die erweiterte Unterstützung für Funktionsaufrufe. Diese technischen Fortschritte vereinfachen die Integration des Modells in automatisierte Workflows, Softwareagenten oder Back-End-Systeme, ohne dass umfangreiche Zwischenverarbeitungen erforderlich sind.

Wachsende Aufmerksamkeit für die Destillation

Parallel dazu hat das Team von DeepSeek begonnen, Denkketten in leichtere Modelle für Entwickler oder Forscher mit begrenzter Hardware zu destillieren. DeepSeek-R1-0528, das über 685 B (Milliarden) Parameter verfügt, wurde so für das Nachtraining von Qwen3 8B Base verwendet.

Das resultierende Modell, DeepSeek-R1-0528-Qwen3-8B, erreicht es, weit größere Open-Source-Modelle bei bestimmten Benchmarks zu übertrumpfen. Mit einem Score von 86,0 % bei AIME 2024 übertrifft es nicht nur das Ergebnis von Qwen3 8B um mehr als 10,0 %, sondern erreicht auch die Leistungen von Qwen3-235B-thinking.

Ein Ansatz, der Fragen zur zukünftigen Lebensfähigkeit massiver Modelle aufwirft, angesichts sparsamerer, aber besser trainierter Modelle.

DeepSeek erklärt:

„Wir glauben, dass die Denkkette von DeepSeek-R1-0528 sowohl für die akademische Forschung über Denkmodelle als auch für die industrielle Entwicklung, die sich auf kleinere Modelle konzentriert, von erheblicher Bedeutung sein wird.“