Das kanadische Einhorn Cohere hat kürzlich „Command A“ enthüllt, die neueste Version seines Flaggschiffmodells. Speziell entwickelt, wie seine Vorgänger, um den Bedürfnissen von Unternehmen gerecht zu werden, kombiniert dieses LLM mit 111 Milliarden Parametern Leistung und Energieeffizienz und konkurriert mit führenden Modellen wie GPT-4o und DeepSeek-V3.

Einer der Hauptvorteile von Command A für Unternehmen ist sein minimaler Hardware-Fußabdruck. Während die meisten vergleichbaren Modelle bis zu 32 GPUs benötigen, arbeitet Command A effizient mit nur zwei A100- oder H100-GPUs, was zu einer signifikanten Reduzierung der Kosten und der Latenz sowie einer höheren Ausführungsgeschwindigkeit führt. Neben einer schnelleren Generierung des ersten Tokens kann es bis zu 156 Tokens/s generieren, was 1,75-mal schneller ist als GPT-4o und 2,4-mal schneller als DeepSeek-V3.

Leistungen von Command A

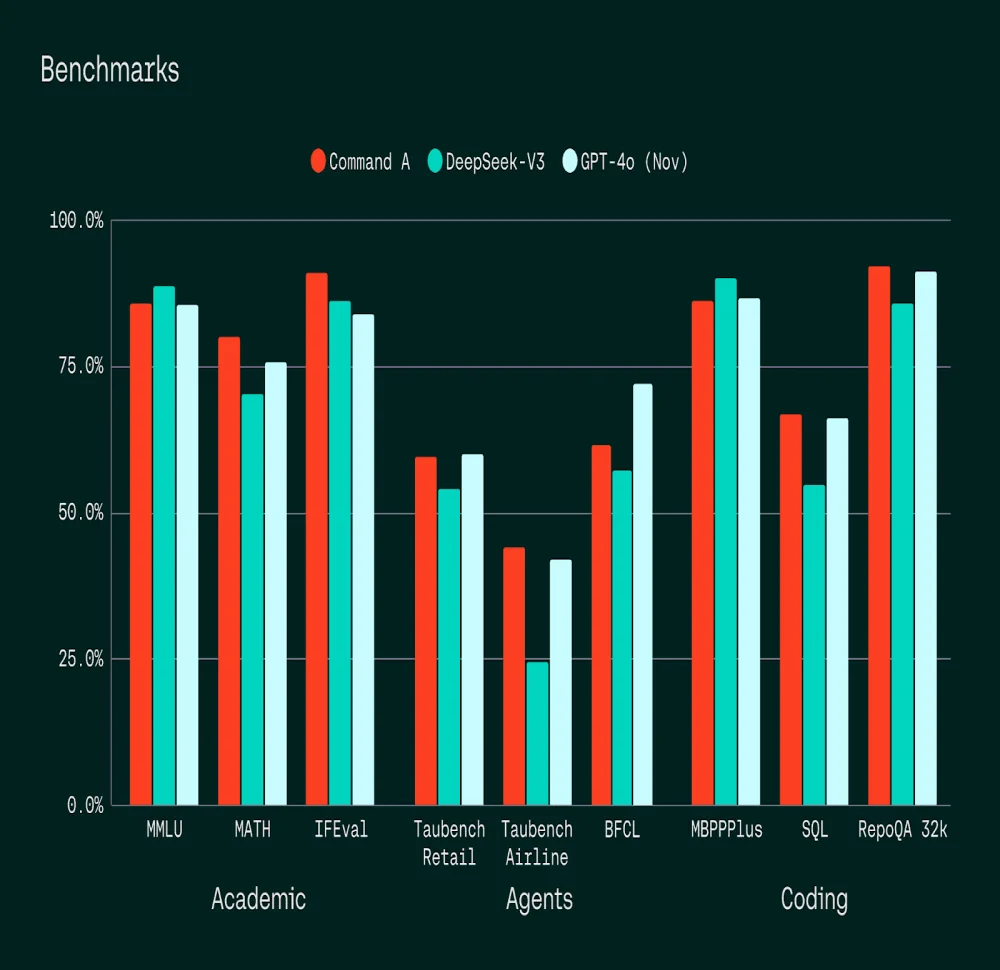

Cohere hat die Leistung von Command A im Vergleich zu GPT-4o und DeepSeek-V3 anhand akademischer Benchmarks bewertet: MMLU (Allgemeinwissen), MATH, IFEval (Instruktionsverfolgung), Tests intelligenter Agenten (BFCL, Taubench) und Codierungsbenchmarks (MBPPPlus, SQL, RepoQA).

Seine Fähigkeiten in der Instruktionsverfolgung, im Codieren, insbesondere in SQL, und in agentischen Aufgaben übertreffen die seiner Konkurrenten.

In menschlichen Bewertungstests hat Command A, das 23 der wichtigsten Sprachen abdeckt, seine Konkurrenten in mehreren Sprachen übertroffen, insbesondere im Dialektarabisch, wo es sich als kohärenter und präziser als GPT-4o und DeepSeek-V3 erwiesen hat. Diese Fähigkeit, sich an lokale Kontexte anzupassen, stellt einen strategischen Vorteil für international tätige Unternehmen dar.

Optimierte Fähigkeiten für Unternehmen

Im Gegensatz zu seinem Vorgänger, der eine Kontextlänge von 128.000 Tokens unterstützte, verfügt Command A über eine Kontextlänge von 256 Tokens, was es ihm ermöglicht, lange Unternehmensdokumente zu analysieren. Es integriert fortschrittliche Funktionen wie die durch Retrieval erweiterte Generierung (RAG) mit überprüfbaren Zitaten und die Verwendung sicherer agentischer Werkzeuge.

Es ist besonders effektiv für:

Die Analyse und Extraktion von Informationen aus umfangreichen Finanzberichten;

Das Management von HR-Politiken entsprechend den lokalen Spezifika;

Die Überprüfung und Interpretation komplexer juristischer Vorschriften.

Dank einer nahtlosen Integration mit North, der KI-Agentenplattform von

Cohere, ermöglicht Command A Unternehmen die Entwicklung maßgeschneiderter KI-Lösungen, während ein hohes Maß an Sicherheit und Compliance gewahrt bleibt.

Verfügbarkeit und Preisgestaltung

Bereits verfügbar auf der Cohere-Plattform, mit baldiger Unterstützung durch die wichtigsten Cloud-Anbieter, wird Command A zu einem Preis von 2,50 $ für eine Million Eingabe-Tokens und 10,00 $ für eine Million Ausgabe-Tokens angeboten. Es ist auch zu Forschungszwecken auf

Hugging Face zugänglich.

Besser verstehen

Was ist ein LLM und warum ist es wichtig für Unternehmen?

Ein LLM (Large Language Model) ist ein KI-Modell, das riesige Mengen an Daten nutzt, um natürliche Sprache zu verstehen, zu erzeugen und zu manipulieren. Für Unternehmen kann dies die Abläufe transformieren, indem es den Kundenservice optimiert, komplexe Daten analysiert und die Kommunikation sowie Entscheidungsfindung verbessert.

Wie verbessert die Retrieval-Augmented Generation (RAG) die Fähigkeiten eines LLM wie Command A?

RAG, oder Retrieval-Augmented Generation, ermöglicht einem LLM, seine Antworten mit aktuellen und relevanten externen Daten anzureichern. Dies geschieht durch die Konsultation externer Datenbanken oder Dokumente, wobei die bereitgestellten Informationen überprüft und die Genauigkeit und Relevanz der generierten Ergebnisse erhöht werden.