Inhaltsverzeichnis

Im Juli 2025 eingeführt, markiert der ChatGPT Agent OpenAIs Bestreben, einen Schritt in Richtung autonomer Assistenten zu machen, die im Internet navigieren, Skripte ausführen und komplexe Aufgaben von Anfang bis Ende erledigen können. Als „Workforce auf Abruf“ präsentiert, weckt das Tool sowohl Begeisterung als auch Frustration, wenn man den Berichten der ersten Nutzer Glauben schenken darf.

Echte Fähigkeiten, aber unterschiedliche Leistungen

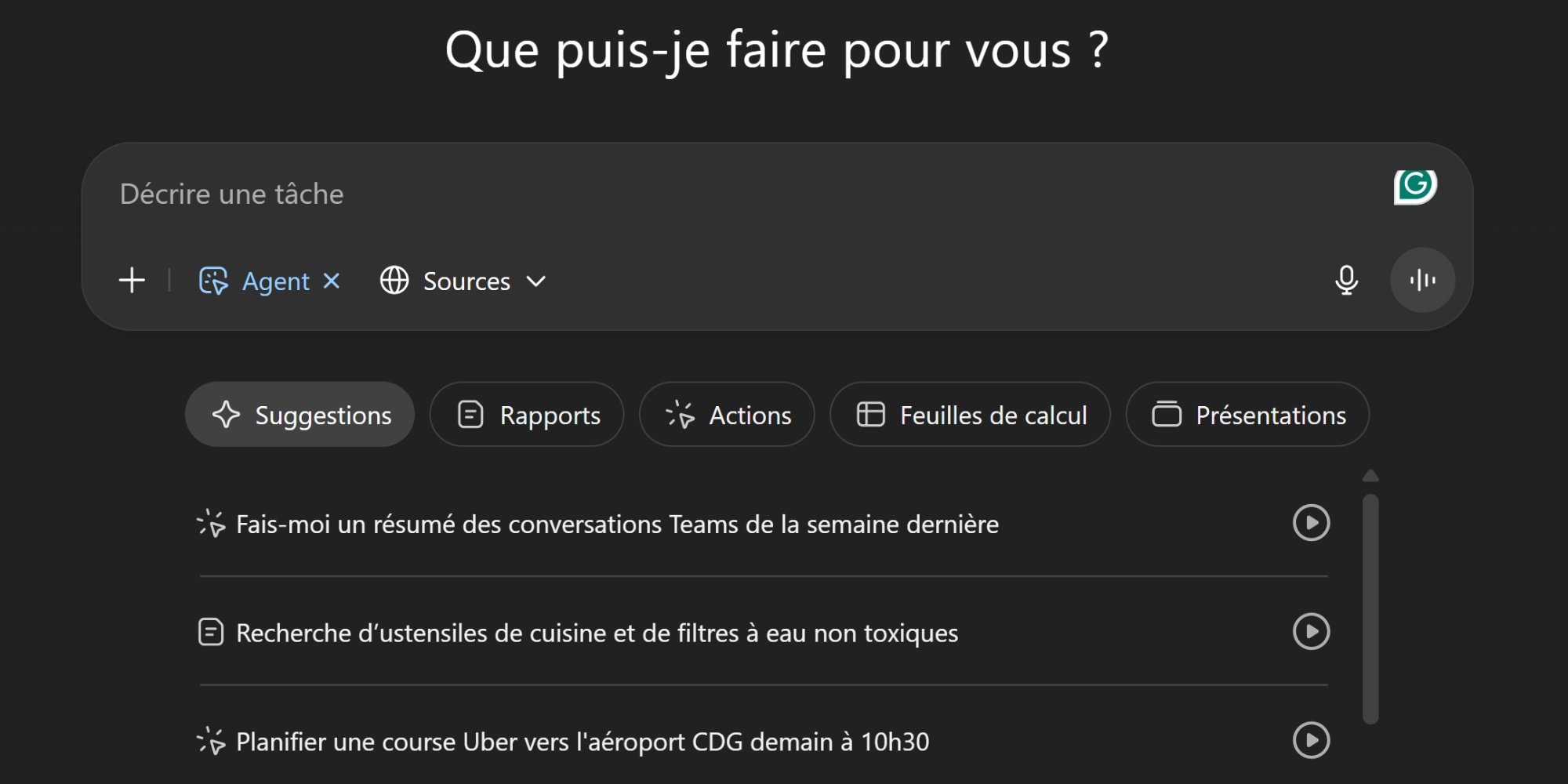

Auf dem Papier beeindruckt der ChatGPT Agent durch seine Fähigkeit, die Schritte einer Mission nahtlos zu durchlaufen: Sammlung von Informationen online, Organisation und Synthese, Erstellung von Dokumenten (Berichte, Präsentationen, Tabellenkalkulationen). Das Tool kombiniert die Funktionen Operator und DeepResearch, die bereits seit mehreren Monaten auf der Plattform verfügbar sind. Für strukturierte und wenig zweideutige Aufgaben berichten mehrere Tester von einer erheblichen Zeitersparnis, indem der Agent die für bestimmte Recherchen und Vorbereitung von Deliverables benötigte Zeit um die Hälfte oder mehr reduziert.

Doch die Grenzen werden schnell sichtbar, sobald die Aufgaben komplexer werden. Zahlreiche Rückmeldungen auf Reddit und LinkedIn heben eine spürbare Langsamkeit, sich wiederholende Aktionsschleifen und eine hohe Fehlerquote bei bestimmten Web-Interaktionen hervor.

Die Sandbox: Sicherheit oder Fessel?

Der Betrieb des ChatGPT Agent basiert auf einer Sandbox: einer von OpenAI gehosteten virtuellen Umgebung, die einen Browser und einen virtuellen Desktop integriert. Dieser Ansatz zielt darauf ab, Sicherheitsrisiken zu minimieren und die Aktionen des Agenten zu kontrollieren, hemmt jedoch stark seine Fähigkeiten.

Viele Websites blockieren den Zugang oder erkennen den Agenten als Bot, wodurch Reservierungen, Käufe oder komplexe Interaktionen verhindert werden.

Der Agent scheitert regelmäßig an dynamischen Formularen, hochinteraktiven Websites, die durch CAPTCHA oder Dienste wie Cloudflare geschützt sind....was ihn für die meisten auf dem Papier verheißungsvollsten Versprechen unbrauchbar macht.

Dieser schützende Ansatz macht den Agenten für Recherchen und Synthesen nutzbar, aber wenig zuverlässig für fortgeschrittene oder kritische Webaktionen.

Ein Versuch, Manus einzuholen

Im Vergleich zum ChatGPT Agent bietet Manus, entwickelt von Future AGI, einen kühneren Ansatz. Mit einer Multi-Agenten-Architektur (Planung, Ausführung, Validierung) und einer umfassenderen Sandbox-Umgebung (erweiterter Browser, Terminal, multimodale Generierung) wird Manus von einigen als leistungsfähiger bei komplexen Aufgaben und autonomen Workflows wahrgenommen.

Allerdings bleibt Manus schwer zugänglich (eingeschränkter Zugang, hohe Kosten in Credits, begrenzte Verfügbarkeit), was seine Verbreitung einschränkt. Nutzerberichte sprechen von häufigen Bugs und einem hohen Verbrauch an Credits im Falle eines Fehlschlags, was zu Frustration führt. Seine Autonomie impliziert weniger Echtzeitkontrolle, was zu Abweichungen führen kann, wenn der Agent in eine unerwartete Richtung geht.

Auf dem Weg zu browserintegrierten Agenten?

Ein anderer Weg könnte einige der Einschränkungen überwinden: den Agenten im Browser des Nutzers auszulagern, über eine Erweiterung oder ein lokales Modul.

Ein solches Modell würde bieten:

- Eine schnellere Ausführung, da die Virtualisierung entfällt.

- Eine direkte Integration mit lokalen Tools und Daten (CRM, Nachrichten, Dokumente).

- Eine bessere Kompatibilität mit modernen Websites, da er sich wie ein echter menschlicher Browser verhalten würde.

Doch diese Wahl würde zwei große Herausforderungen darstellen:

- Sicherheit: Ein Agent mit Zugang zu Cookies, Konten und lokalen Daten würde zu einem bevorzugten Ziel für Missbrauch.

- Marketing-Positionierung: Ein lokaler Agent würde eher einem persönlichen Automatisierungstool als einer „ausgelagerten Workforce“ ähneln, was das kommerzielle Versprechen von OpenAI verändern würde.

Ein Produkt noch in der Erprobungsphase

Derzeit bleibt der ChatGPT Agent ein innovatives, aber unreifes Tool: nützlich, um bestimmte klar umrissene Aufgaben zu beschleunigen, eingeschränkt für ehrgeizigere Missionen. Die Vision einer „KI-Arbeitskraft“ bleibt mehr ein Marketingversprechen als eine technische Realität.

Die Entwicklung des Marktes für KI-Agenten könnte über einen hybriden Kompromiss verlaufen: Agenten, die in einer sicheren Umgebung arbeiten können, während sie bestimmte Interaktionen an den lokalen Browser delegieren, mit erhöhter Kontrolle und Schutzmechanismen.

In der Zwischenzeit sollten die Nutzer den ChatGPT Agent als intelligenten Assistenten in der Testphase betrachten und nicht als wirklichen Ersatz für menschliche Mitarbeiter.

Welche Zukunft hat das Web angesichts der Agenten?

Das Internet hat es schon immer ermöglicht, dass Software und Computersysteme miteinander kommunizieren. Die meisten Websites implementieren mindestens eine oder mehrere APIs, Schnittstellen für die Kommunikation zwischen Software. Heute zielen die Agenten darauf ab, den sichtbaren Teil des Webs, der von Menschen genutzt wird, in natürlichsprachliche Software-Schnittstellen zu verwandeln.

Die Frage ist weniger eine der technischen Fähigkeiten als vielmehr die des Einvernehmens oder nicht der Herausgeber, ihre Inhalte für Software zugänglich zu machen. Die theoretischen Versprechen der Agenten basieren auf einer Welt, in der die Agenten auf alles zugreifen können. Eine der ersten offensichtlichen Folgen wäre die Beschleunigung des bereits begonnenen Zusammenbruchs des Werbemodells.

Dies könnte auch Fragen zu Veränderungen aufwerfen, insbesondere im Rahmen von Marktplätzen: Wie kann man sich vorstellen, dass die Schnäppchen auf Websites für Privatpersonen, wie Le bon coin oder Vinted, nicht systematisch von einigen Akteuren vereinnahmt werden?

Was wird aus dem Wettbewerb und der Vielfalt des Angebots, wenn wir alle denselben Preisvergleich verwenden? Die Herausgeber sind zwischen einem Umgehen ihrer Nutzungsrichtlinien und einer schrittweisen Unsichtbarkeit gefangen.