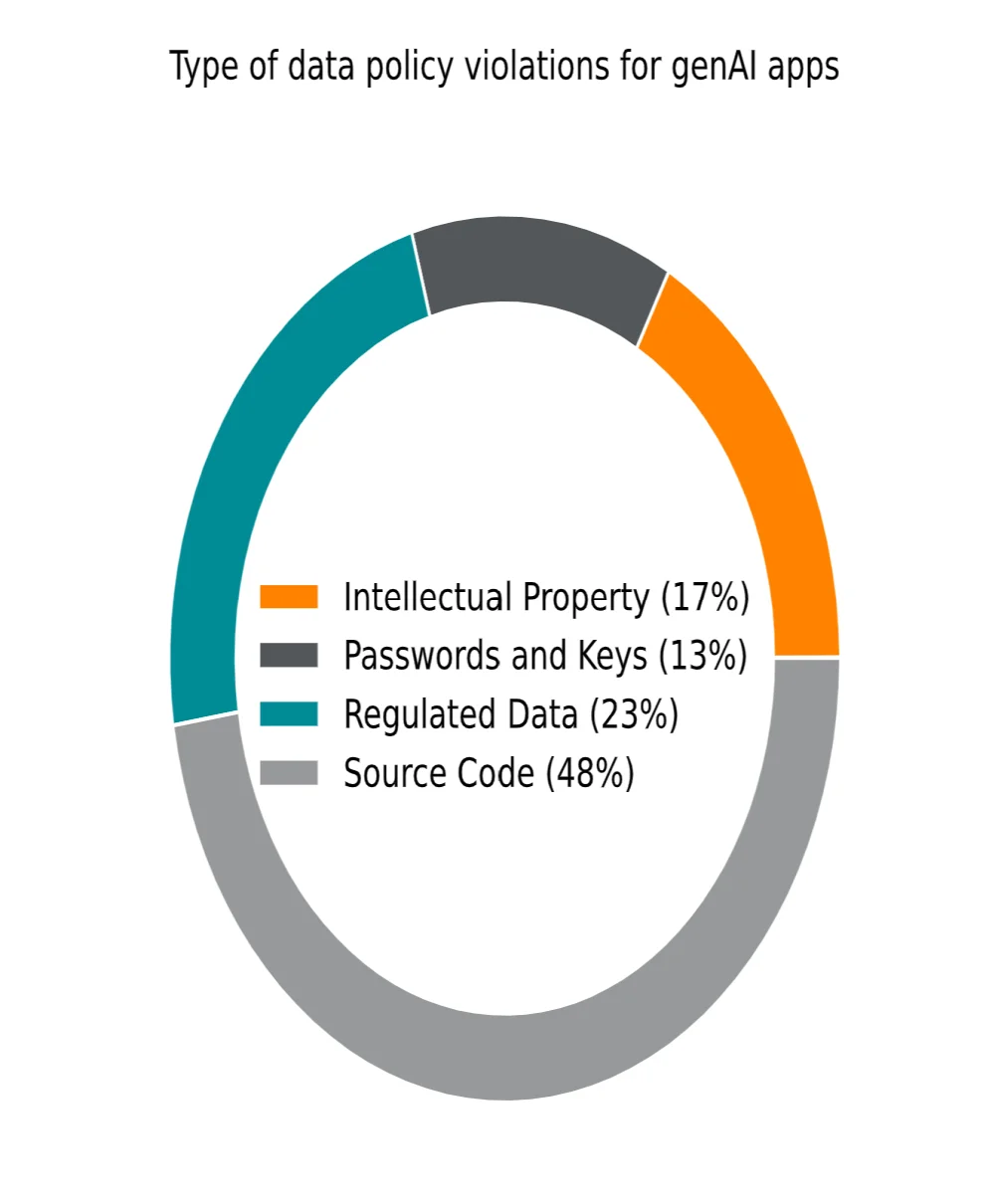

A adoção crescente da GenAI está redefinindo o panorama tecnológico das empresas, oferecendo ganhos significativos de produtividade enquanto amplifica os riscos em cibersegurança e gestão de dados. De acordo com o relatório 2025 Generative AI Cloud and Threat Report da Netskope, líder em segurança e redes, o volume de dados compartilhados com aplicações de IA generativa multiplicou-se por 30 em um ano, incluindo elementos sensíveis como código-fonte, dados regulamentados, senhas ou chaves de criptografia. Essa transformação impõe às organizações uma reavaliação de suas estratégias de segurança para preservar a integridade e a confidencialidade de suas informações críticas. Em 2023, a IA generativa ainda era uma tecnologia emergente, dominada por ChatGPT e Gemini do

Google. Apenas 1 usuário corporativo em cada 100 acessava essas ferramentas. Em 2025, essa proporção aumentou consideravelmente: quase um usuário em 20 utiliza diretamente as aplicações GenAI, enquanto a maioria se beneficia indiretamente através de sua integração em diversas soluções profissionais. A

Netskope identificou 317 aplicações distintas de GenAI utilizadas por mais de 3.500 de seus clientes, confirmando assim a generalização dessas ferramentas nos fluxos de trabalho modernos.

Ray Canzanese, Diretor do

Netskope Threat Labs, destaca:

"Os dados mais recentes mostram que a IA generativa não é mais uma tecnologia de nicho, mas que está onipresente. Ela se integra de forma crescente a todos os domínios, seja em aplicações dedicadas ou integrações de back-end. Essa ubiquidade representa um desafio crescente para a cibersegurança." Riscos aumentados para a segurança dos dados

Esta adoção massiva vem acompanhada de riscos significativos. As empresas veem seus dados confidenciais potencialmente expostos a aplicações de terceiros que poderiam usá-los para treinar novos modelos de IA. Além disso, a IA generativa alimenta o shadow IT: 72% dos usuários de GenAI em empresas acessam essas ferramentas a partir de contas pessoais não seguras, escapando assim do controle dos departamentos de TI.

Paralelamente, o aumento das infraestruturas de IA em modo local, que passaram de menos de 1% para 54% em um ano, limita alguns riscos relacionados à nuvem, mas introduz novos desafios, especialmente vazamentos de dados internos nas cadeias de suprimentos e vulnerabilidades

James Robinson, CISO da

Netskope, comenta:

"Apesar dos sérios esforços realizados pelas empresas para implementar ferramentas de IA generativa geridas internamente, nosso estudo mostra que o shadow IT foi substituído por uma IA fantasma, com quase três quartos dos usuários continuando a acessar aplicações de IA generativa a partir de suas contas pessoais. Essa tendência contínua, associada aos dados que são compartilhados, destaca a necessidade de implementar meios avançados de segurança de dados, para permitir que as equipes responsáveis pela segurança e gestão de riscos recuperem governança e visibilidade, dois elementos indispensáveis, assim como um controle aceitável de como a IA generativa é empregada dentro de sua empresa."

Estratégias de redução de riscos

Diante dessas ameaças, quase 100% das empresas se esforçam para reduzir os riscos relacionados à IA. Entre as medidas adotadas, a

Netskope relata:

Bloqueio e restrição de acesso: muitas organizações preferem proibir o acesso às aplicações genAI até que uma avaliação aprofundada seja realizada;

Prevenção de perda de dados (DLP): soluções de monitoramento e filtragem são implementadas para impedir o compartilhamento involuntário de dados sensíveis com ferramentas de IA;

Treinamento de usuários em tempo real: formações e alertas contextuais permitem sensibilizar os funcionários sobre os riscos e guiá-los para melhores práticas de uso.

As recomendações da Netskope

Enquanto os cibercriminosos exploram a IA generativa para desenvolver ameaças cada vez mais sofisticadas, as empresas também devem evoluir. Como destaca Ari Giguere, vice-presidente da

Netskope, uma

cibersegurança eficaz deve aliar criatividade humana e poder tecnológico para acompanhar o ritmo da inovação. A adoção de quadros específicos e sistemas de segurança avançados permite não apenas reduzir os riscos, mas também aproveitar as muitas vantagens que a IA generativa oferece.

Para proteger os dados, os usuários e as redes, a

Netskope recomenda a implementação de uma abordagem estruturada:

Avaliar o panorama de IA generativa: Identificar as aplicações e infraestruturas GenAI utilizadas, assim como seus usuários e seus usos;

Reforçar o controle das aplicações genAI: Autorizar apenas as aplicações validadas, bloquear as não aprovadas e usar tecnologias de prevenção de perda de dados (DLP) para evitar qualquer vazamento de informações sensíveis;

Otimizar os controles locais : Aplicar os quadros de referência, como o Top 10 das aplicações

LLM da OWASP, o quadro de gestão de riscos de IA do

NIST e o referencial

Atlas MITRE para garantir uma proteção eficaz das infraestruturas internas.

:

Para entender melhor

O que é 'shadow IT' e como impacta a segurança das empresas que utilizam GenAI?

Shadow IT refere-se ao uso de sistemas de TI, software ou aplicativos sem aprovação oficial dos departamentos de TI. Apresenta um risco de segurança ao contornar protocolos de controle e segurança estabelecidos, aumentando a vulnerabilidade a violações de dados, especialmente com o uso crescente de GenAI.

Como a evolução da infraestrutura de IA, do cloud para local, impactou as estratégias de cibersegurança corporativa?

A mudança para infraestrutura de IA on-premises permitiu que as empresas controlassem melhor seus dados, reduzindo assim alguns riscos associados ao cloud, como violações de dados. No entanto, também introduziu novos desafios, como a necessidade de proteger cadeias de suprimentos internas e gerenciar vulnerabilidades locais, o que leva as empresas a adaptarem suas estratégias de cibersegurança.