Em resumo : A missão internacional "ICHIBAN" conduzida pela agência espacial alemã (DLR) e pela agência japonesa de exploração aeroespacial (JAXA) conseguiu fazer comunicar e cooperar dois robôs de assistência aos astronautas a bordo da ISS. Esta conquista, que abre perspectivas para as interações robóticas em ambiente orbital, é um avanço importante para as futuras missões lunares e marcianas.

A agência espacial alemã (DLR) e a Agência Japonesa de Exploração Aeroespacial (JAXA) anunciam que a missão de cooperação internacional "ICHIBAN" foi bem-sucedida. Pela primeira vez, dois robôs de assistência aos astronautas de programas nacionais distintos comunicaram-se e cooperaram em órbita a bordo da ISS.

Um dos objetivos da missão ICHIBAN (primeira em japonês), que foi concluída em 29 de julho passado, era testar a coordenação de vários robôs distintos operando simultaneamente e em tempo real a bordo da ISS.

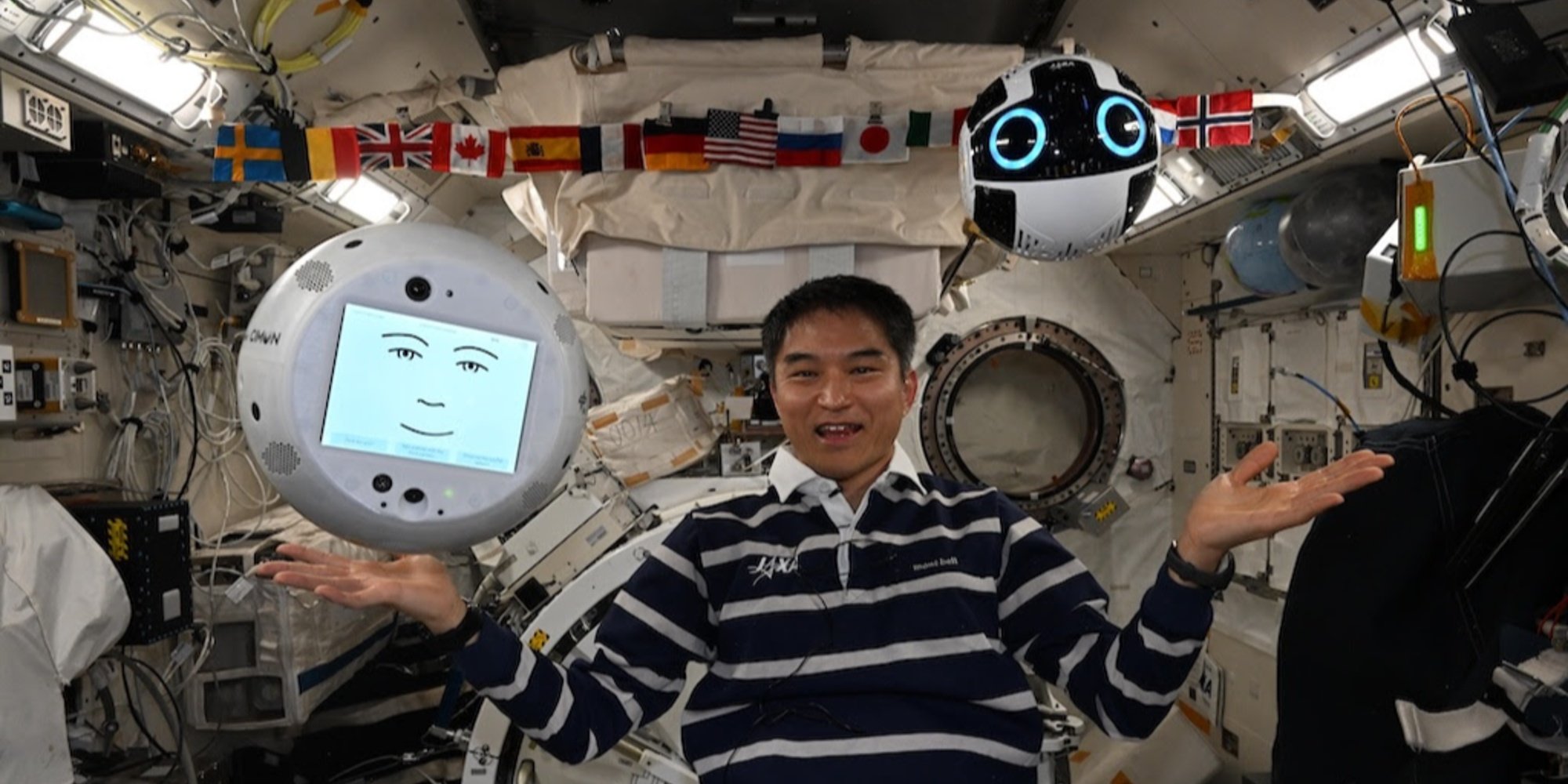

Os dois robôs envolvidos na experiência são CIMON, desenvolvido pelo DLR, Airbus e IBM, assim como Int-Ball2, concebido pela JAXA, instalados respectivamente nos módulos de experimentação europeu Columbus e japonês Kibo.

Implantado pela primeira vez em 2018, CIMON (Crew Interactive Mobile Companion) é um robô esférico, do tamanho de uma bola, impresso em 3D, impulsionado pelas tecnologias vocais e cognitivas do watsonx, a plataforma IA da IBM. Durante a missão ICHIBAN, CIMON foi operado pelo BIOTESC, o centro suíço da ESA especializado em operações científicas a bordo da estação internacional.

Por sua vez, Int-Ball2 é uma evolução do primeiro drone câmera da JAXA. Integrado desde 2023 no módulo japonês, ele permite ao centro de controle em Tsukuba (Japão) filmar à distância as atividades dos astronautas, otimizando assim a documentação científica sem mobilizar a tripulação da estação espacial internacional. Até então, nenhuma capacidade de interação com outros robôs havia sido considerada.

A demonstração foi conduzida por Takuya Onishi, astronauta da JAXA a bordo da ISS. Do módulo Columbus, ele transmitiu comandos vocais ao CIMON, que serviu como interface linguística inteligente. A instrução foi processada pela plataforma watsonx da IBM, antes de ser traduzida em comandos operacionais direcionados ao Int-Ball2.

Este último então navegou no módulo Kibo para procurar e localizar diversos objetos escondidos: um Cubo Mágico, um martelo, várias chaves de fenda, e uma versão antiga do Int-Ball desativada. Ele então transmitiu as imagens ao vivo para a tela do CIMON, permitindo que Onishi verificasse visualmente sua posição à distância.

Crédito: JAXA/DLR;

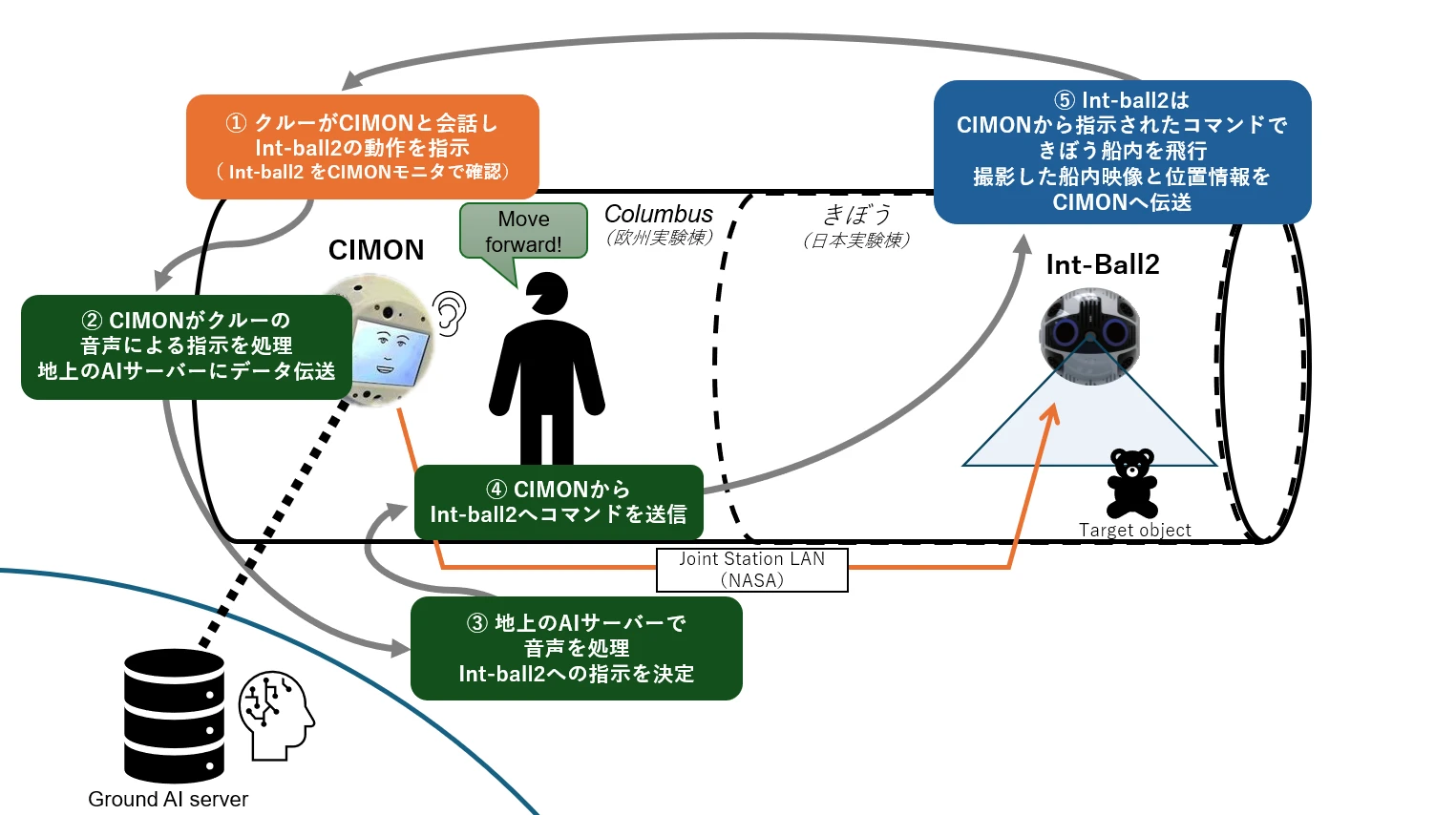

Ilustração Quadro de colaboração da missão ICHIBAN

Ilustração Quadro de colaboração da missão ICHIBAN

O astronauta dá uma instrução vocal ao CIMON para que o Int-Ball2 execute uma tarefa (etapa ①). CIMON transmite este comando vocal a um servidor de IA localizado no solo, que analisa a intenção do comando (etapas ② e ③). Retorno de instrução para a ISS: uma vez processado, o comando é enviado de volta do solo via LAN da estação (Joint Station LAN/NASA) para o CIMON, que o transmite ao Int-Ball2 (etapa ④). Este então age em conformidade no módulo japonês "Kibo", executa sua tarefa (por exemplo, localizar um objeto), depois envia as imagens e dados de posição ao CIMON.

A inovação reside no fato de que, até então, as imagens capturadas pelo Int-Ball2 só podiam ser transmitidas ao centro de controle de Tsukuba. A possibilidade de enviá-las em tempo real para outro robô a bordo abre um novo campo para interações robóticas distribuídas em ambiente orbital.

Um primeiro passo que ganha toda sua importância à luz das futuras missões lunares e marcianas.