W skrócie : Mistral AI wprowadził Magistral, model AI z ulepszonym wnioskowaniem, dostępny w wersji open source i dla przedsiębiorstw.

Podsumowanie

Pod koniec stycznia, gdy wszyscy skupiali uwagę na DeepSeek i jego modelu R1, Mistral AI wprowadzał cicho Small 3, zapowiadając rychłe nadejście modeli Mistral z ulepszonymi zdolnościami wnioskowania. To już się stało: po Small 3.1 zaprezentowanym w marcu, jednorożec właśnie ujawnił Magistral, swój pierwszy model wnioskowania na dużą skalę, dostępny w dwóch wariantach, jeden open source "Magistral Small", drugi zorientowany na przedsiębiorstwa, "Magistral Medium".

Dzięki Magistral, Mistral AI przechodzi na nowy poziom. Nie w wyścigu o rozmiar, ale w dążeniu do bardziej wyjaśnialnej AI, bardziej zakorzenionej w ludzkim wnioskowaniu i, co najważniejsze, lepiej dostosowanej do operacyjnych realiów przedsiębiorstw. Nowy model opiera się na postępach Small 3.1, obsługuje wiele języków, w tym angielski, francuski, hiszpański, niemiecki, włoski, arabski, rosyjski i uproszczony chiński. Wprowadza on wyraźny łańcuch wnioskowania, krok po kroku, który można śledzić, kwestionować i audytować w języku użytkownika.

Magistral Small

Mistral AI opublikował Magistral Small na licencji Apache 2.0, umożliwiając w ten sposób społeczności jego użycie, dostosowanie i wdrożenie do różnych przypadków użycia. Jest on dostępny do pobrania na https://huggingface.co/mistralai/Magistral-Small-2506 .

Ta wersja została zoptymalizowana dzięki nadzorowanemu dostrajaniu (SFT) opartemu na ścieżkach wnioskowania generowanych przez Magistral Medium podczas jego interakcji, a następnie wzmocniona przez nauczanie przez wzmocnienie (RLHF), aby poprawić jakość i spójność wnioskowania.

Zawierając, podobnie jak modele Small 3, 24 miliardy parametrów, Magistral Small, po kwantyfikacji, może być wdrożony na dostępnych konfiguracjach sprzętowych, takich jak PC działający z jednym GPU RTX 4090 lub Mac z pamięcią RAM 32 GB, co pozwala deweloperom na zachowanie kontroli nad swoimi wrażliwymi danymi bez polegania na scentralizowanej infrastrukturze chmurowej.

Magistral Medium

Ta odmiana jest wersją przedsiębiorczą Magistral. Bardziej wydajna, jest dostępna na platformie Le Chat de Mistral oraz za pośrednictwem API firmy. Obecnie wdrożona na Amazon SageMaker, wkrótce będzie dostępna na IBM WatsonX, Azure AI i Google Cloud Marketplace.

Według jednorożca, Flash Answers w Chat umożliwia drastyczne zmniejszenie opóźnienia odpowiedzi. Według niego, Magistral Medium osiąga prędkość przetwarzania do 10 razy większą niż wielu konkurentów.

Wydajność Magistral

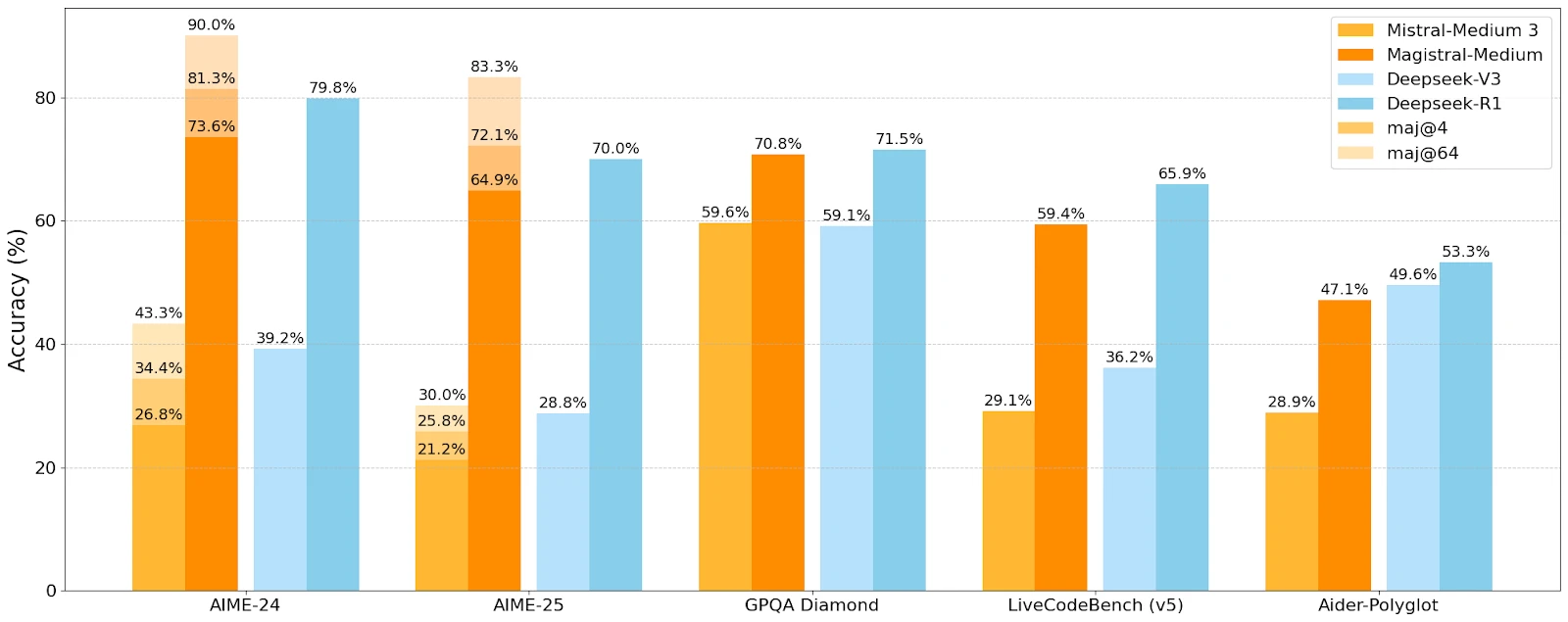

Mistral AI porównał wydajność Magistral z wydajnością Mistral Medium i konkurencyjnych modeli DeepSeek na różnych benchmarkach wnioskowania i zrozumienia.

Magistral-Medium przewyższa Mistral-Medium 3 na wszystkich benchmarkach, dowodząc skuteczności ulepszonego wnioskowania. Na benchmarkach AIME 2024, Medium osiąga wynik 73,6% przy 90% głosów większościowych, w porównaniu do 70,7% i 83,3% dla Small. Wyniki konkurencyjne, choć DeepSeek utrzymuje przewagę na niektórych benchmarkach.

Ukierunkowane przypadki użycia

Mistral AI celuje w przypadki użycia, gdzie kluczowe jest refleksyjne myślenie krok po kroku:

- Podejmowanie decyzji strategicznych

- Badania prawne

- Prognozowanie finansowe

- Wieloetapowe rozwijanie oprogramowania

- Pisanie narracyjne i generowanie treści

- Analiza regulacyjna i zgodność

Ta różnorodność sugeruje chęć penetracji zarówno sektorów regulowanych, jak i zawodów technicznych o wysokiej gęstości poznawczej, bez poświęcania otwartości na bardziej "kreatywne" zastosowania.