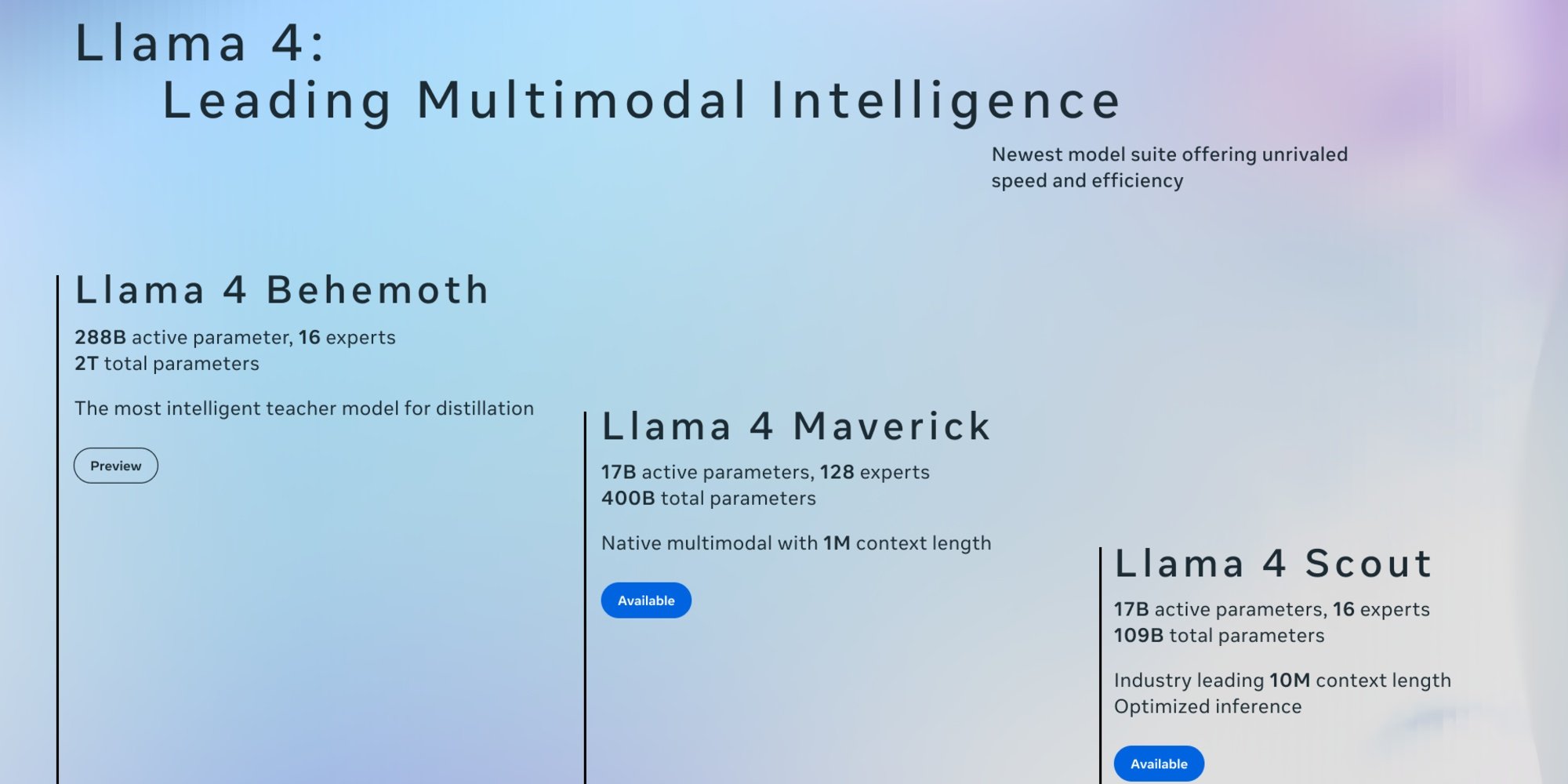

5 kwietnia Meta zaprezentowała dwie pierwsze wersje Llama 4: Scout i Maverick. Te otwarte modele, zaprojektowane do pracy w trybie natywnie multimodalnym, mogą przetwarzać tekst, obrazy i wideo. Dzięki procesowi destylacji opartemu na Llama 4 Behemoth, największym i najpotężniejszym modelu serii wciąż w fazie rozwoju, wyróżniają się szybkością działania i efektywnością.

W przeciwieństwie do poprzednich wersji Llama, które wykorzystywały architekturę opartą na Transformerach, Llama 4 opiera się na architekturze Mixture-of-Experts (MoE), gdzie tylko niektóre parametry są aktywowane dla każdej zapytania. Takie podejście poprawia efektywność i obniża koszty obliczeniowe, Scout i Maverick aktywują „zaledwie” 17 miliardów parametrów na zapytanie. Meta rozszerzyła również obsługę języków z 8 w Llama 3.3, zaprezentowanej w grudniu ubiegłego roku, do 12. Należy jednak zauważyć, że ich baza wiedzy kończy się w sierpniu 2024 roku.

Llama 4 Scout: nowatorskie okno kontekstowe

Scout z 109 miliardami parametrów jest najlżejszym modelem serii. Jego główną zaletą jest okno kontekstowe, które może osiągnąć do 10 milionów tokenów, co jest skokiem w porównaniu do 128 000 tokenów Llama 3. Dodając do tego fakt, że może działać na jednej karcie Nvidia H100, model jest szczególnie odpowiedni dla firm z ograniczonymi zasobami do takich zadań jak synteza wielodokumentowa czy dogłębna analiza działań użytkowników. Według wewnętrznych ocen Meta, Llama 4 Scout oferuje lepszą wydajność niż Gemma 3, Mistral 3.1 i Gemini 2.0 Flash Lite.

Llama 4 Maverick

Maverick, z kolei, posiada 400 miliardów parametrów i 128 ekspertów, co czyni go bardziej wydajnym. Z oknem kontekstowym wynoszącym 1 milion tokenów, otwiera drogę do takich aplikacji jak:

- Inteligentni agenci biznesowi, zdolni do rozumowania i interakcji w sposób bezpieczny z różnymi narzędziami i przepływami pracy;

- Systemy rozumienia dokumentów, ułatwiające ekstrakcję danych strukturalnych z PDF-ów, skanów i formularzy;

- Asystenci wielojęzyczni, oferujący odpowiedzi dostosowane do specyfiki kulturowej;

- Narzędzia do tworzenia dedykowane pisaniu historii, treści marketingowych i tekstów spersonalizowanych.

Według Meta, Maverick Llama 4 jest najlepszym modelem multimodalnym w swojej kategorii, przewyższając GPT-4o i Gemini 2.0 Flash w szerokim zakresie benchmarków. Osiąga również wyniki porównywalne do DeepSeek v3 w zakresie rozumowania i programowania, jednocześnie wykorzystując mniej niż połowę aktywnych parametrów.

Dodatkowo, Llama 4 Maverick oferuje wyjątkowy stosunek wydajności do kosztów, z eksperymentalną wersją czatu osiągającą wynik ELO 1417 na LMArena.

Llama 4 Behemoth

Meta zaprezentowała również Llama 4 Behemoth, model nauczyciela z 2 bilionami parametrów (2 000 miliardów), który posłużył jako podstawa dla tych dwóch pierwszych wersji. Zawierający 288 miliardów aktywnych parametrów z 16 ekspertami, oferuje najwyższą wydajność, choć nie jest modelem specjalizującym się w rozumowaniu. Według firmy, wyróżnia się w matematyce, wielojęzyczności i na benchmarkach obrazów.

Zgodnie z jego ocenami, Behemoth przewyższa GPT-4.5, Claude Sonnet 3.7 i Gemini 2.0 Pro na różnych benchmarkach.

Dostępność

Scout i Maverick są dostępne na Llama.com oraz Hugging Face, dystrybuowane jako open source na licencji Meta, która jednak wymaga, aby firmy posiadające ponad 700 milionów aktywnych użytkowników miesięcznie uzyskały zgodę na ich użycie. Llama 4 już teraz zasila Meta AI, asystenta AI na jej platformach WhatsApp, Messenger, Instagram w około czterdziestu krajach, ale funkcje multimodalne są obecnie dostępne tylko w Stanach Zjednoczonych. W UE trzeba będzie poczekać...