Wraz z rozwojem asystentów konwersacyjnych i wyszukiwarek napędzanych modelami językowymi, takimi jak ChatGPT, Claude czy Gemini, dokonuje się transformacja w sposobie, w jaki konsumenci odkrywają, oceniają i wchodzą w interakcję z markami. Adobe przewiduje tę zmianę, wprowadzając LLM Optimizer, rozwiązanie zaprojektowane, aby umożliwić firmom mierzenie, poprawę i zarządzanie swoją obecnością w środowiskach wyszukiwania zoptymalizowanych przez AI.

Klasyczne wyszukiwanie stopniowo ustępuje miejsca interakcjom z LLM, głęboko zmieniając logikę pozyskiwania ruchu dla marek. Wnioski z Adobe Analytics, oparte na rzeczywistych transakcjach online, pokazują wzrost o 3200% ruchu na stronach podróżniczych i 3500% na stronach detalicznych w USA między lipcem 2024 a majem 2025, pochodzącego ze źródeł AI generatywnej.

Loni Stark, wiceprezes ds. strategii i produktów w Adobe Experience Cloud, zapewnia:

"Interfejsy zasilane AI generatywną stają się kluczowymi punktami kontaktowymi na całej ścieżce klienta, od odkrywania po zaangażowanie i decyzję o zakupie. Dzięki Adobe LLM Optimizer umożliwiamy markom podejście do tego nowego środowiska z pewnością, zapewniając, że wyróżniają się i chwytają decydujące momenty".

LLM Optimizer pozwala na:

-

Mapowanie widoczności marki w odpowiedziach generatywnych;

-

Identyfikowanie możliwości tworzenia treści pozwalających na pojawienie się w rekomendacjach AI;

-

Optymalizację wydajności handlowej pochodzącej z tych nowych źródeł ruchu.

Jego działanie opiera się na trzech filarach:

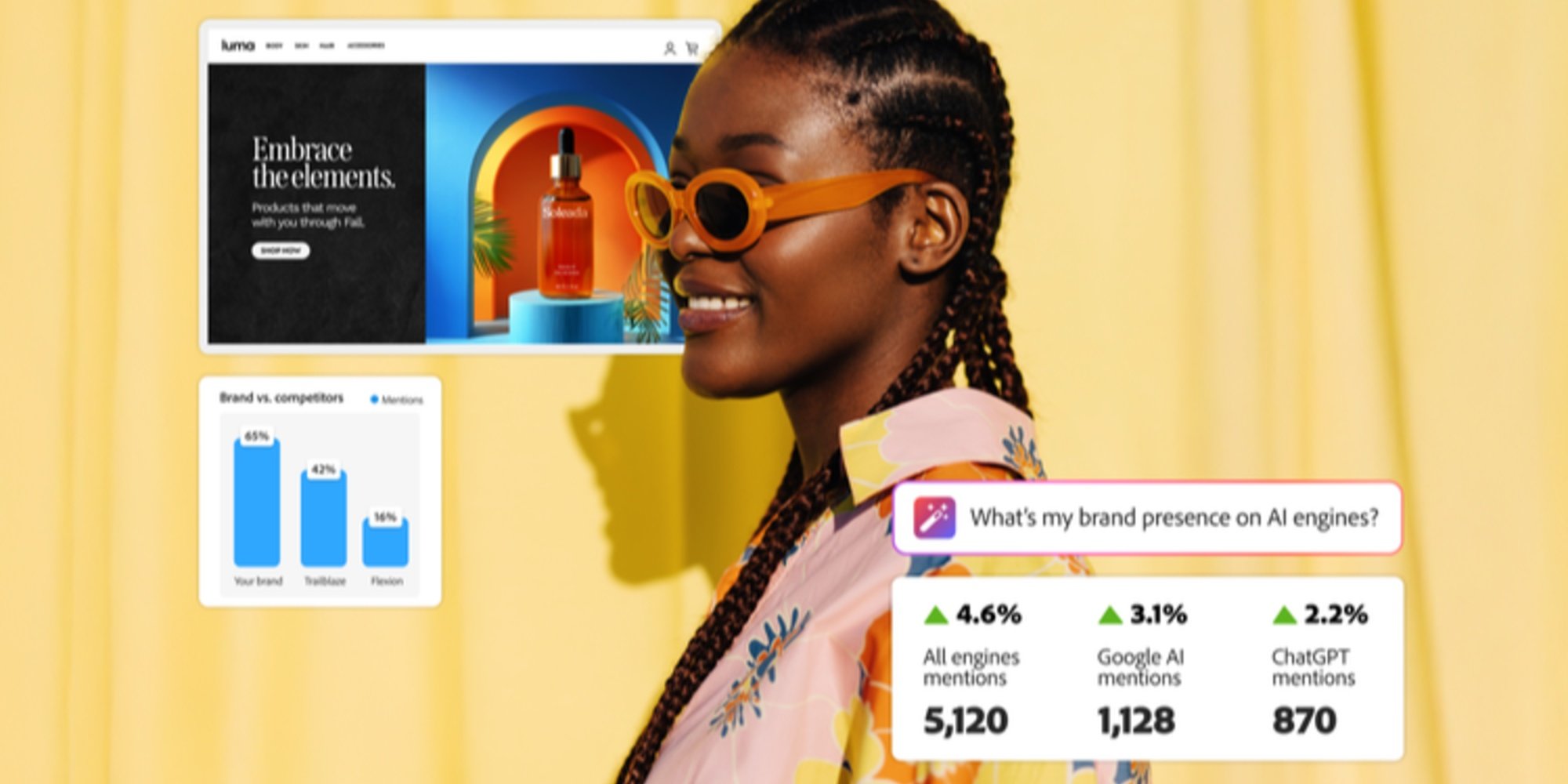

- Monitorowanie ruchu i widoczności w środowiskach AI: narzędzie wykrywa treści wykorzystywane przez asystentów konwersacyjnych do formułowania odpowiedzi, oferując markom wgląd w czasie rzeczywistym w ich obecność w tych interfejsach. Funkcjonalność benchmarkingowa pozwala mierzyć tę widoczność w porównaniu z konkurencją, szczególnie przy strategicznych zapytaniach o wysokiej wartości dodanej;

- Rekomendacje aktywowane zorientowane na wydajność: poza diagnozą, LLM Optimizer sugeruje konkretne działania: wzbogacenie FAQ, wyeksponowanie strony produktu, czy wzmocnienie obecności na platformach zewnętrznych, takich jak Wikipedia. Silnik rekomendacji opiera się na analizie atrybutów eksponowanych przez modele językowe (struktura, klarowność, niezawodność...) i łączy każdą rekomendację z kluczowymi wskaźnikami biznesowymi (ruch, zaangażowanie, konwersja);

- Szybkie wdrożenie poprzez integracje CMS lub API: zaprojektowany dla zespołów SEO, treści lub marketingu cyfrowego, LLM Optimizer integruje się z Adobe Experience Manager Sites, ale może również działać samodzielnie. Obsługuje emergentne protokoły, takie jak Agent-to-Agent (A2A) czy Model Context Protocol (MCP), co ułatwia jego wdrożenie w różnych środowiskach technicznych.

Ta zdolność do działania na treściach posiadanych (strony, FAQ) i zdobytych (Wikipedia, fora, bazy wiedzy) oferuje nową formę optymalizacji: proaktywną, kontekstualizowaną i dostosowaną do algorytmów syntezy.