In kort : De internationale missie "ICHIBAN" uitgevoerd door het Duitse ruimtevaartagentschap (DLR) en het Japanse agentschap voor lucht- en ruimtevaartonderzoek (JAXA) is erin geslaagd om twee robotassistenten aan boord van het ISS te laten communiceren en samenwerken. Deze prestatie, die perspectieven opent voor robotinteracties in een orbitale omgeving, is een belangrijke stap voor toekomstige maan- en Marsmissies.

Het Duitse ruimtevaartagentschap (DLR) en het Japanse agentschap voor lucht- en ruimtevaartonderzoek (JAXA) kondigen aan dat de internationale samenwerkingsmissie "ICHIBAN" een succes is geworden. Voor het eerst hebben twee robotassistenten van verschillende nationale programma's gecommuniceerd en samengewerkt in een baan om de aarde aan boord van het ISS.

Een van de doelstellingen van de ICHIBAN-missie (eerste in het Japans), die op 29 juli werd afgerond, was om de coördinatie te testen van meerdere verschillende robots die gelijktijdig en in real-time opereren aan boord van het ISS.

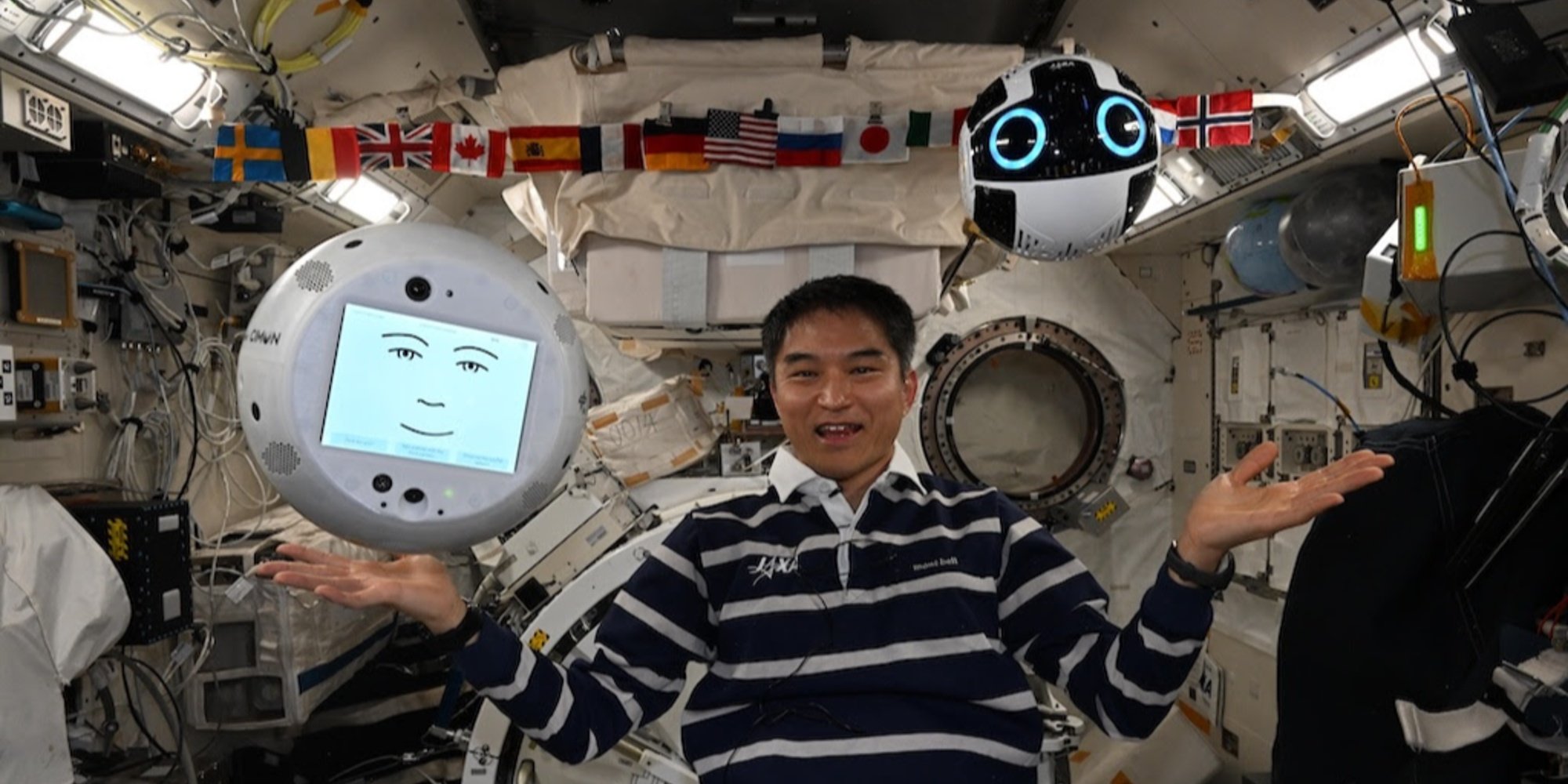

De twee robots die bij het experiment betrokken waren, zijn CIMON, ontwikkeld door het DLR, Airbus en IBM, en Int-Ball2, ontwikkeld door JAXA, die respectievelijk zijn geïnstalleerd in de Europese Columbus en de Japanse Kibo experimentmodules.

CIMON (Crew Interactive Mobile Companion), voor het eerst ingezet in 2018, is een bolvormige robot ter grootte van een bal, 3D-geprint, aangedreven door de spraak- en cognitieve technologieën van watsonx, het AI-platform van IBM. Tijdens de ICHIBAN-missie werd CIMON bediend door BIOTESC, het Zwitserse centrum van ESA dat gespecialiseerd is in wetenschappelijke operaties aan boord van het internationale station.

Int-Ball2 is een evolutie van de eerste cameradrone van JAXA. Sinds 2023 geïntegreerd in de Japanse module, stelt het de controle-eenheid op de grond in Tsukuba (Japan) in staat om op afstand de activiteiten van astronauten te filmen, waardoor de wetenschappelijke documentatie wordt geoptimaliseerd zonder dat de bemanning van het internationale ruimtestation wordt belast. Tot nu toe was er geen interactie met andere robots mogelijk.

De demonstratie werd uitgevoerd door Takuya Onishi, een astronaut van JAXA aan boord van het ISS. Vanuit de Columbus-module gaf hij spraakopdrachten aan CIMON, die als intelligente taalschakel fungeerde. De instructie werd verwerkt door het watsonx-platform van IBM, voordat deze werd omgezet in operationele opdrachten gericht aan Int-Ball2.

Deze laatste navigeerde vervolgens door de Kibo-module om verschillende verborgen objecten te zoeken en te lokaliseren: een Rubik's Cube, een hamer, verschillende schroevendraaiers en een buiten dienst gesteld oud model van de Int-Ball. Hij zond vervolgens live beelden naar het scherm van CIMON, waardoor Onishi hun positie op afstand visueel kon verifiëren.

Credit: JAXA/DLR;

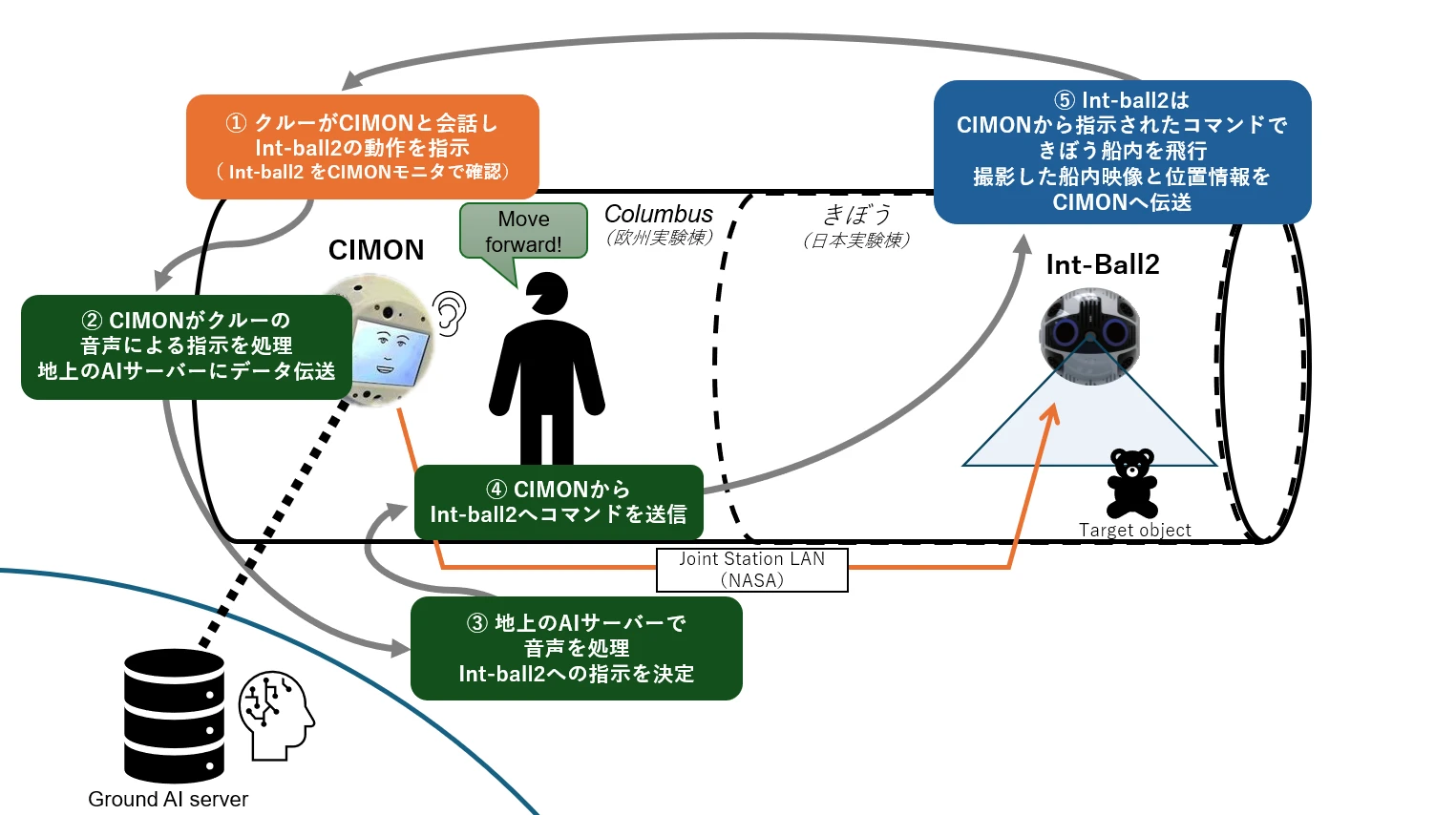

Illustratie Samenwerkingstabel van de ICHIBAN-missie

Illustratie Samenwerkingstabel van de ICHIBAN-missie

De astronaut geeft een spraakopdracht aan CIMON zodat Int-Ball2 een taak uitvoert (stap ①). CIMON verstuurt deze spraakopdracht naar een AI-server op de grond, die de intentie van de opdracht analyseert (stappen ② en ③). Instructieterugkoppeling naar het ISS: eenmaal verwerkt, wordt de opdracht vanaf de grond teruggestuurd via het LAN van het station (Joint Station LAN/NASA) naar CIMON, die het aan Int-Ball2 overdraagt (stap ④). Deze handelt vervolgens in de Japanse module "Kibo", voert zijn taak uit (bijvoorbeeld een object lokaliseren), en stuurt de beelden en positiedata terug naar CIMON.

De innovatie ligt in het feit dat, tot nu toe, de door Int-Ball2 vastgelegde beelden alleen konden worden verzonden naar het controlecentrum in Tsukuba. De mogelijkheid om ze in real-time naar een andere robot aan boord te sturen, opent nieuwe mogelijkheden voor gedistribueerde robotinteracties in een orbitale omgeving.

Een eerste stap die van groot belang is met het oog op toekomstige maan- en Marsmissies.