TLDR : La misión internacional "ICHIBAN" liderada por la agencia espacial alemana (DLR) y la agencia japonesa de exploración aeroespacial (JAXA) ha logrado comunicar y cooperar a dos robots de asistencia a los astronautas a bordo de la ISS. Esta hazaña, que abre perspectivas para las interacciones robóticas en entornos orbitales, es un avance significativo para las futuras misiones lunares y marcianas.

La agencia espacial alemana (DLR) y la Agencia Japonesa de Exploración Aeroespacial (JAXA) anuncian que la misión de cooperación internacional "ICHIBAN" ha sido un éxito. Por primera vez, dos robots de asistencia a los astronautas de programas nacionales distintos han comunicado y cooperado en órbita a bordo de la ISS.

Uno de los objetivos de la misión ICHIBAN (primera en japonés), que concluyó el pasado 29 de julio, era probar la coordinación de varios robots distintos operando simultáneamente y en tiempo real a bordo de la ISS.

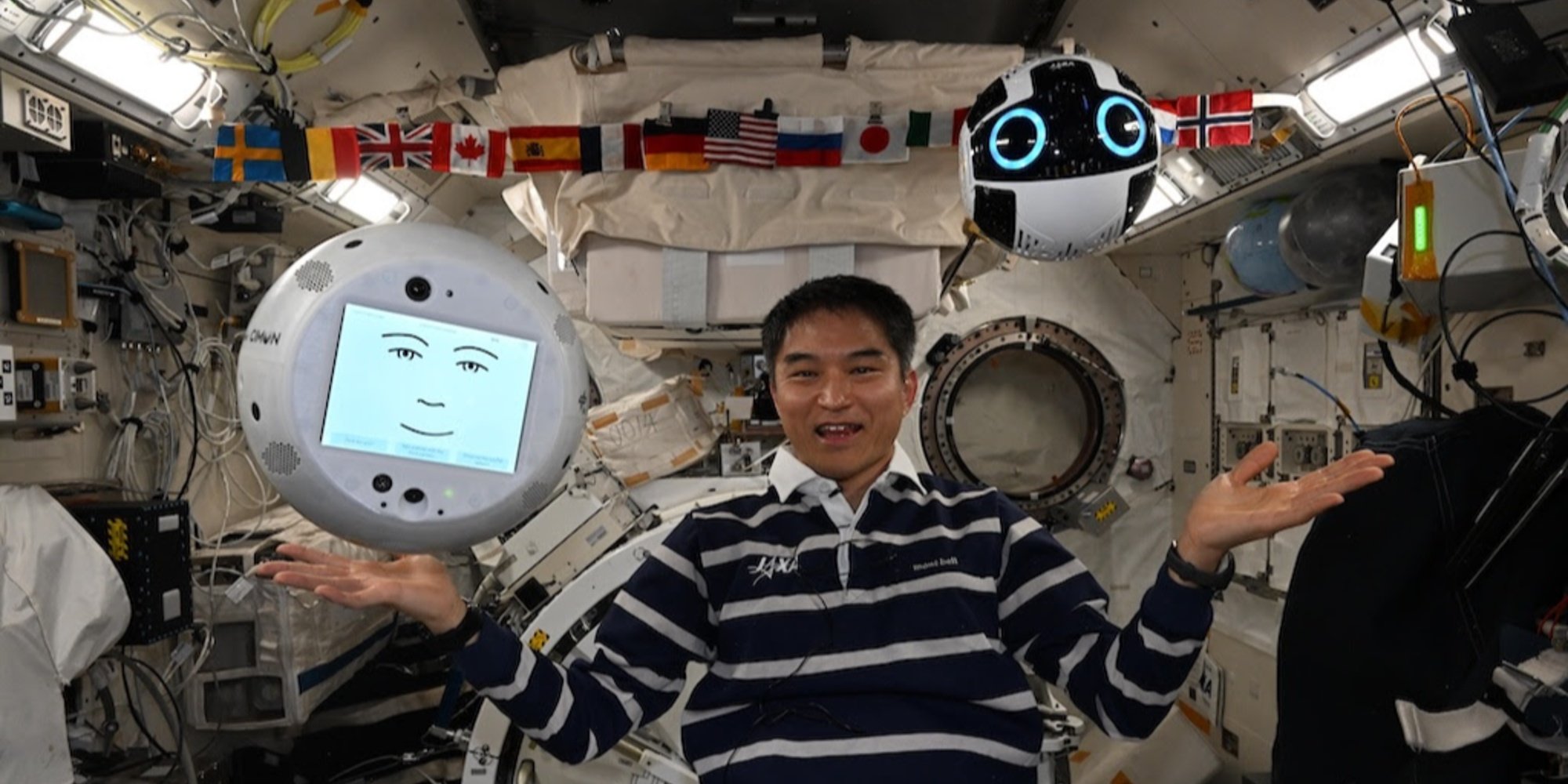

Los dos robots involucrados en la experiencia son CIMON, desarrollado por DLR, Airbus e IBM, e Int-Ball2, diseñado por la JAXA, instalados respectivamente en los módulos de experimentación europeo Columbus y japonés Kibo.

Desplegado por primera vez en 2018, CIMON (Crew Interactive Mobile Companion) es un robot esférico, del tamaño de una pelota, impreso en 3D, impulsado por las tecnologías vocales y cognitivas de watsonx, la plataforma IA de IBM. Durante la misión ICHIBAN, CIMON fue operado por BIOTESC, el centro suizo de la ESA especializado en operaciones científicas a bordo de la estación internacional.

Por su parte, Int-Ball2 es una evolución del primer dron cámara de la JAXA. Integrado desde 2023 en el módulo japonés, permite al centro de control en Tsukuba (Japón) grabar a distancia las actividades de los astronautas, optimizando así la documentación científica sin movilizar a la tripulación de la estación espacial internacional. Hasta ahora, no se había considerado la capacidad de interacción con otros robots.

La demostración fue llevada a cabo por Takuya Onishi, astronauta de la JAXA a bordo de la ISS. Desde el módulo Columbus, transmitió comandos verbales a CIMON, que sirvió de interfaz lingüística inteligente. La instrucción fue procesada por la plataforma watsonx de IBM, antes de ser traducida en comandos operacionales dirigidos a Int-Ball2.

Este último navegó en el módulo Kibo para buscar y localizar varios objetos ocultos: un Cubo de Rubik, un martillo, varios destornilladores y una versión antigua de Int-Ball fuera de servicio. Luego transmitió las imágenes en directo a la pantalla de CIMON, permitiendo a Onishi verificar visualmente su posición a distancia.

Crédito: JAXA/DLR;

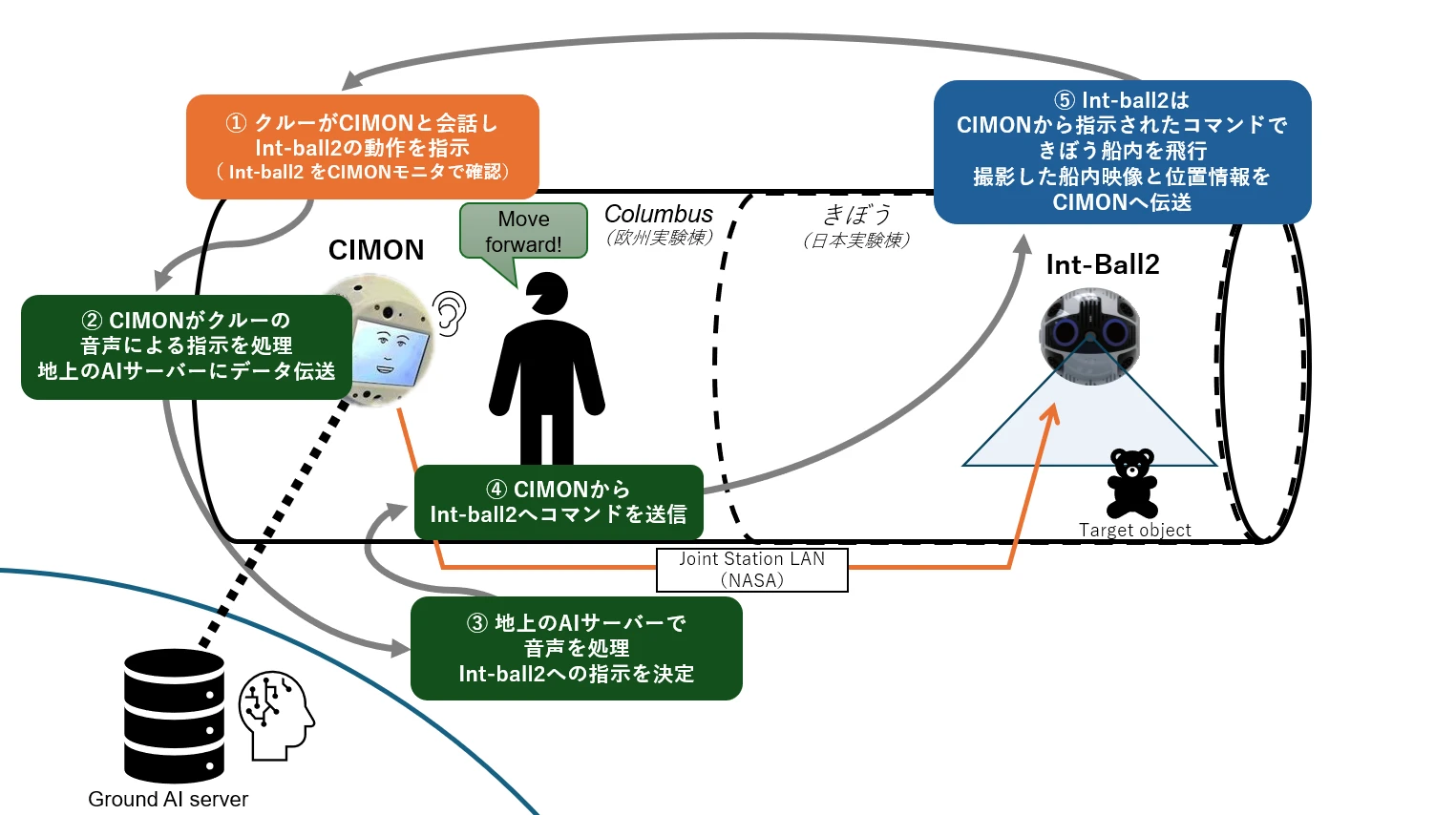

Ilustración del tablero de colaboración de la misión ICHIBAN

Ilustración del tablero de colaboración de la misión ICHIBAN

El astronauta da una instrucción verbal a CIMON para que Int-Ball2 realice una tarea (etapa ①). CIMON transmite este comando verbal a un servidor de IA situado en tierra, que analiza la intención del comando (etapas ② y ③). Retorno de instrucción hacia la ISS: una vez procesado, el comando es reenviado desde tierra a través de la LAN de la estación (Joint Station LAN/NASA) a CIMON, que lo transmite a Int-Ball2 (etapa ④). Este último actúa en consecuencia en el módulo japonés "Kibo", realiza su tarea (por ejemplo, localizar un objeto), y luego devuelve las imágenes y datos de posición a CIMON.

La innovación radica en el hecho de que, hasta ahora, las imágenes capturadas por Int-Ball2 solo podían ser transmitidas al centro de control de Tsukuba. La posibilidad de enviarlas en tiempo real a otro robot a bordo abre un nuevo campo para las interacciones robóticas distribuidas en entorno orbital.

Un primer paso que cobra toda su importancia a la luz de las futuras misiones lunares y marcianas.