Anthropic, fundada en 2021 por los hermanos Dario y Daniela Amodei, se ha convertido rápidamente en un actor principal en el campo de la inteligencia artificial generativa. Con un enfoque centrado en la seguridad, la fiabilidad y la interpretabilidad de los sistemas de IA, la empresa se destaca por su filosofía de IA constitucional, que busca inculcar valores y principios éticos inspirados en la Declaración Universal de los Derechos Humanos en sus modelos de lenguaje.

Áreas de especialización y logros principales

Anthropic ha desarrollado una familia de modelos de IA conocidos como Claude, que se caracterizan por su capacidad para responder de manera honesta y alineada con valores éticos. Estos modelos están diseñados para ser seguros y transparentes, enfrentando los crecientes desafíos de la IA moderna. Claude Opus 4 y Claude Sonnet 4, por ejemplo, son modelos optimizados para la programación y tareas complejas, destacándose por su rendimiento en benchmarks como SWE-bench y Terminal-bench.

Además, Anthropic ha introducido el concepto de "Claude Code", una herramienta de codificación agencial que permite a los desarrolladores automatizar tareas complejas directamente desde su terminal. Esta herramienta está diseñada para transformar las prácticas de desarrollo al ofrecer un asistente de IA capaz de buscar y modificar código, ejecutar pruebas e incluso enviar modificaciones en GitHub.

Contribuciones recientes y proyectos notables

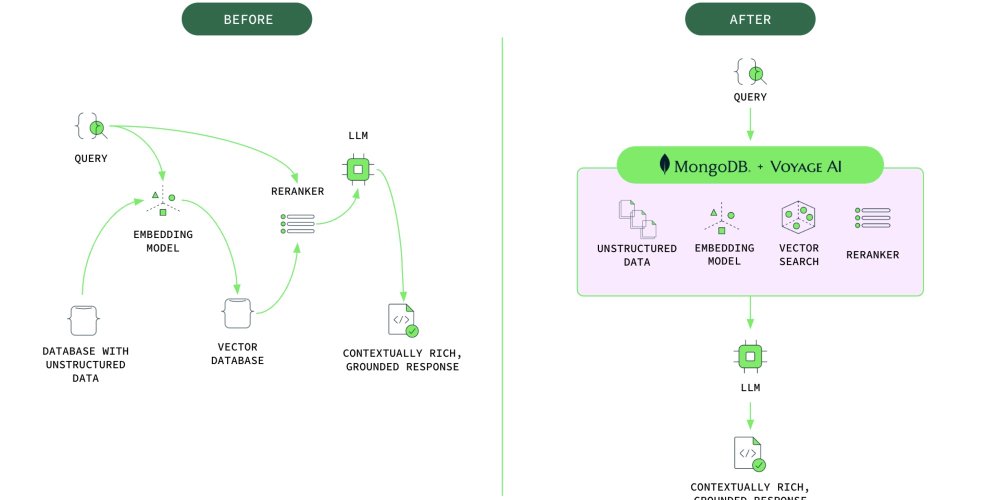

Entre los proyectos recientes notables, Anthropic ha presentado el "Model Context Protocol" (MCP), un estándar de código abierto destinado a conectar eficazmente los modelos de IA con los sistemas de datos existentes. Este protocolo facilita la integración de los modelos de IA en entornos profesionales variados al proporcionar un medio estandarizado para conectar los LLM al contexto que necesitan.

Anthropic también ha sido proactiva en la implementación de políticas de escalado responsable (RSP) para gestionar proactivamente los riesgos asociados con las IA avanzadas. Este enfoque ajusta las medidas de seguridad en función de las capacidades alcanzadas por los modelos, asegurando así una gestión proactiva y transparente de los riesgos potenciales.

Posición en el ecosistema tecnológico

En un mercado de IA en plena expansión, Anthropic se ha posicionado como un líder en materia de seguridad y ética de la IA. Como miembro fundador del Frontier Model Forum junto a Microsoft y Google, la empresa desempeña un papel clave en el desarrollo seguro y responsable de los modelos de IA avanzados. Se distingue por su compromiso con la transparencia y la responsabilidad, criterios cada vez más cruciales en el sector tecnológico.

Anthropic también ha beneficiado de asociaciones estratégicas con grandes actores como Google y Amazon, que han proporcionado importantes inversiones para apoyar sus innovaciones. Esta colaboración con gigantes tecnológicos no solo refuerza sus capacidades de desarrollo, sino también su presencia en el mercado global de la IA.

Desarrollos y noticias recientes

Las recientes mejoras de la familia Claude, especialmente Claude 3.5 Sonnet y Claude 3.5 Haiku, muestran avances significativos en materia de codificación y uso de herramientas. Estos modelos han sido elogiados por su capacidad para automatizar procesos complejos, demostrando una mejora notable en benchmarks como SWE-bench Verified y TAU-bench.

Además, la funcionalidad experimental "Computer Use" introducida por Anthropic permite a los modelos de IA interactuar con interfaces gráficas, marcando un paso adelante hacia capacidades de automatización más avanzadas. Esta innovación, aunque todavía en fase experimental, muestra el potencial de Anthropic para empujar los límites de la autonomía de los sistemas de IA.

En resumen, Anthropic se distingue por su compromiso con una IA ética y segura, mientras continúa innovando en el desarrollo de modelos de lenguaje avanzados. Su enfoque integrado de la seguridad y la interpretabilidad de los sistemas de IA le permite desempeñar un papel crucial en la definición de las normas futuras del sector.